NSXのTier0ゲートウェイでは、ダイナミックルーティングプロトコルとして、BGP、OSPFがサポートされていて、オーバーレイで作成したセグメントやスタティックルートの経路情報を広報することができます。

今回、ルートアドバタイズという機能を使用して、特定の経路情報を広報したり、広報させないといった制御を実施してみます。

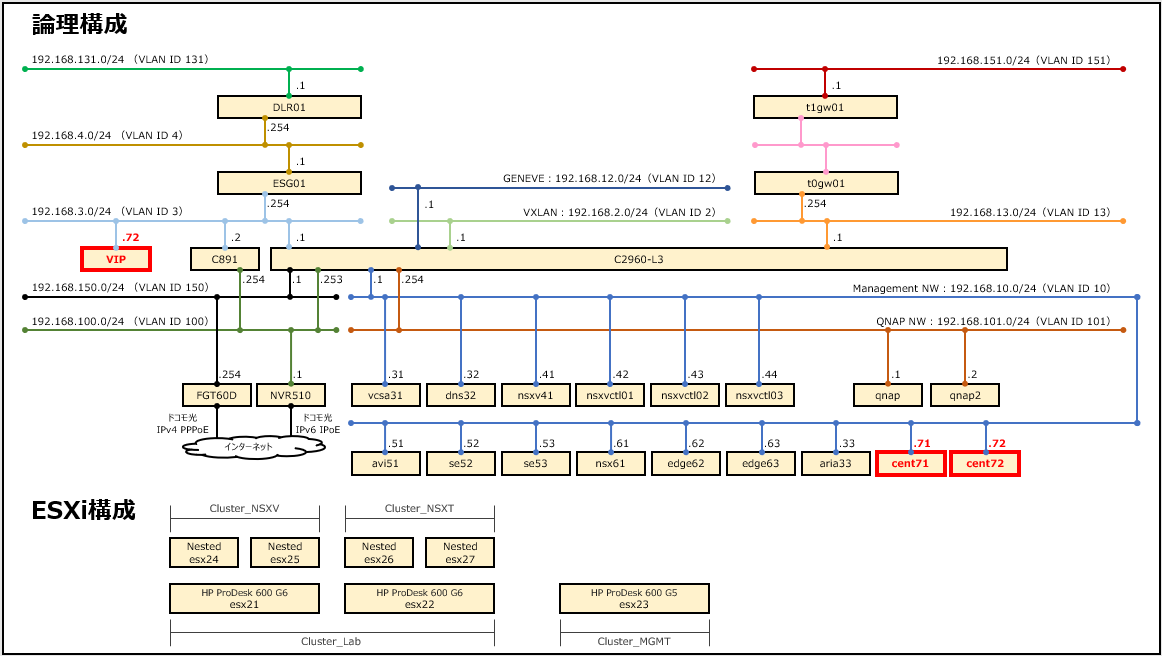

構成

ベースのネットワーク構成はこちらになります。

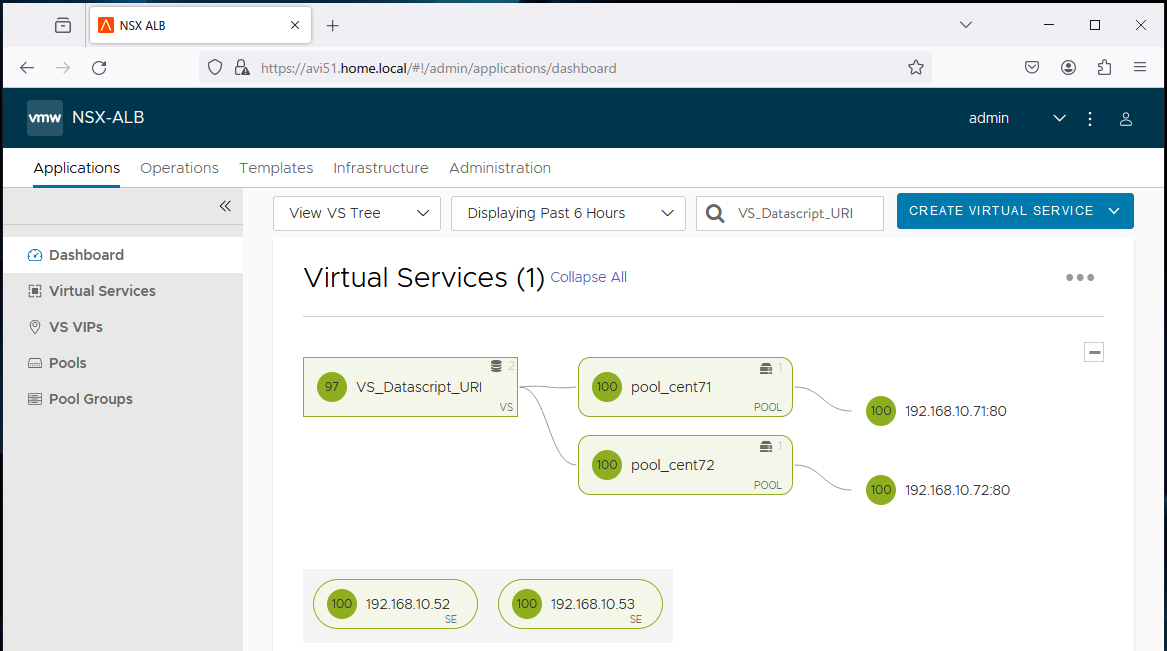

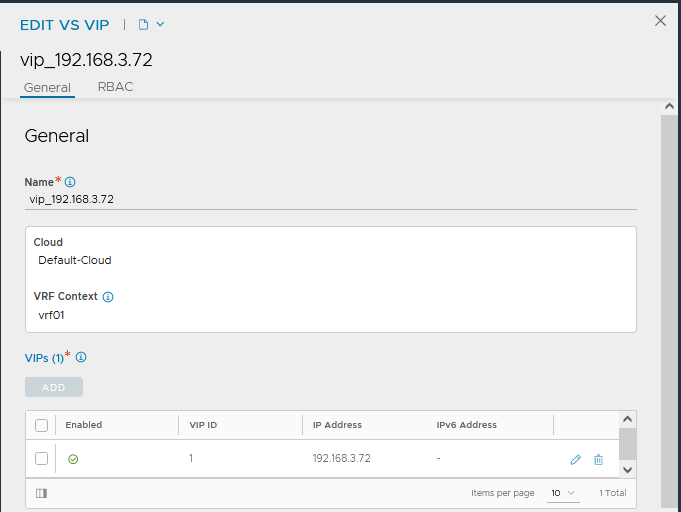

今回は、以下のようなシチュエーションを想定して設定します。

・BIG-IPで負荷分散用のVIPを仮想的に定義している。(VLANは定義していない)

・ACIからBIG-IPのVIP宛にスタティックを設定している。

・VIP2、VIP4をBIG-IPからNSXALBに移行し、BIG-IP、NSXALBのどちらのVIPにも通信可能とする。

実現したいこと

NSXALBでVIPセグメントを作成するとOSPFに広報されてしまうので、192.168.161.0/24の広報を停止する。

ただし、VIP2[.21]、VIP4[.41]への通信は行いたいので、/32で広報する。

併せて、VIPセグメントのGWアドレス[.1]、SEのI/Fアドレス[.2/.3を広報する。

設定変更前

Tier1でVIPセグメントを作成した状態で、OSPFで接続しているC891のルーティングテーブルを確認してみます。

192.168.161.0/24は、BIG-IP宛のスタティックによりOSPFの情報を受信してもルートテーブルにはのってきません。

ただし、show ip ospf databaseで確認すると、192.168.161.0/24はデータベース上には登録されています。

C891#sh ip route

Codes: L - local, C - connected, S - static, R - RIP, M - mobile, B - BGP

D - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter area

N1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2

E1 - OSPF external type 1, E2 - OSPF external type 2

i - IS-IS, su - IS-IS summary, L1 - IS-IS level-1, L2 - IS-IS level-2

ia - IS-IS inter area, * - candidate default, U - per-user static route

o - ODR, P - periodic downloaded static route, H - NHRP, l - LISP

a - application route

+ - replicated route, % - next hop override, p - overrides from PfR

Gateway of last resort is 192.168.100.1 to network 0.0.0.0

S* 0.0.0.0/0 [1/0] via 192.168.100.1

192.168.3.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.3.0/24 is directly connected, Vlan3

L 192.168.3.2/32 is directly connected, Vlan3

192.168.13.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.13.0/24 is directly connected, Vlan13

L 192.168.13.2/32 is directly connected, Vlan13

192.168.100.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.100.0/24 is directly connected, Vlan100

L 192.168.100.254/32 is directly connected, Vlan100

O E2 192.168.151.0/24 [110/20] via 192.168.13.63, 02:07:28, Vlan13

[110/20] via 192.168.13.62, 02:08:25, Vlan13

S 192.168.161.0/24 [1/0] via 192.168.3.1 ★

C891#

C891#sh ip os database

OSPF Router with ID (192.168.100.254) (Process ID 10)

Router Link States (Area 0)

Link ID ADV Router Age Seq# Checksum Link count

192.168.13.62 192.168.13.62 862 0x80000007 0x003378 1

192.168.13.63 192.168.13.63 792 0x80000007 0x003177 1

192.168.100.254 192.168.100.254 1783 0x80000185 0x0006BE 3

Net Link States (Area 0)

Link ID ADV Router Age Seq# Checksum

192.168.13.2 192.168.100.254 1783 0x80000005 0x00F4C0

Type-5 AS External Link States

Link ID ADV Router Age Seq# Checksum Tag

0.0.0.0 192.168.100.254 533 0x80000134 0x00AFF8 10

192.168.151.0 192.168.13.62 922 0x80000005 0x00FD47 4016

192.168.151.0 192.168.13.63 832 0x80000005 0x00F74C 4016

192.168.161.0 192.168.13.62 540 0x80000002 0x0095A8 4016 ★

192.168.161.0 192.168.13.63 516 0x80000002 0x008FAD 4016 ★

C891#

Tier0ゲートウェイの設定

[ネットワーク]-[Tier0ゲートウェイ]から「t0gw01」の左にある3点マークを選択する。

編集を選択する。

ルート再配分の「1」を選択する。

ルート再配分の設定から、「redistribute-route」の左にある3点マークを選択する。

編集を選択する。

ルート再配分の「1」を選択する。

アドバタイズされたTier1サブネットの中にある「スタティックルート」にチェックを入れ、適用を選択する。

追加を選択する。

適用を選択する。

保存を選択する。

Tier1ゲートウェイの設定

[ネットワーク]-[Tier1ゲートウェイ]から「t1gw01」の左にある3点マークを選択する。

編集を選択する。

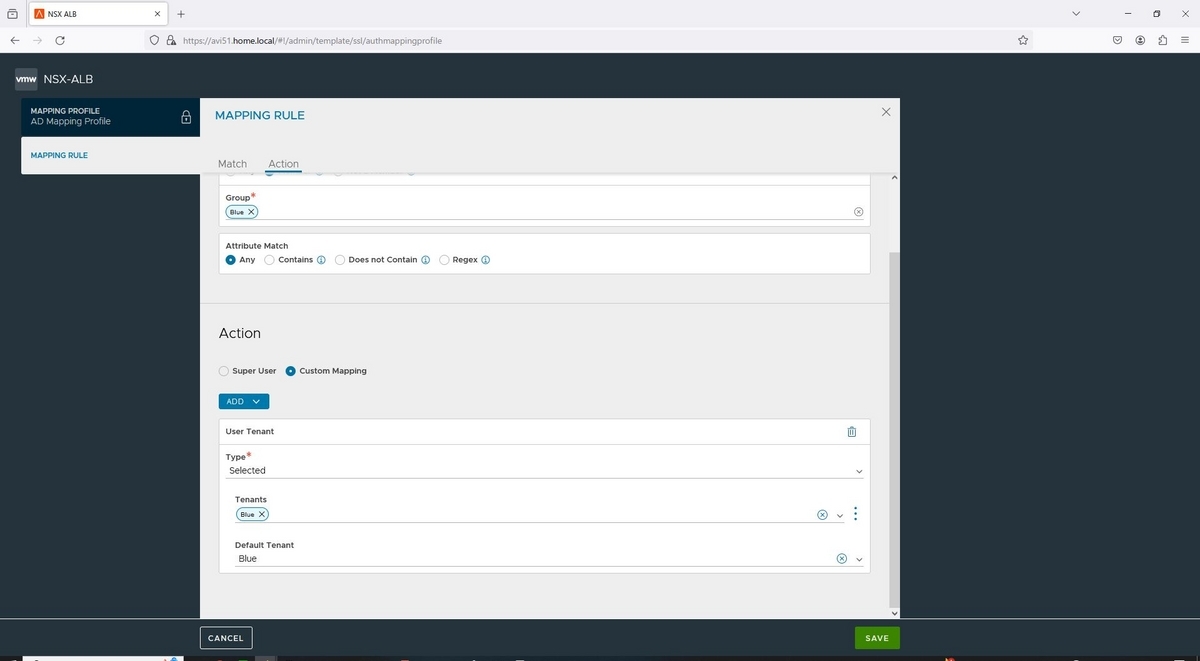

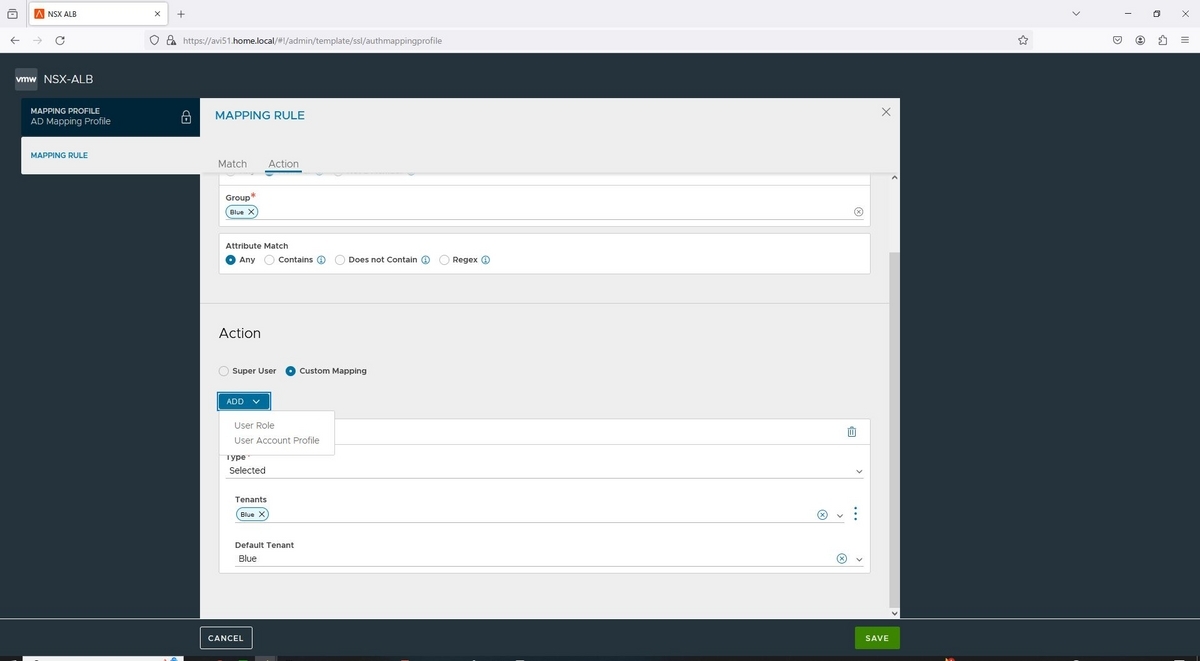

ルートアドバタイズから、「ルートアドバタイズルールの設定」にある「設定」を選択する。

「ルートアドバタイズルールの設定」から、「ルートアドバタイズルールの追加」を選択する。

以下の情報を入力し、「追加」を選択する。

ここでは、アドバタイズアクションを「拒否」とすることで、経路情報を広報しなくなります。

名前:192.168.161.0/24

サブネット:192.168.161.0/24

フィルタの適用:有効

アドバタイズアクション:拒否

再度「ルートアドバタイズルールの追加」を選択し、以下の情報を順番に登録して適用を選択する。

名前:192.168.161.1/32

サブネット:192.168.161.1/32

フィルタの適用:無効

名前:192.168.161.2/32

サブネット:192.168.161.2/32

フィルタの適用:無効

名前:192.168.161.3/32

サブネット:192.168.161.3/32

フィルタの適用:無効

名前:VIP2_192.168.161.21/32

サブネット:192.168.161.21/32

フィルタの適用:無効

名前:VIP4_192.168.161.41/32

サブネット:192.168.161.41/32

フィルタの適用:無効

保存を選択する。

動作確認

C891にてルーティングテーブルを確認しましょう。

192.168.161.1~3、21、41の経路情報をO E2で受信していることが確認できました。

また、show ip ospf databaseでは、192.168.161.0/24の経路情報が広報されていないことが確認駅ました。

C891#sh ip route

Codes: L - local, C - connected, S - static, R - RIP, M - mobile, B - BGP

D - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter area

N1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2

E1 - OSPF external type 1, E2 - OSPF external type 2

i - IS-IS, su - IS-IS summary, L1 - IS-IS level-1, L2 - IS-IS level-2

ia - IS-IS inter area, * - candidate default, U - per-user static route

o - ODR, P - periodic downloaded static route, H - NHRP, l - LISP

a - application route

+ - replicated route, % - next hop override, p - overrides from PfR

Gateway of last resort is 192.168.100.1 to network 0.0.0.0

S* 0.0.0.0/0 [1/0] via 192.168.100.1

192.168.3.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.3.0/24 is directly connected, Vlan3

L 192.168.3.2/32 is directly connected, Vlan3

192.168.13.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.13.0/24 is directly connected, Vlan13

L 192.168.13.2/32 is directly connected, Vlan13

192.168.100.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.100.0/24 is directly connected, Vlan100

L 192.168.100.254/32 is directly connected, Vlan100

O E2 192.168.151.0/24 [110/20] via 192.168.13.63, 02:40:16, Vlan13

[110/20] via 192.168.13.62, 02:41:13, Vlan13

192.168.161.0/24 is variably subnetted, 6 subnets, 2 masks

S 192.168.161.0/24 [1/0] via 192.168.3.1 ★

O E2 192.168.161.1/32 [110/20] via 192.168.13.63, 00:09:05, Vlan13 ★

[110/20] via 192.168.13.62, 00:09:05, Vlan13 ★

O E2 192.168.161.2/32 [110/20] via 192.168.13.63, 00:09:05, Vlan13 ★

[110/20] via 192.168.13.62, 00:09:05, Vlan13 ★

O E2 192.168.161.3/32 [110/20] via 192.168.13.63, 00:09:05, Vlan13 ★

[110/20] via 192.168.13.62, 00:09:05, Vlan13 ★

O E2 192.168.161.21/32 [110/20] via 192.168.13.63, 00:09:05, Vlan13 ★

[110/20] via 192.168.13.62, 00:09:05, Vlan13 ★

O E2 192.168.161.41/32 [110/20] via 192.168.13.63, 00:09:05, Vlan13 ★

[110/20] via 192.168.13.62, 00:09:05, Vlan13 ★

C891#

C891#sh ip os da

OSPF Router with ID (192.168.100.254) (Process ID 10)

Router Link States (Area 0)

Link ID ADV Router Age Seq# Checksum Link count

192.168.13.62 192.168.13.62 1221 0x80000008 0x003179 1

192.168.13.63 192.168.13.63 1134 0x80000008 0x002F78 1

192.168.100.254 192.168.100.254 1877 0x80000186 0x0004BF 3

Net Link States (Area 0)

Link ID ADV Router Age Seq# Checksum

192.168.13.2 192.168.100.254 1877 0x80000006 0x00F2C1

Type-5 AS External Link States

Link ID ADV Router Age Seq# Checksum Tag

0.0.0.0 192.168.100.254 608 0x80000135 0x00ADF9 10

192.168.151.0 192.168.13.62 1281 0x80000006 0x00FB48 4016

192.168.151.0 192.168.13.63 1210 0x80000006 0x00F54D 4016

192.168.161.1 192.168.13.62 682 0x80000001 0x0069D6 4014 ★

192.168.161.1 192.168.13.63 682 0x80000001 0x0063DB 4014 ★

192.168.161.2 192.168.13.62 682 0x80000001 0x005FDF 4014 ★

192.168.161.2 192.168.13.63 682 0x80000001 0x0059E4 4014 ★

192.168.161.3 192.168.13.62 682 0x80000001 0x0055E8 4014 ★

192.168.161.3 192.168.13.63 682 0x80000001 0x004FED 4014 ★

192.168.161.21 192.168.13.62 682 0x80000001 0x00A08B 4014 ★

192.168.161.21 192.168.13.63 682 0x80000001 0x009A90 4014 ★

192.168.161.41 192.168.13.62 682 0x80000001 0x00D740 4014 ★

192.168.161.41 192.168.13.63 682 0x80000001 0x00D145 4014 ★

C891#

これで、移行したVIP2、VIP4宛はOSPFでTier0へルーティングされ、それ以外の経路は、今まで通りスタティックによりBIG-IPへルーティングできることが確認できました。