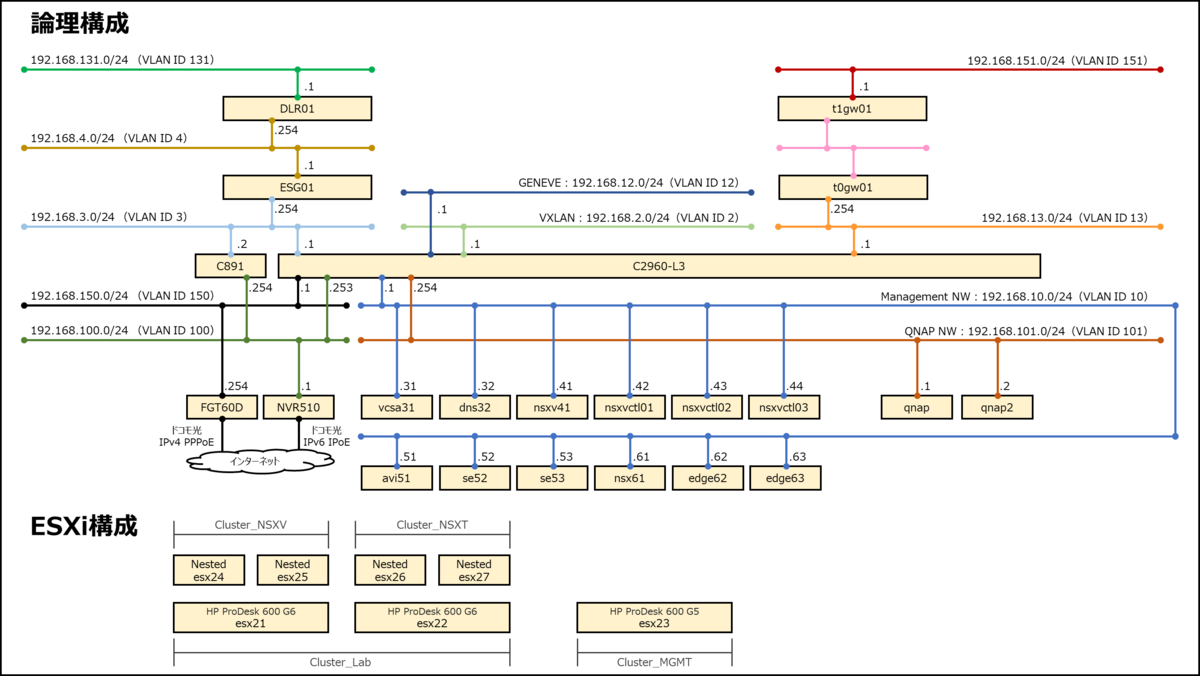

ここからは、NSX-Vのオーバーレイネットワークを構築していきます。

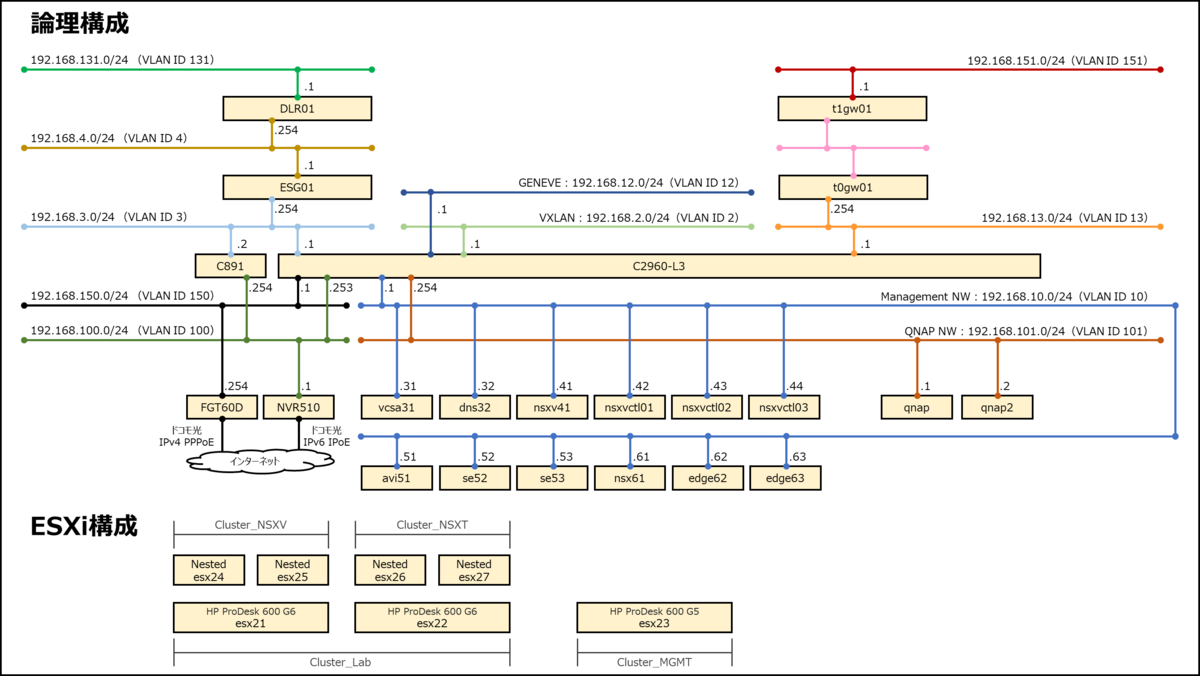

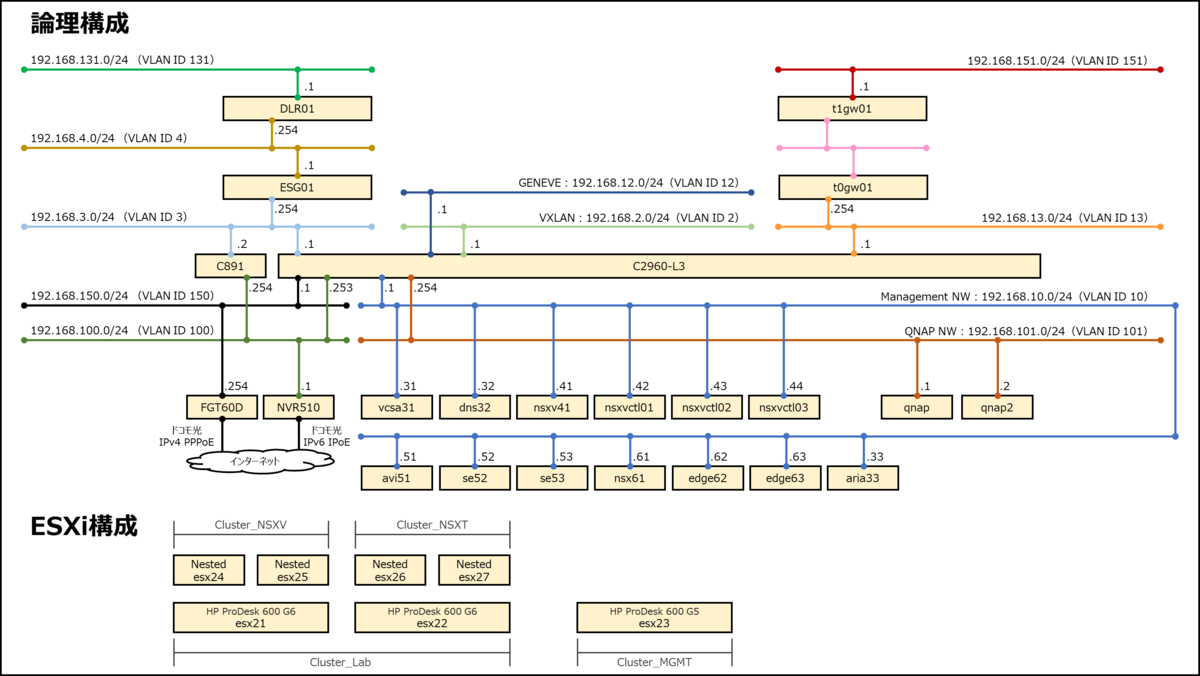

ネットワーク構成

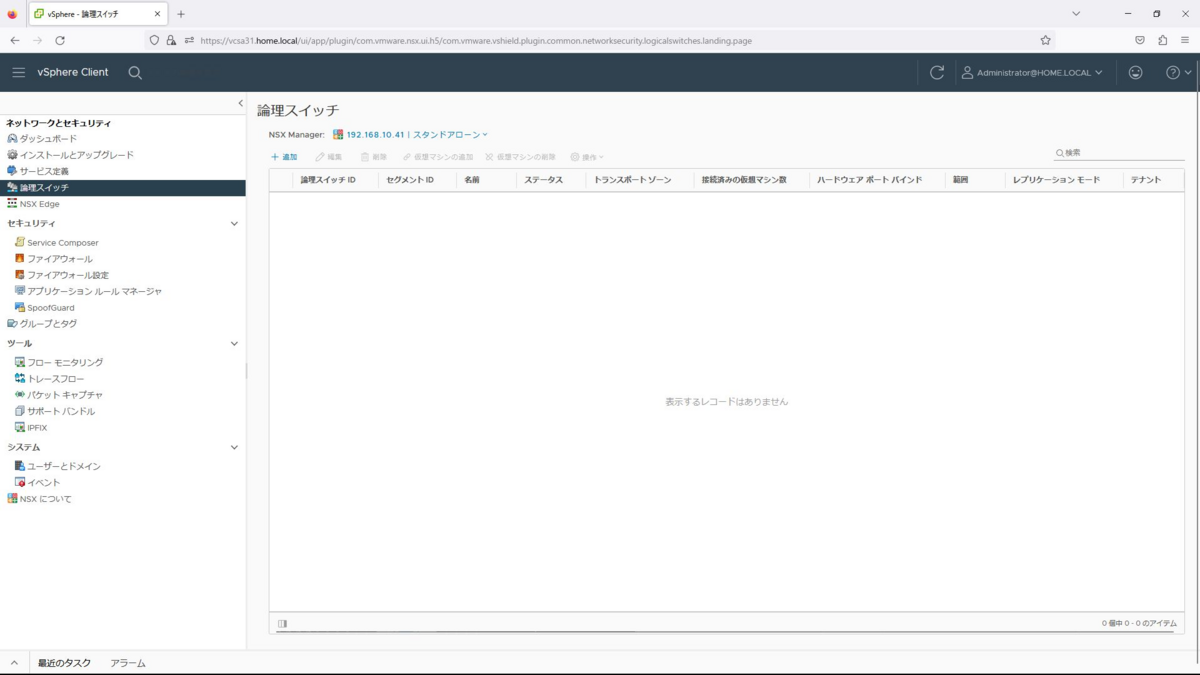

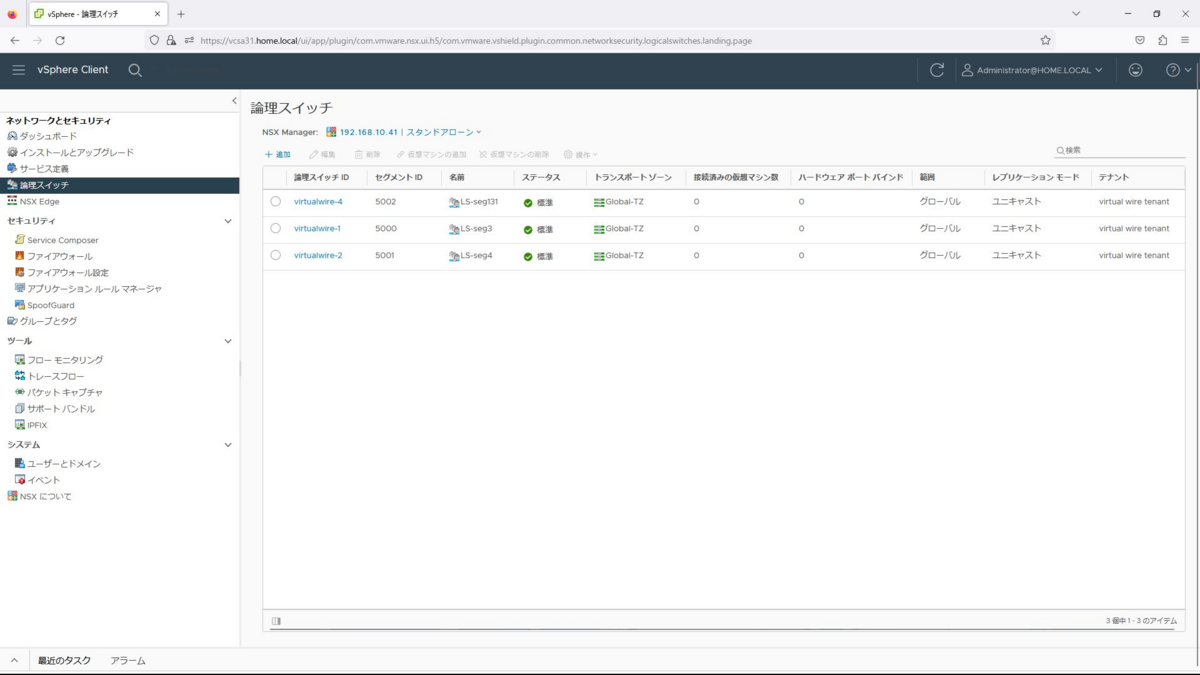

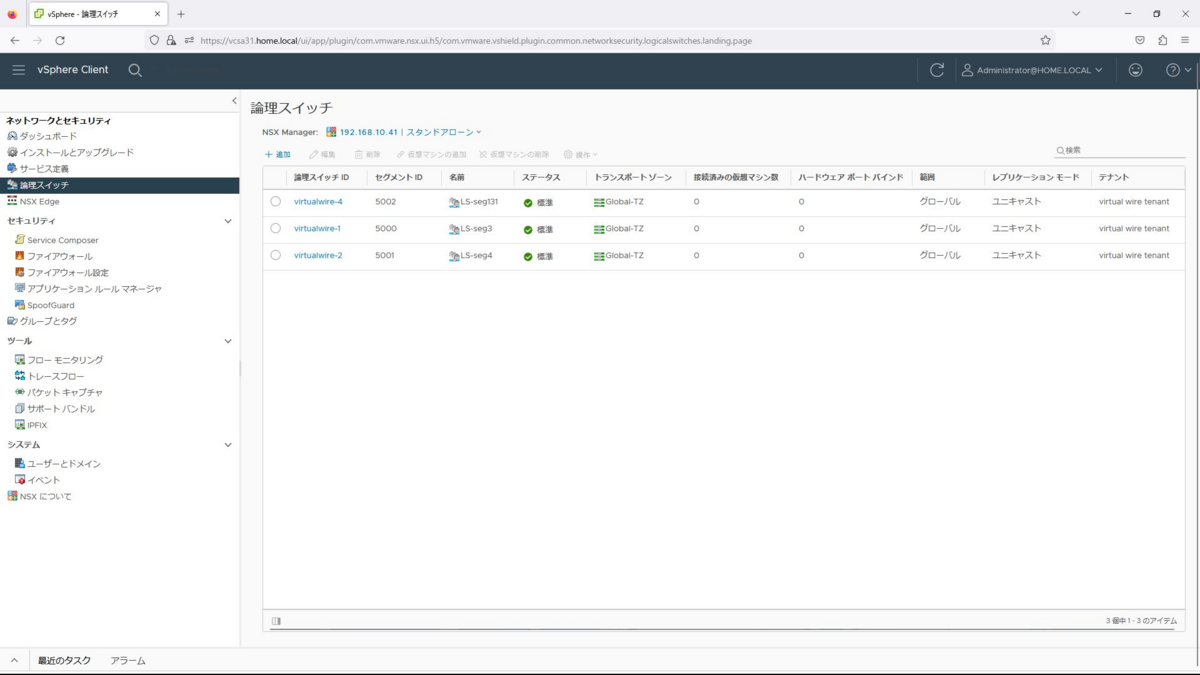

論理スイッチの作成

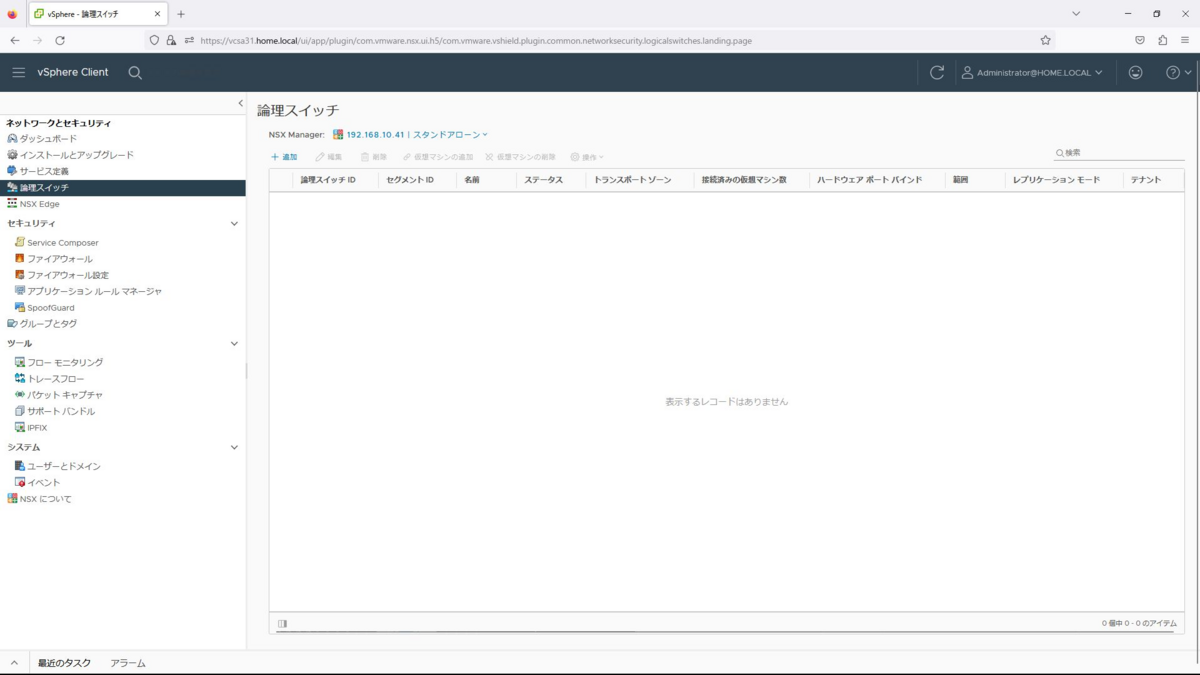

まず最初に、各セグメントの論理スイッチを作成していきます。

ここでは、この後作成するESGのアップリンク側と内部ネットワーク側の2つを作成します。

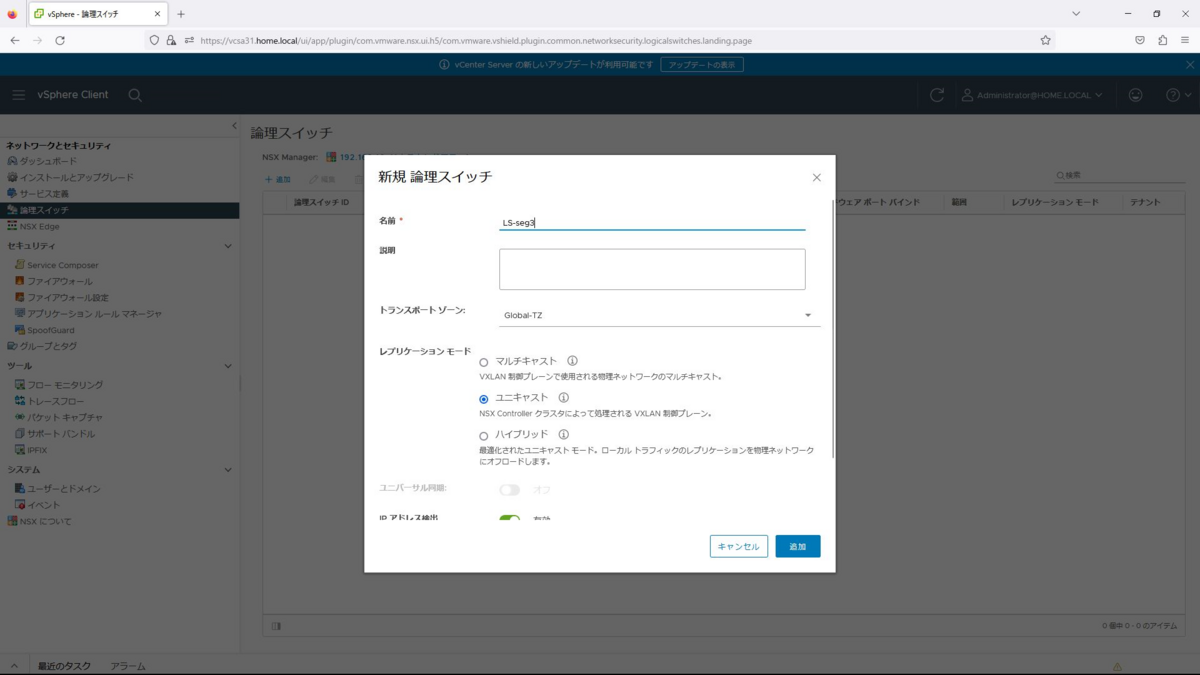

メニューの[ネットワークとセキュリティ]ー[論理スイッチ]から、「追加」を選択します。

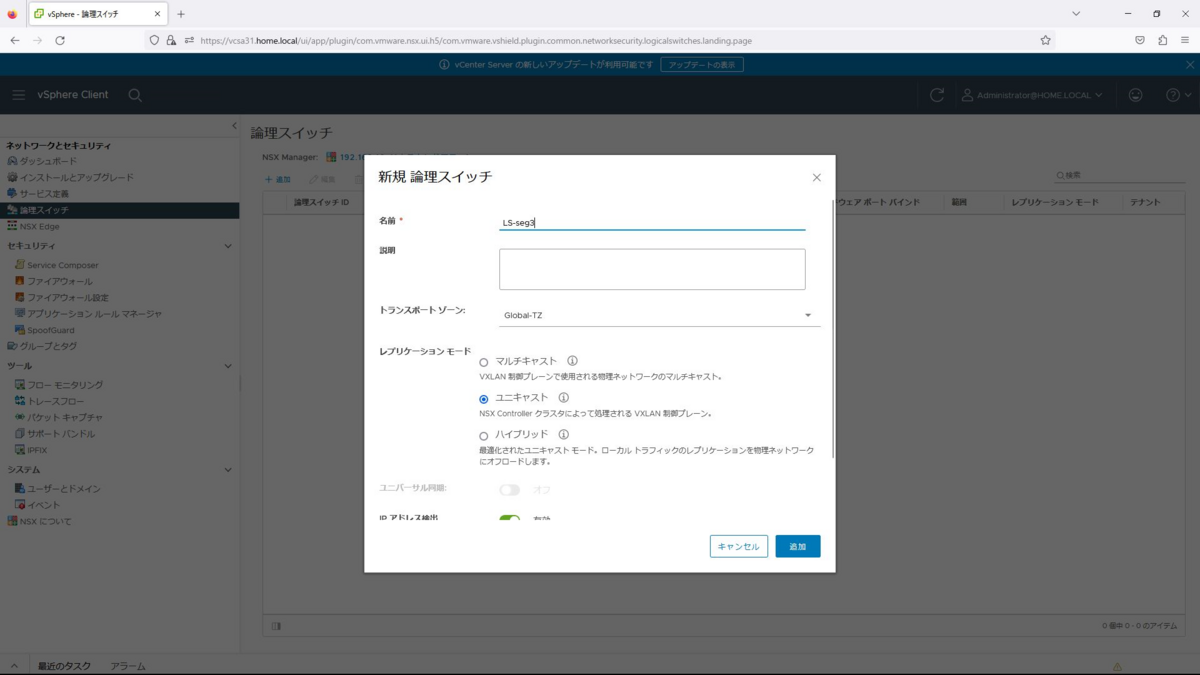

論理スイッチで以下の情報を入力します。

名前:LS-seg3

トランスポートゾーン:Global-TZ

レプリケーションモード:ユニキャスト

IPアドレス検出:有効

MACラーニング:有効

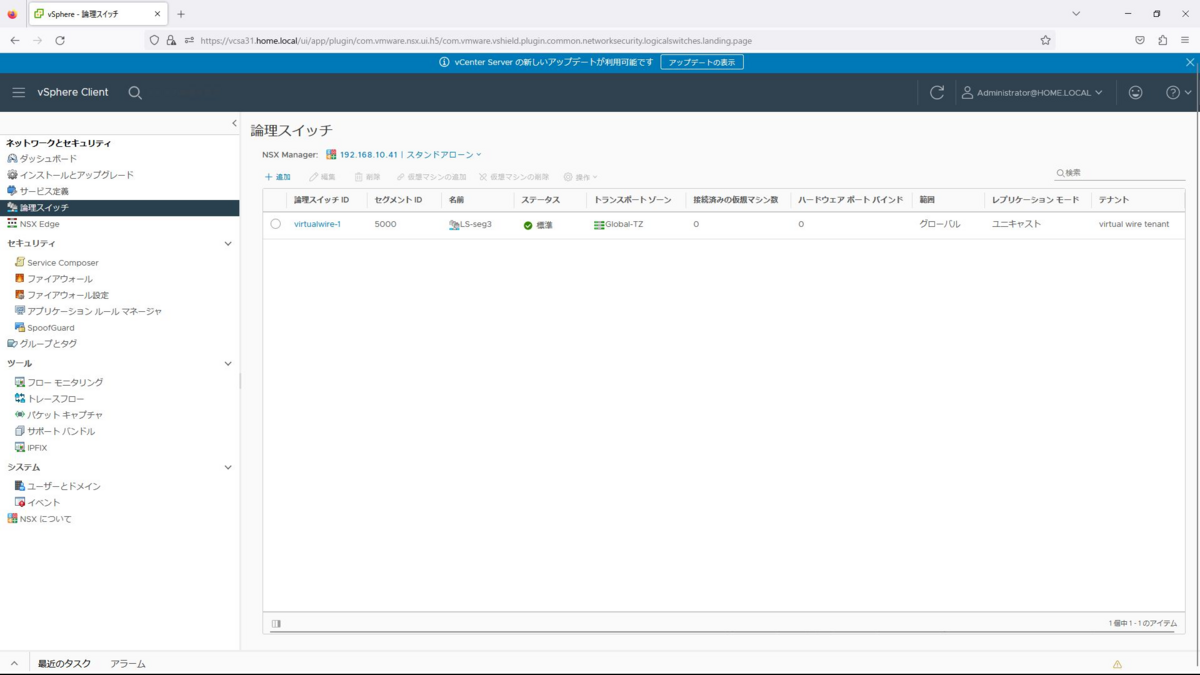

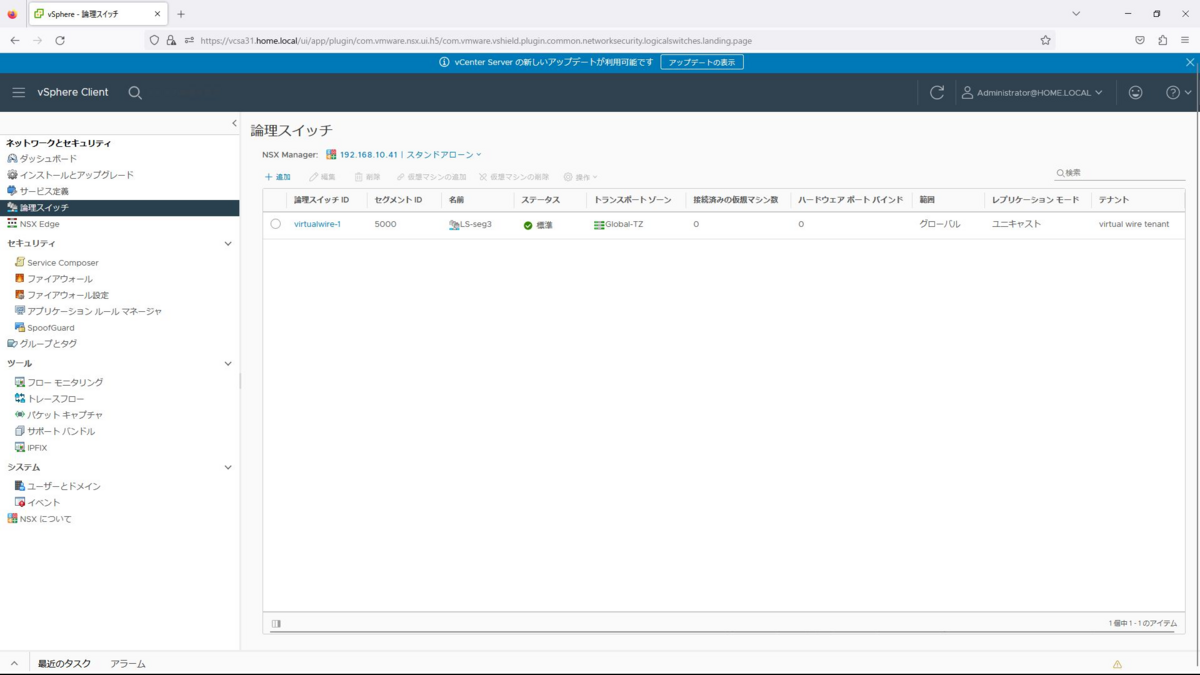

同様に、LS-seg4、LS-seg131も作成します。

名前:LS-seg4

トランスポートゾーン:Global-TZ

レプリケーションモード:ユニキャスト

IPアドレス検出:有効

MACラーニング:有効

名前:LS-seg131

トランスポートゾーン:Global-TZ

レプリケーションモード:ユニキャスト

IPアドレス検出:有効

MACラーニング:有効

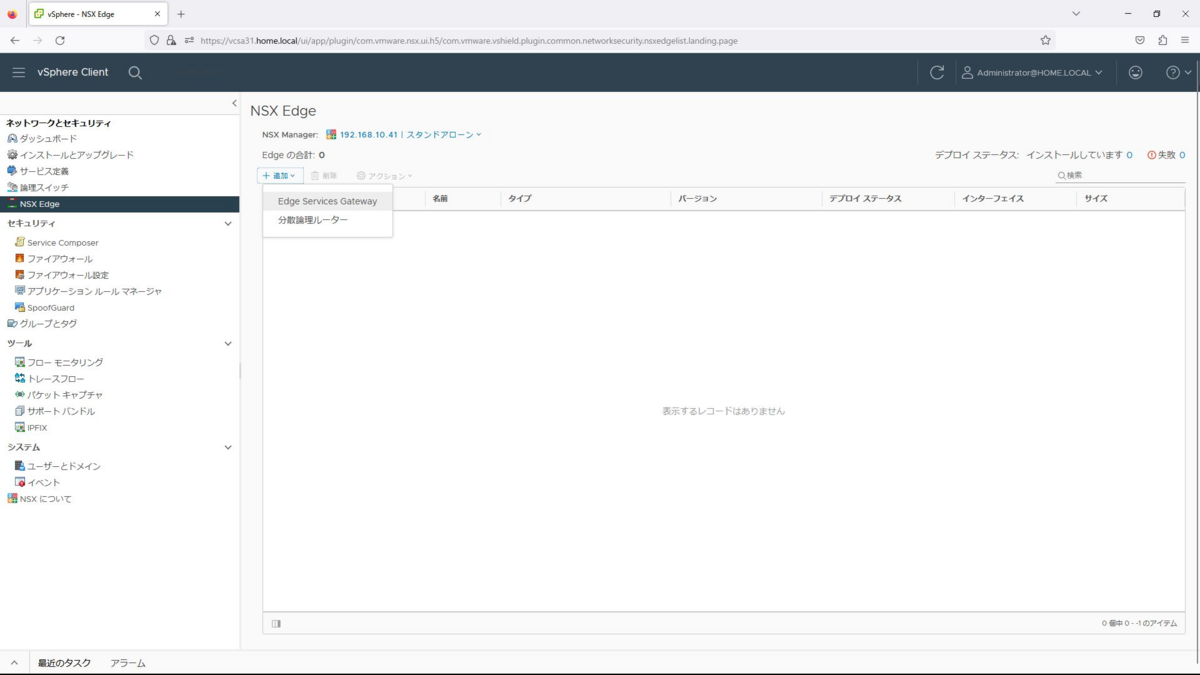

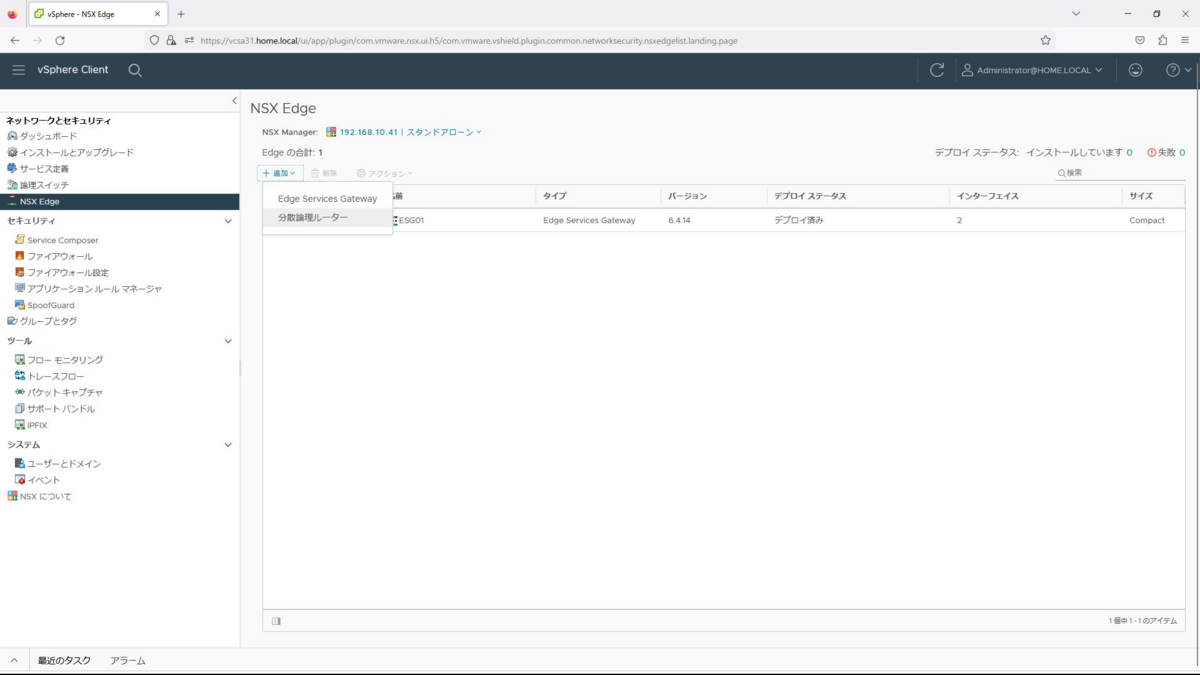

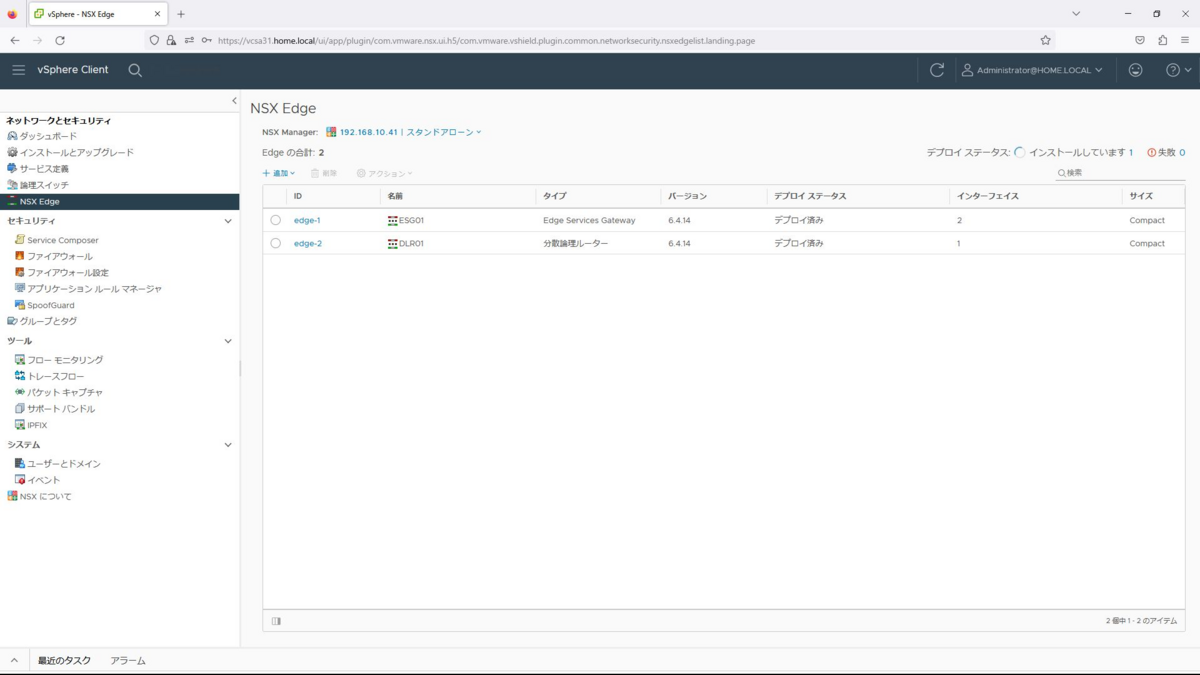

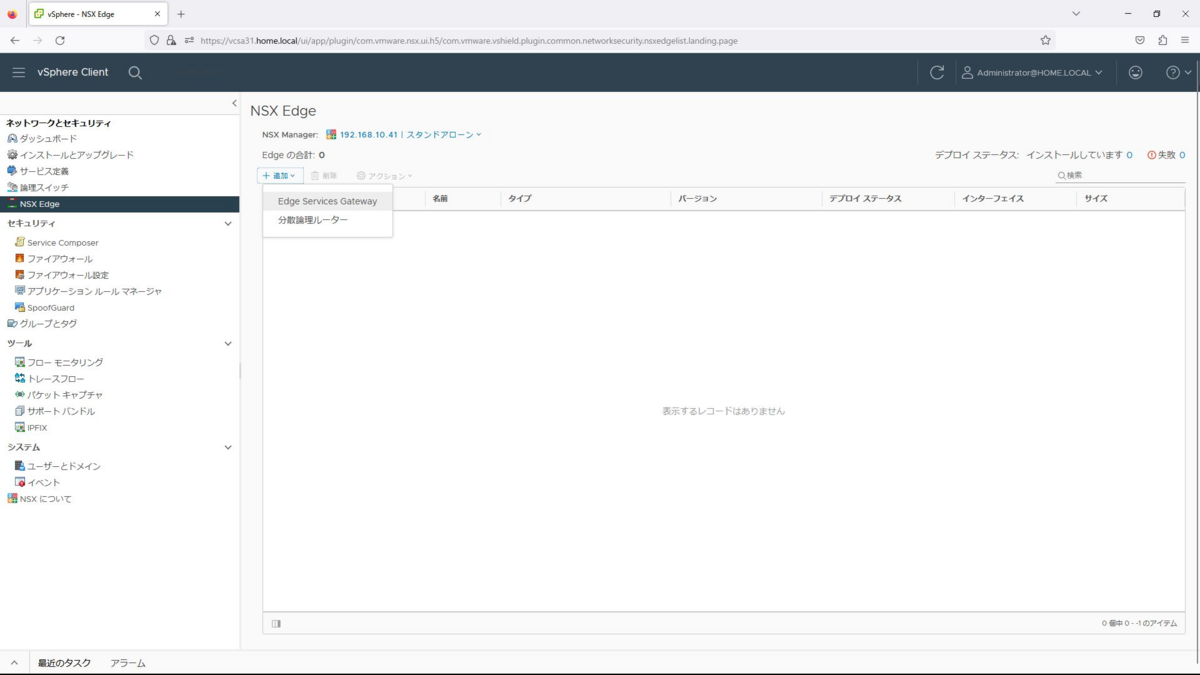

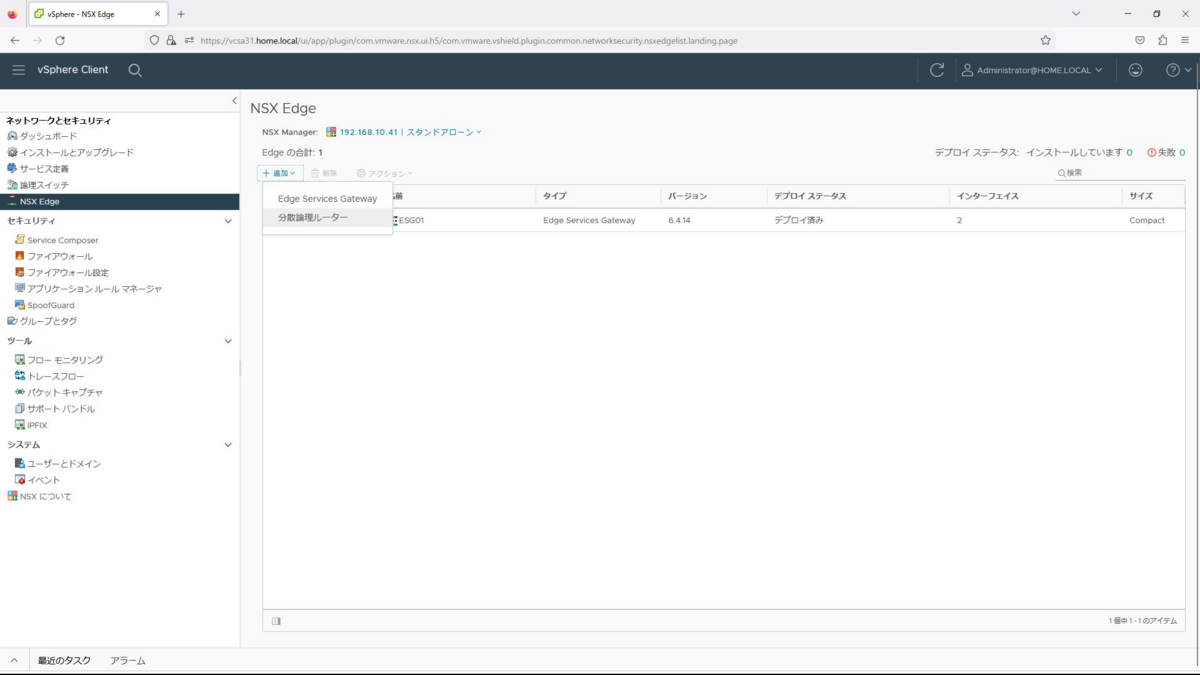

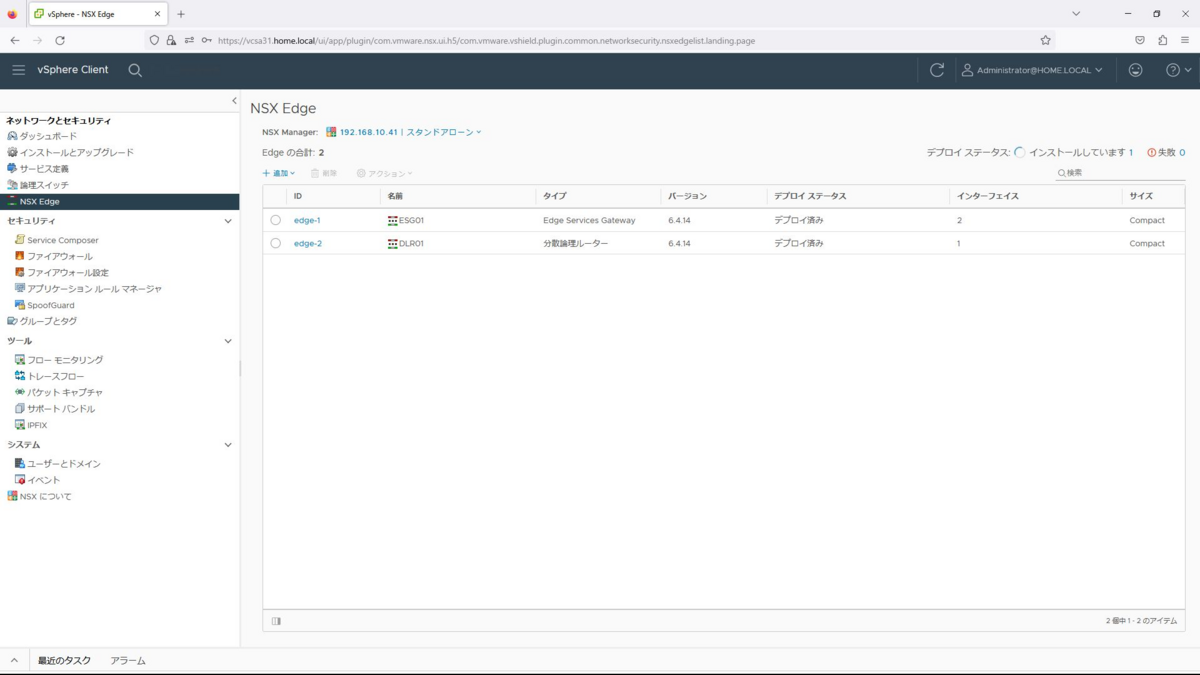

Edge Service Gateway(ESG)の作成

メニューの「ネットワークとセキュリティ」から「NSX Edge」を選択し、「追加」から、Edge Services Gatewayを選択します。

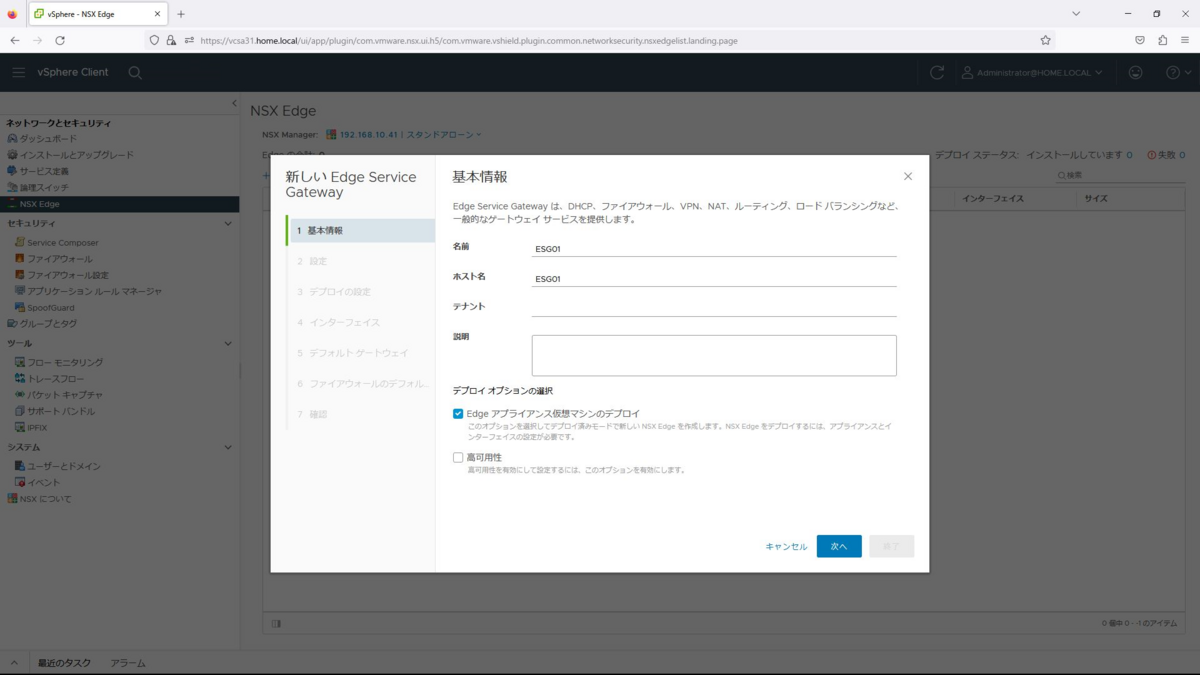

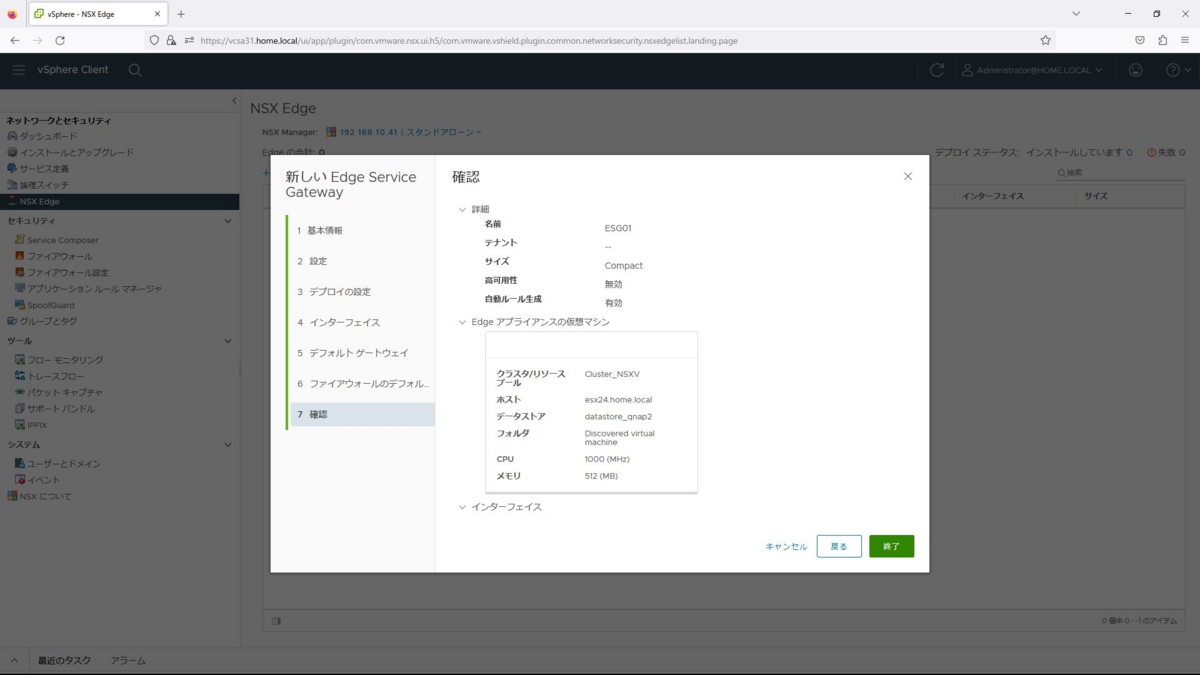

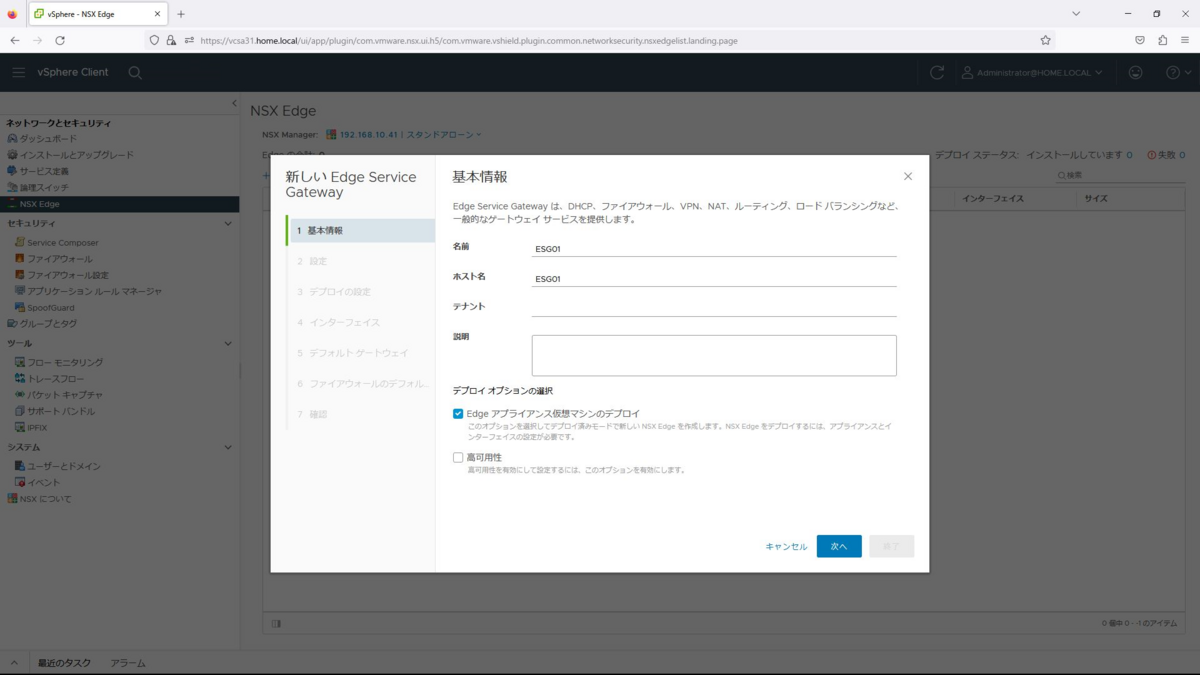

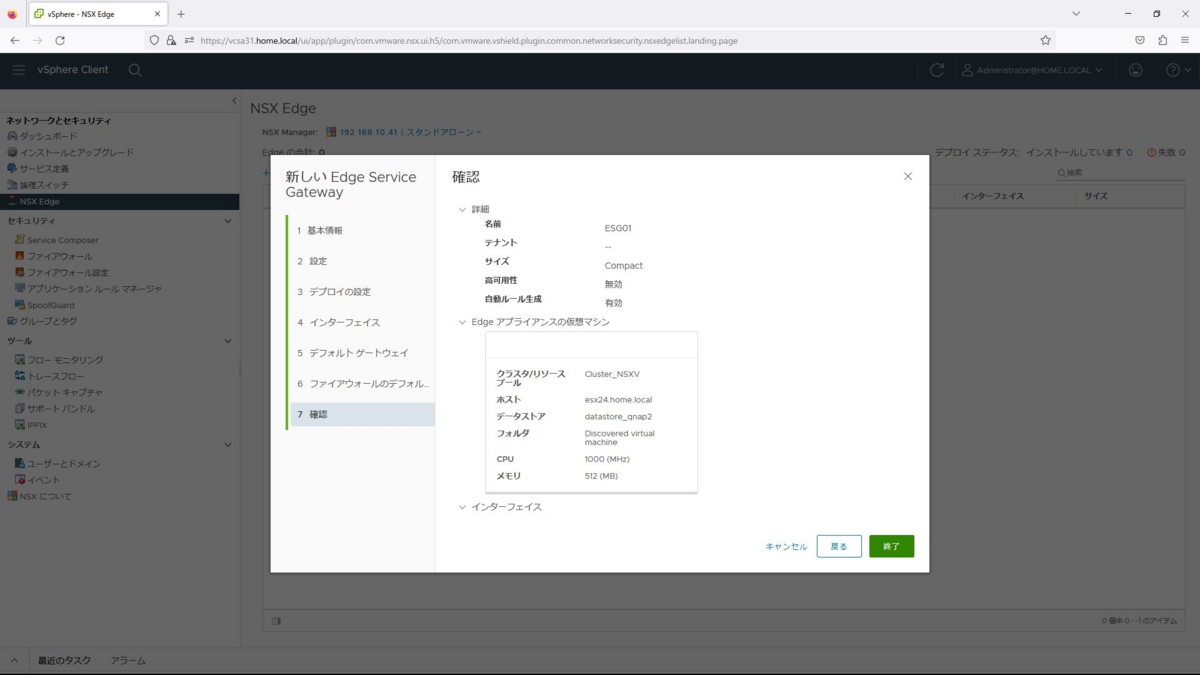

基本情報では名前を「ESG01」とし、「Edgeアプライアンス仮想マシンのデプロイ」のチェックを入れて次へを選択します。

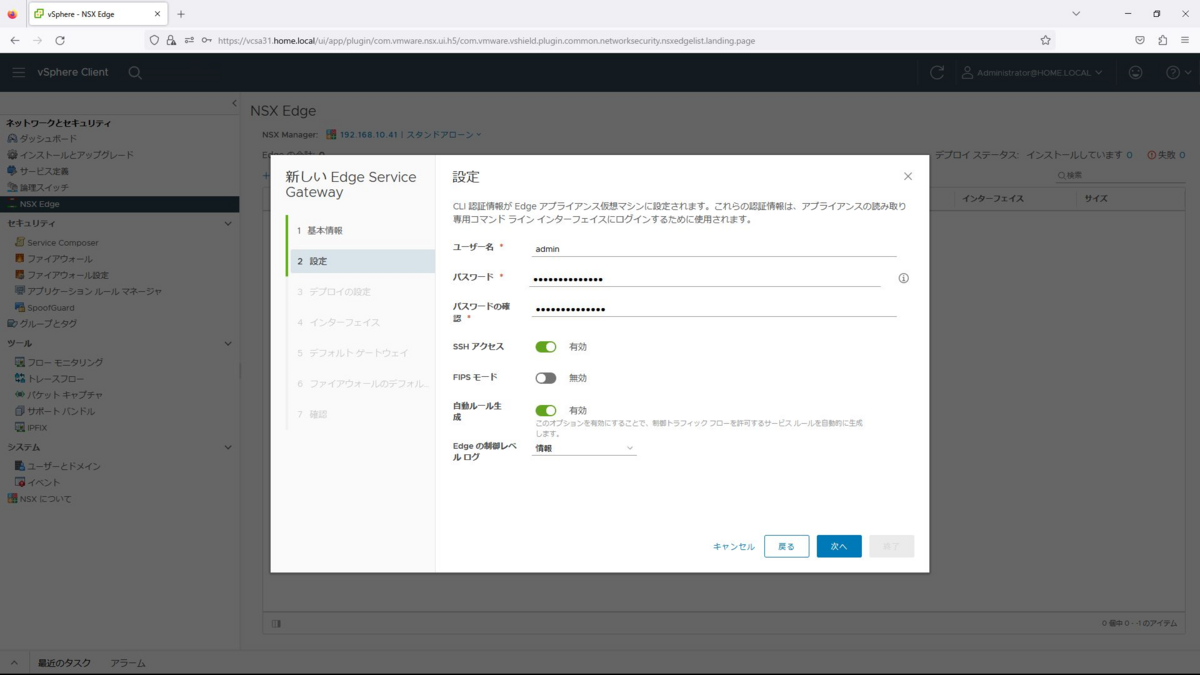

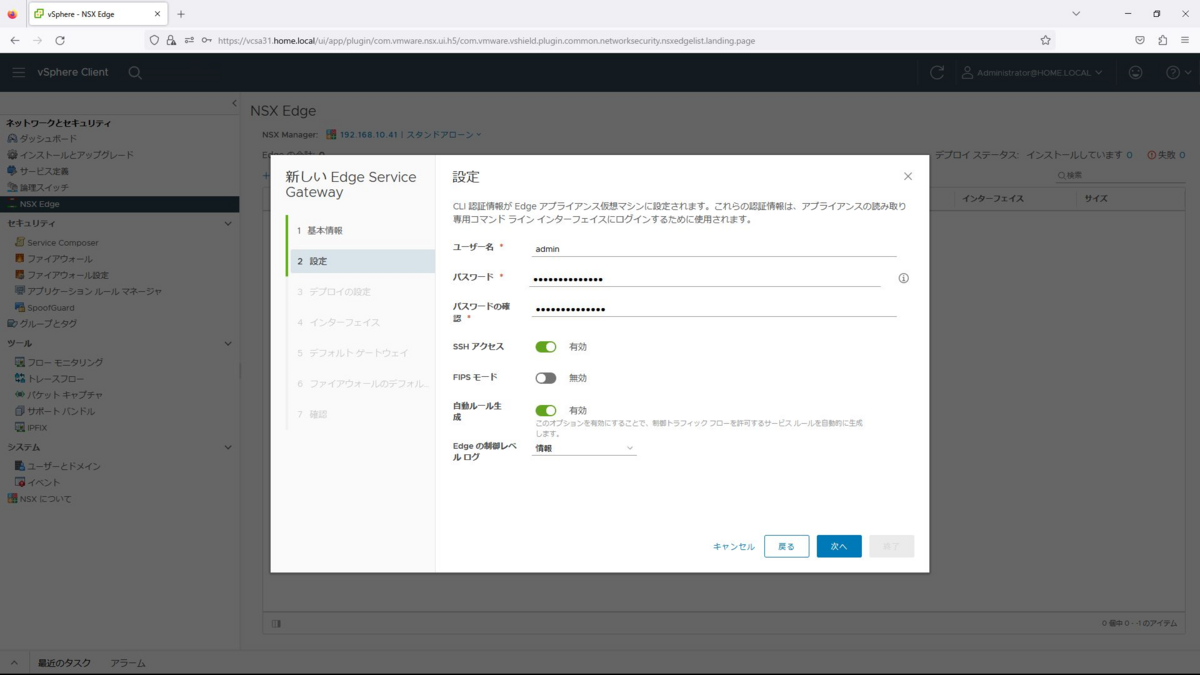

ユーザー名、パスワードは任意のものを設定します。また、SSHアクセスを有効とし、自動ルール生成も有効として、追加を押下します。

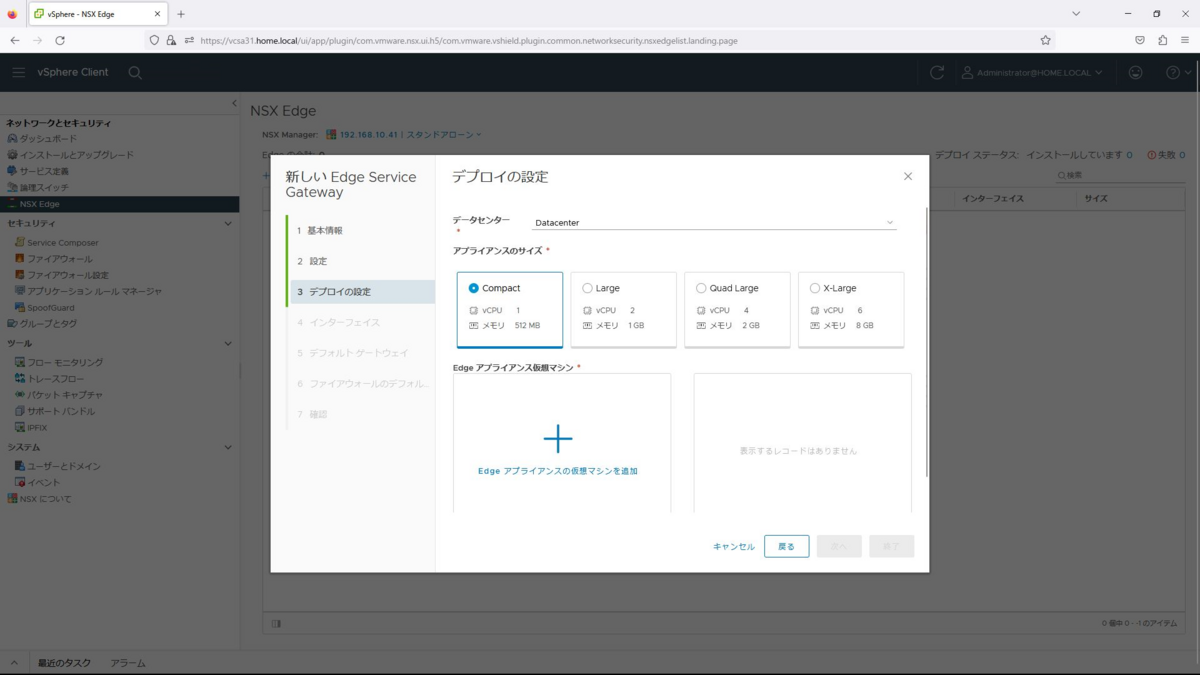

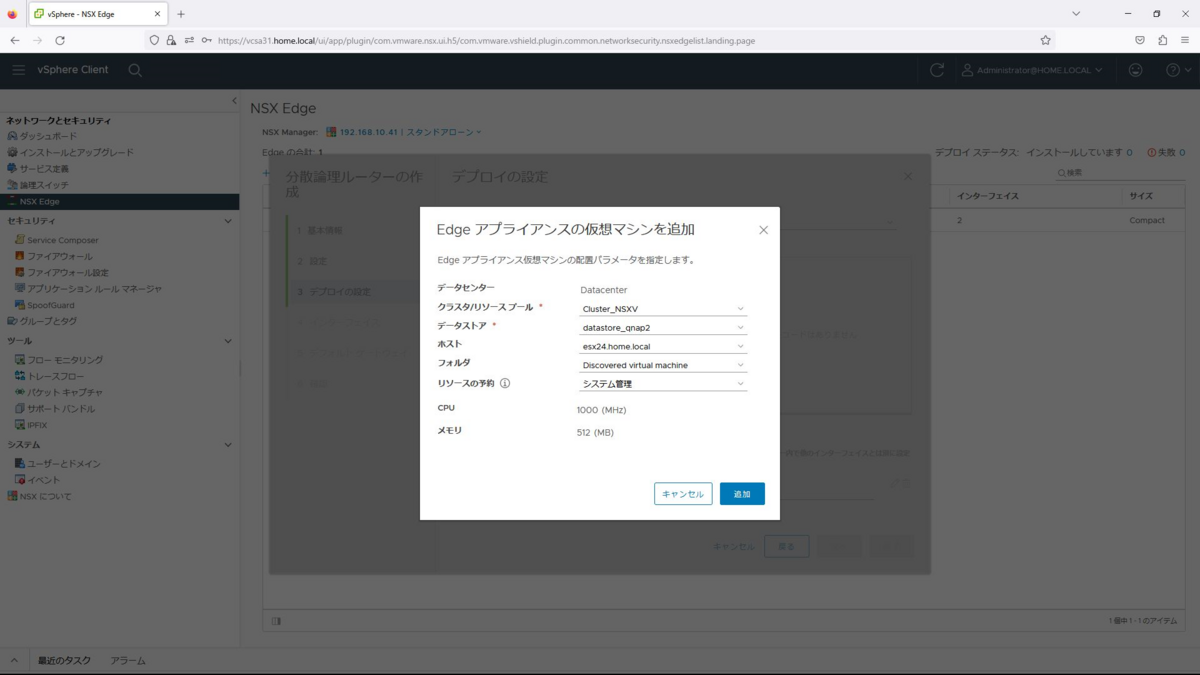

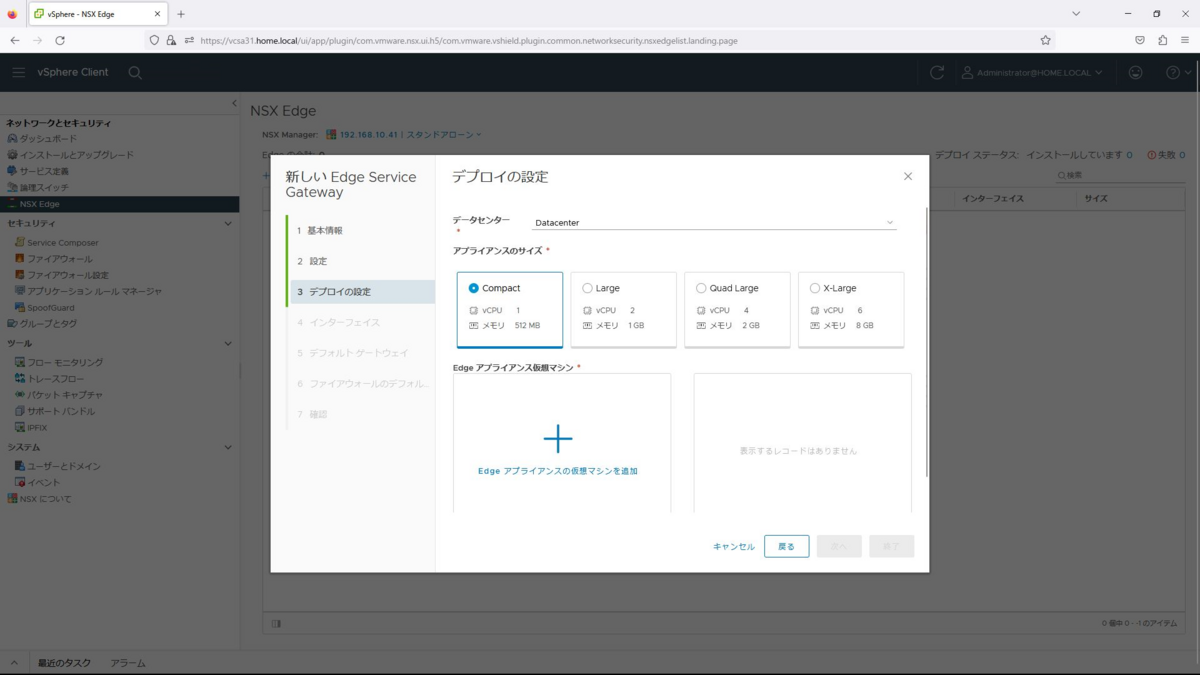

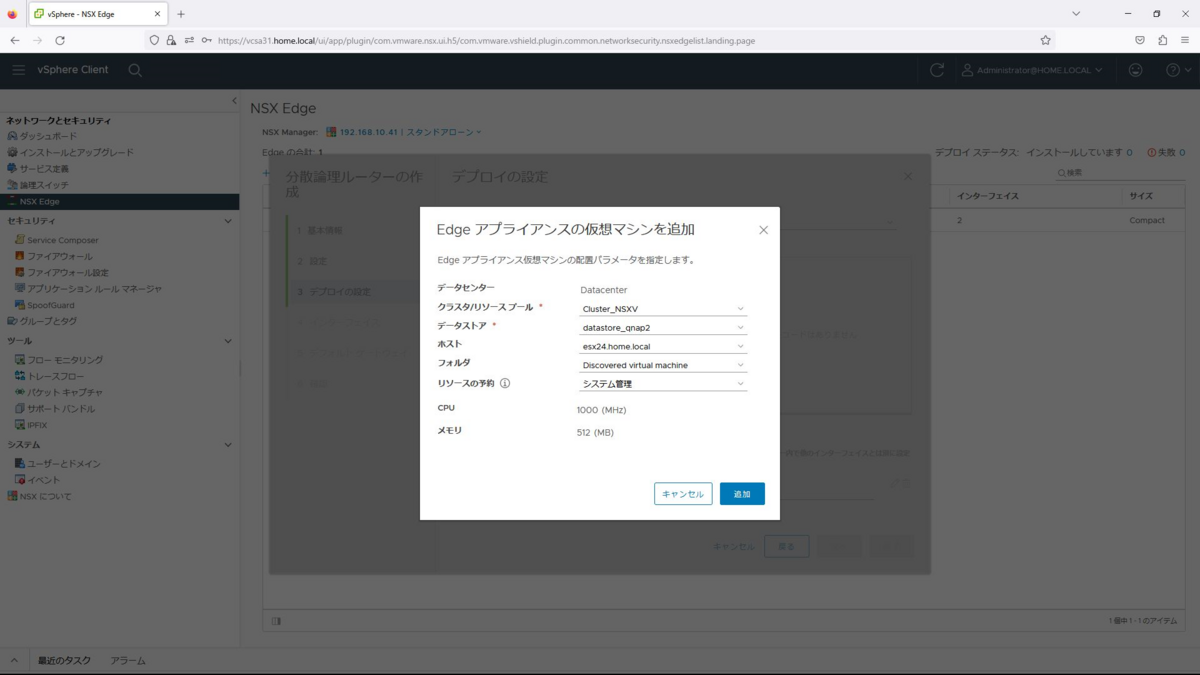

デプロイの設定で、データセンターは「Datacenter」、アプライアンスのサイズは「Compact」を選択し、「Edgeアプライアンスの仮想マシンを追加」を選択します。

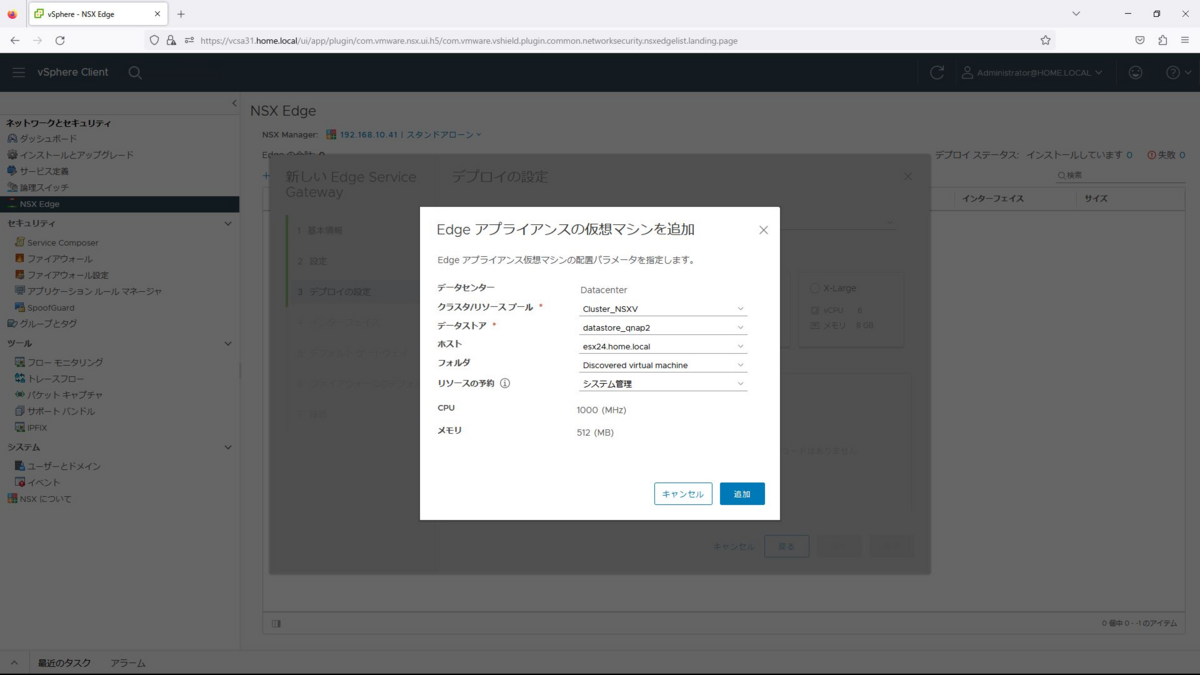

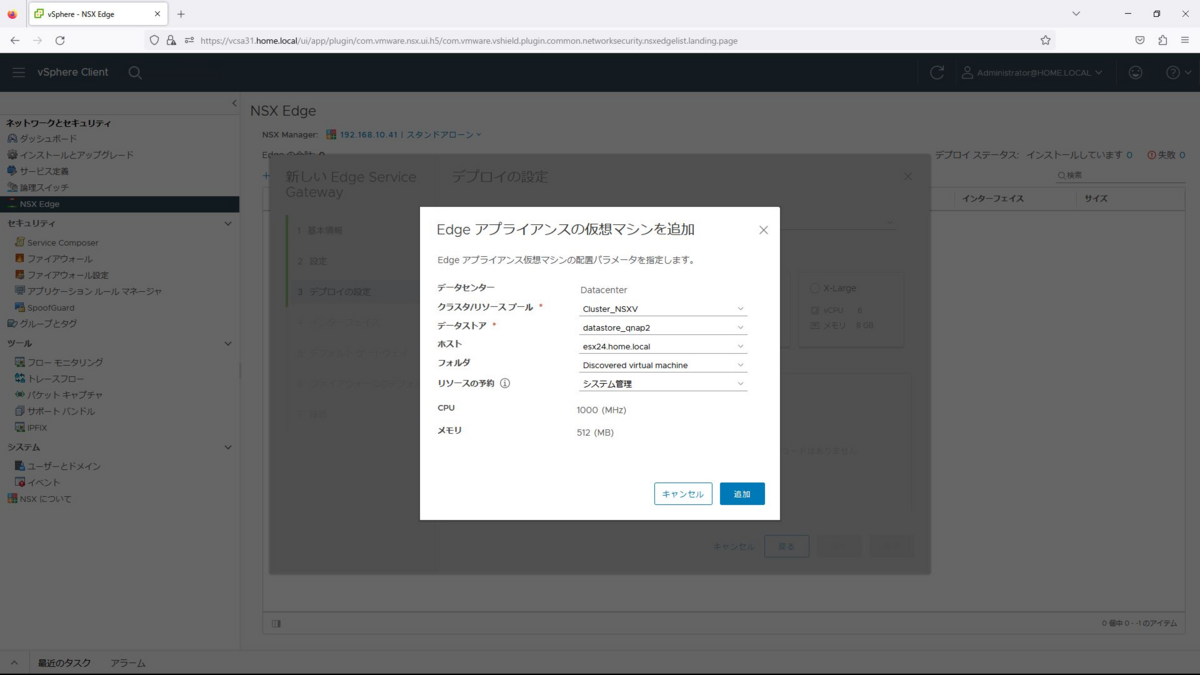

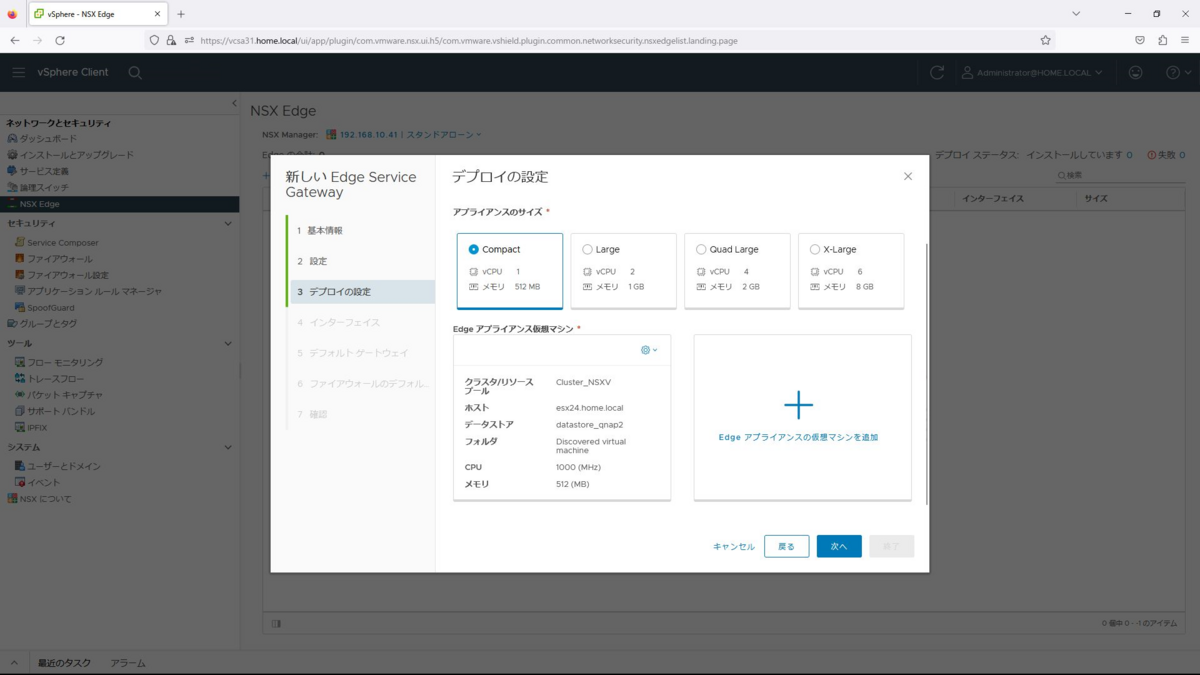

Edgeアプライアンスの配置パラメータで以下を入力し、追加を選択します。

クラスタ/リソース:Cluster_NSXV

データストア:datastore_qnap2

ホスト:esx24.home.local

フォルダ:Discoverd virtual machine

リソースの予約:システム管理

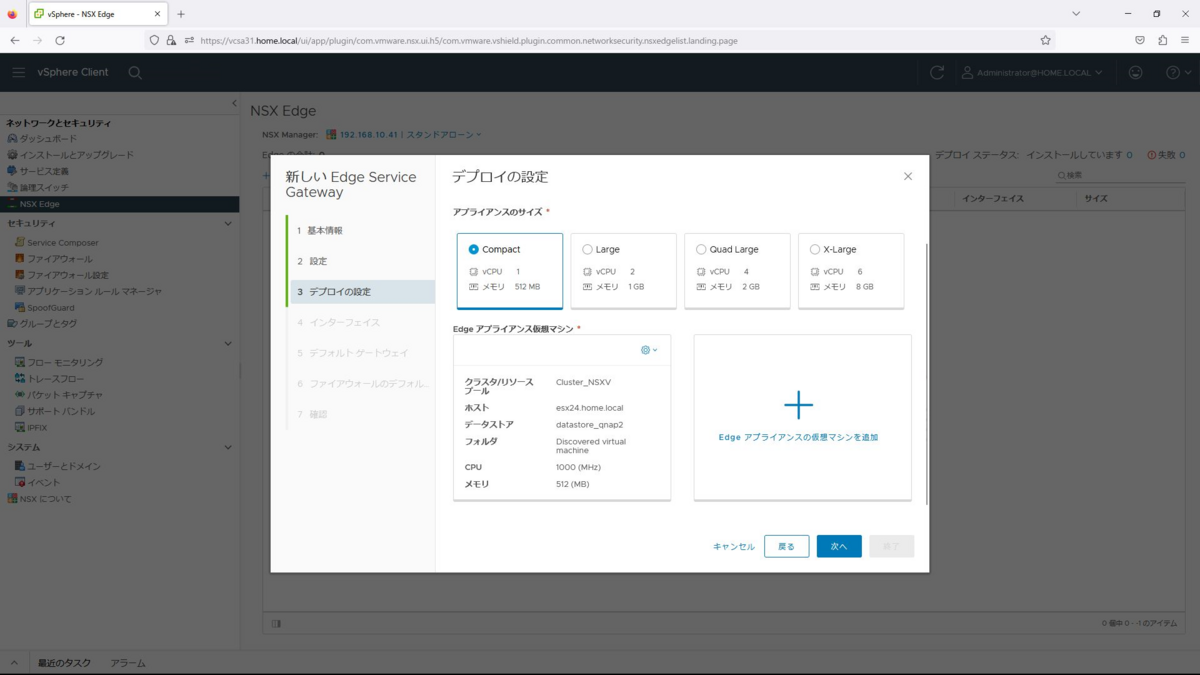

設定が完了したら、次へを選択します。

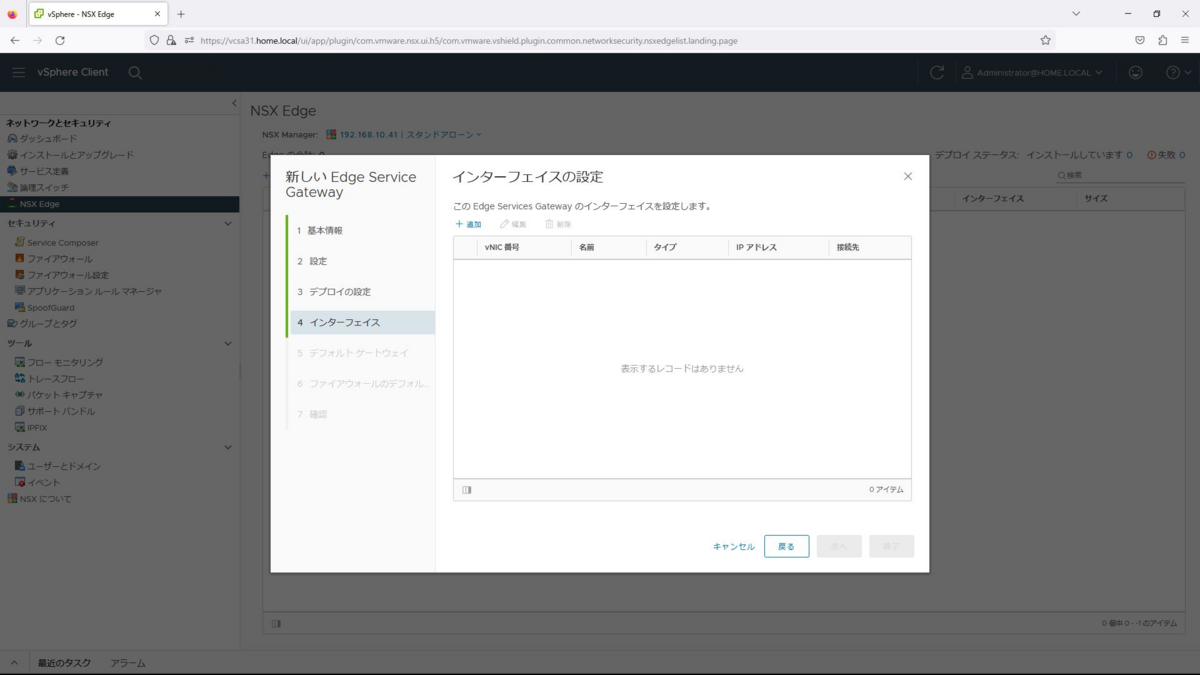

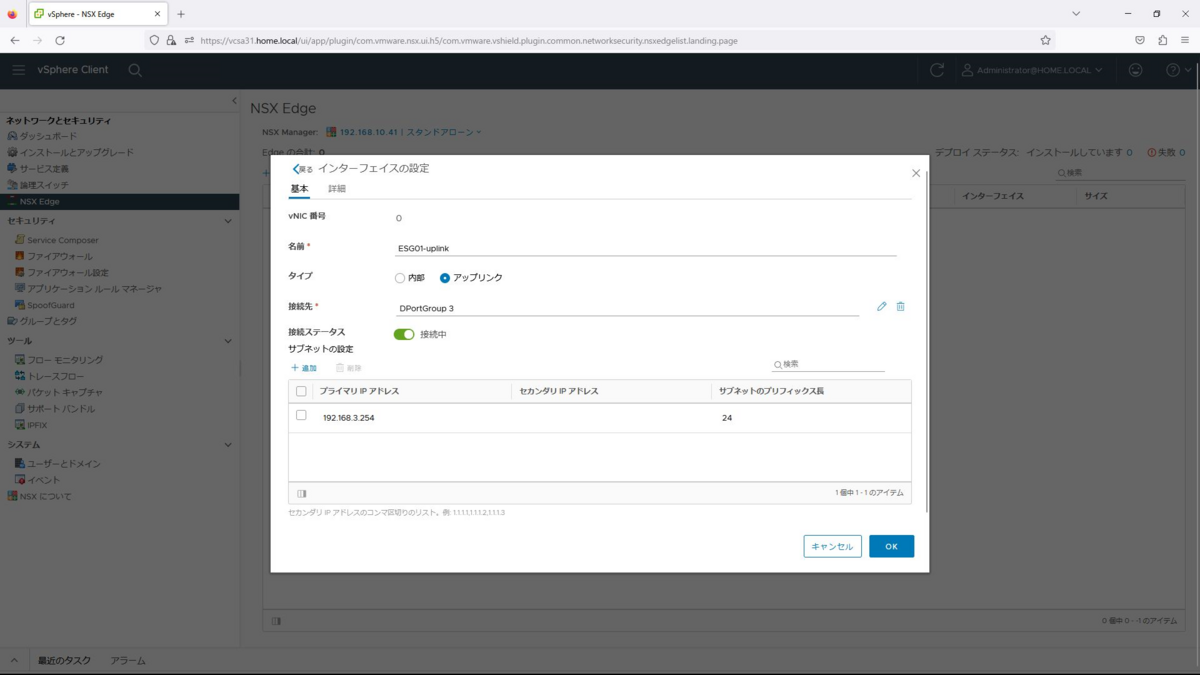

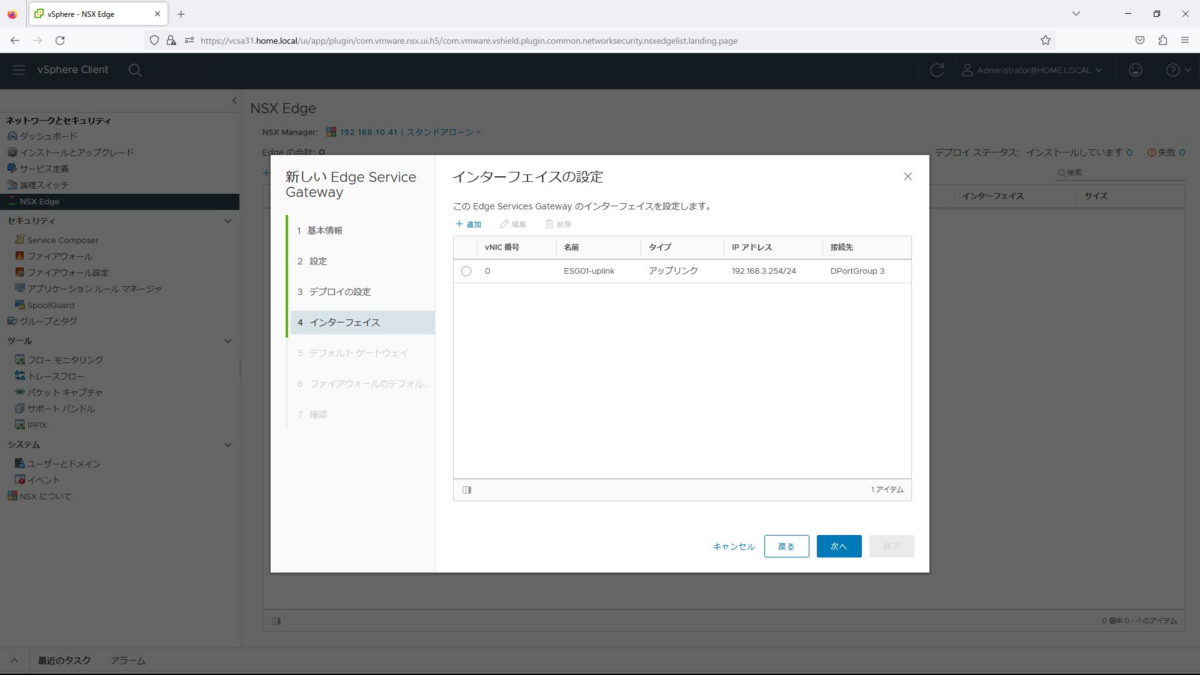

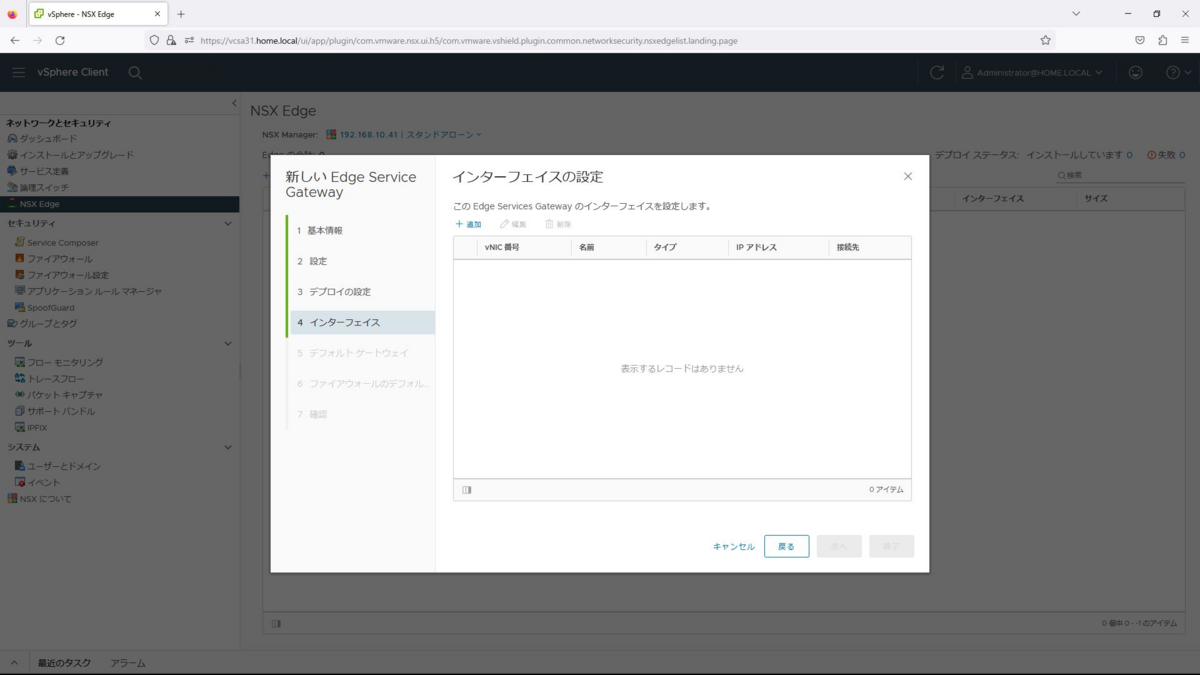

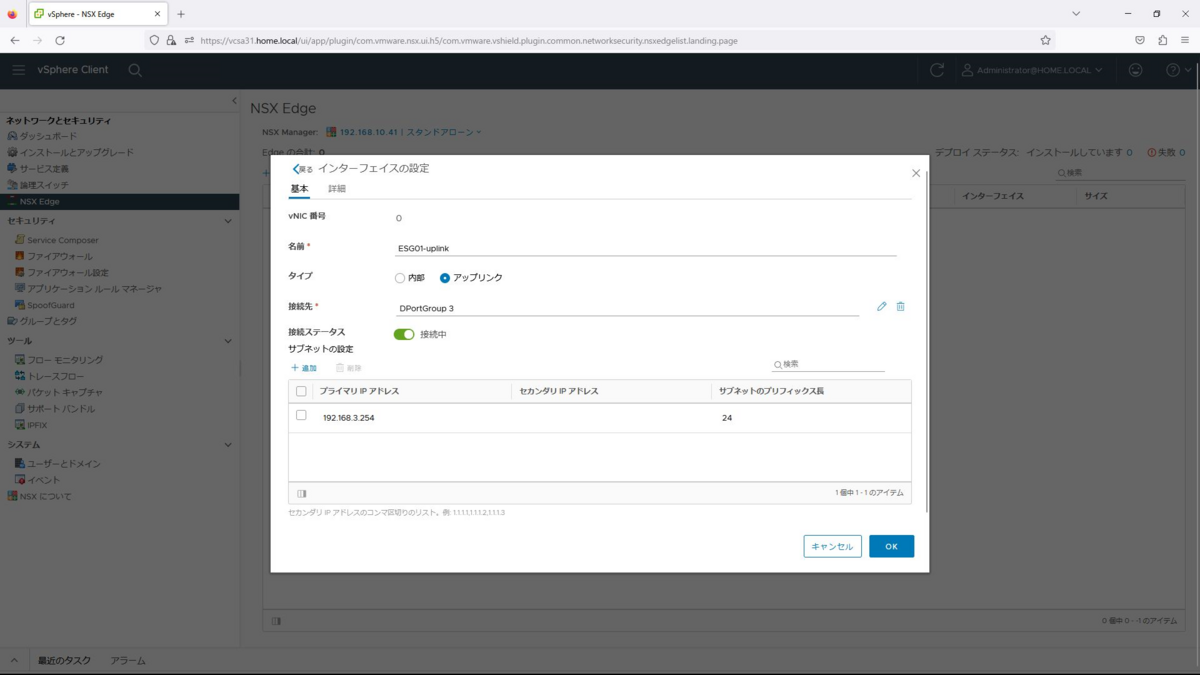

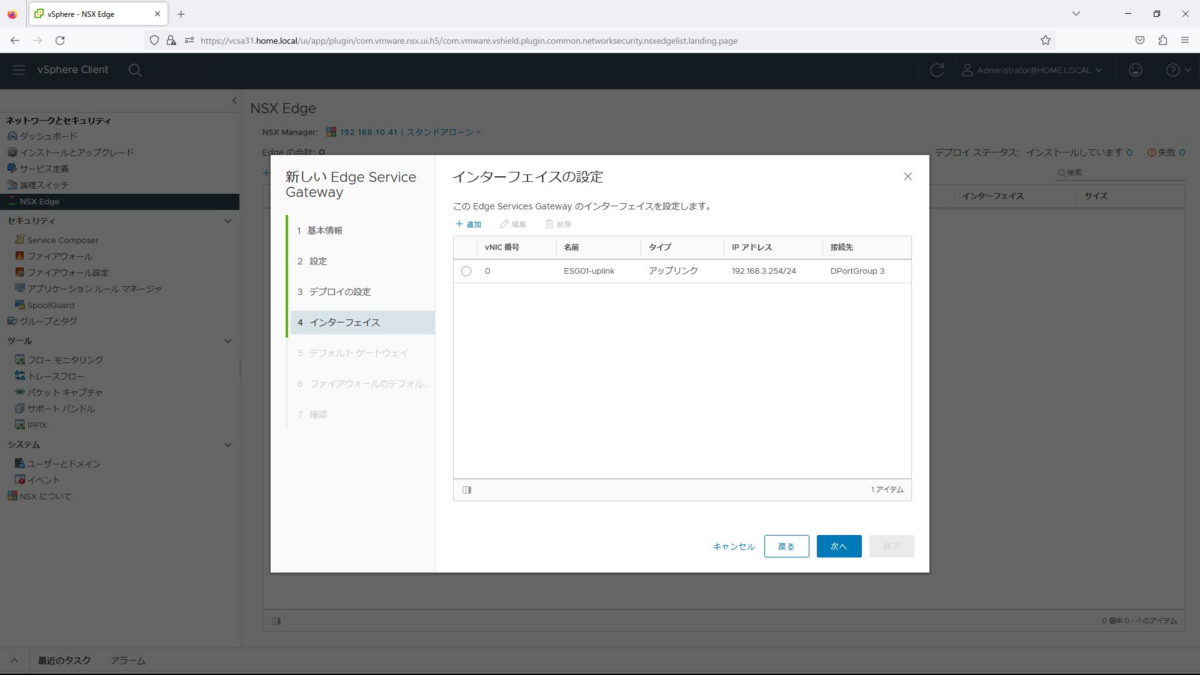

インターフェイスでは追加を選択します。

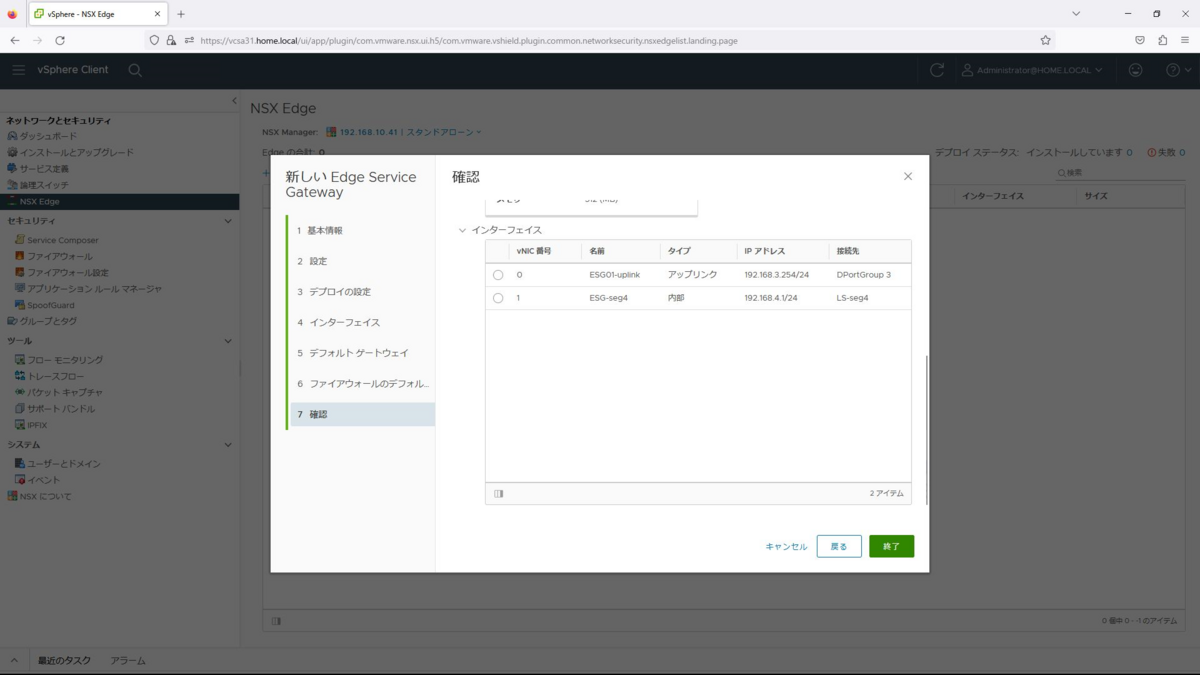

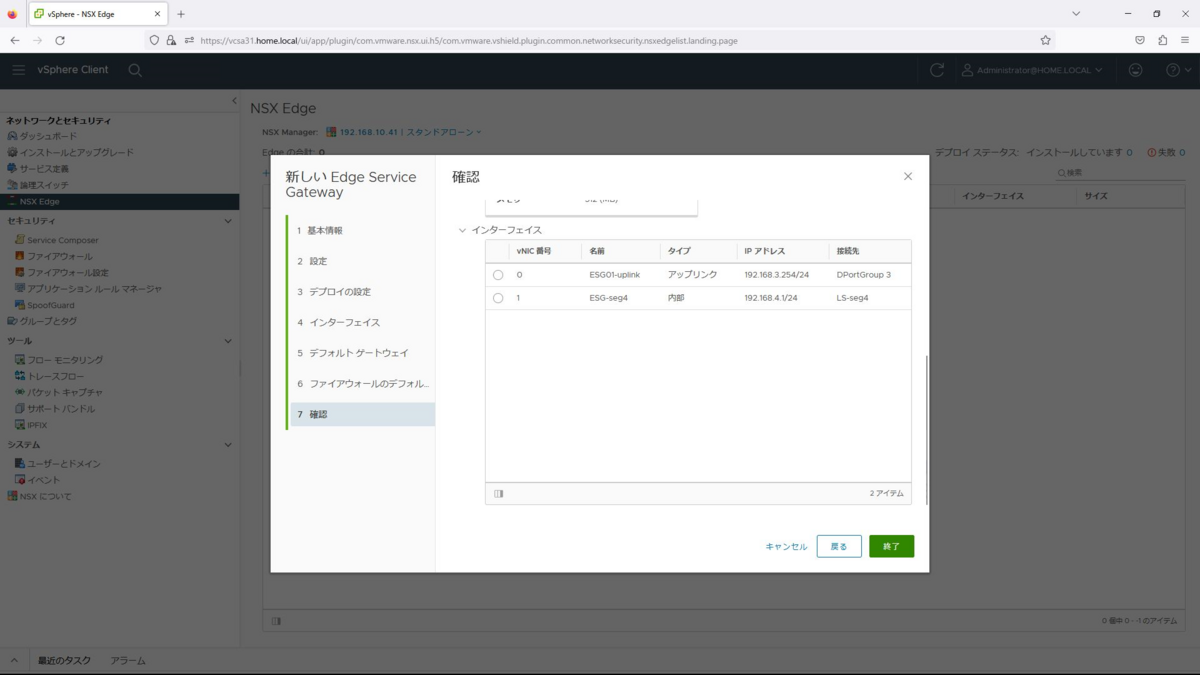

インターフェイスの設定で以下を入力し、OKを選択します。

名前:ESG01-uplink

タイプ:アップリンク

接続先:DPortGroup 3

接続ステータス:接続中

サブネットの設定:192.168.3.254/24

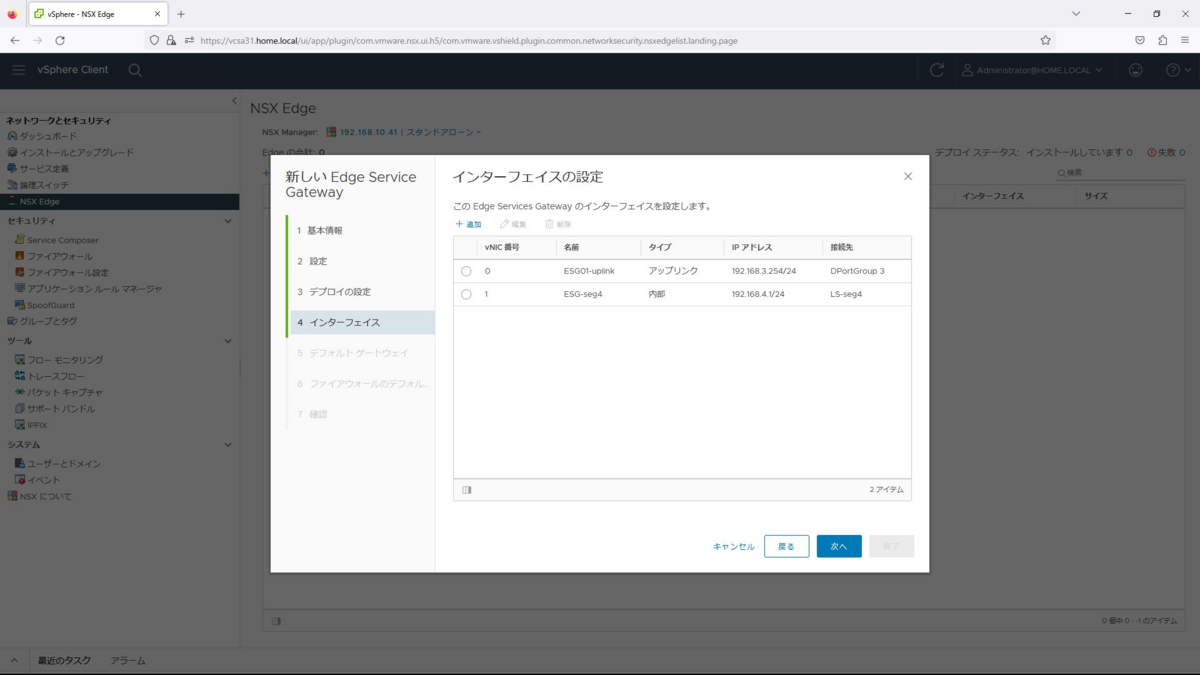

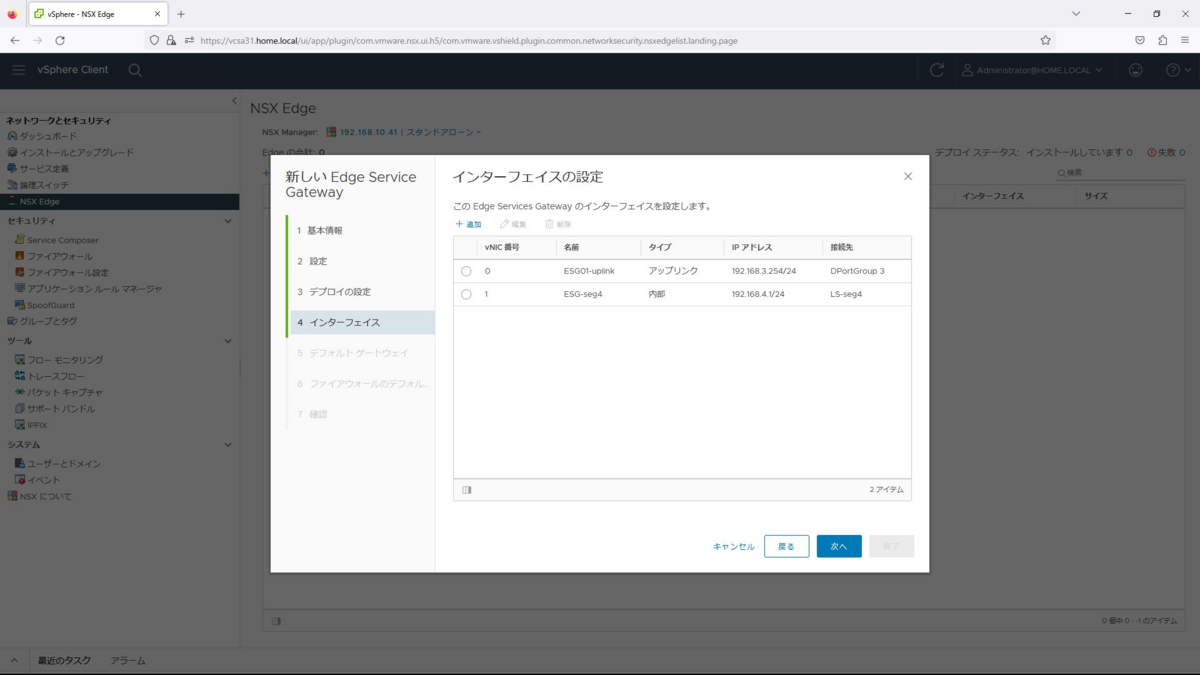

同様に内部ネットワークのインターフェイスも作成し、次へを選択します。

名前:ESG-seg4

タイプ:内部

接続先:LS-seg4

接続ステータス:接続中

サブネットの設定:192.168.4.1/24

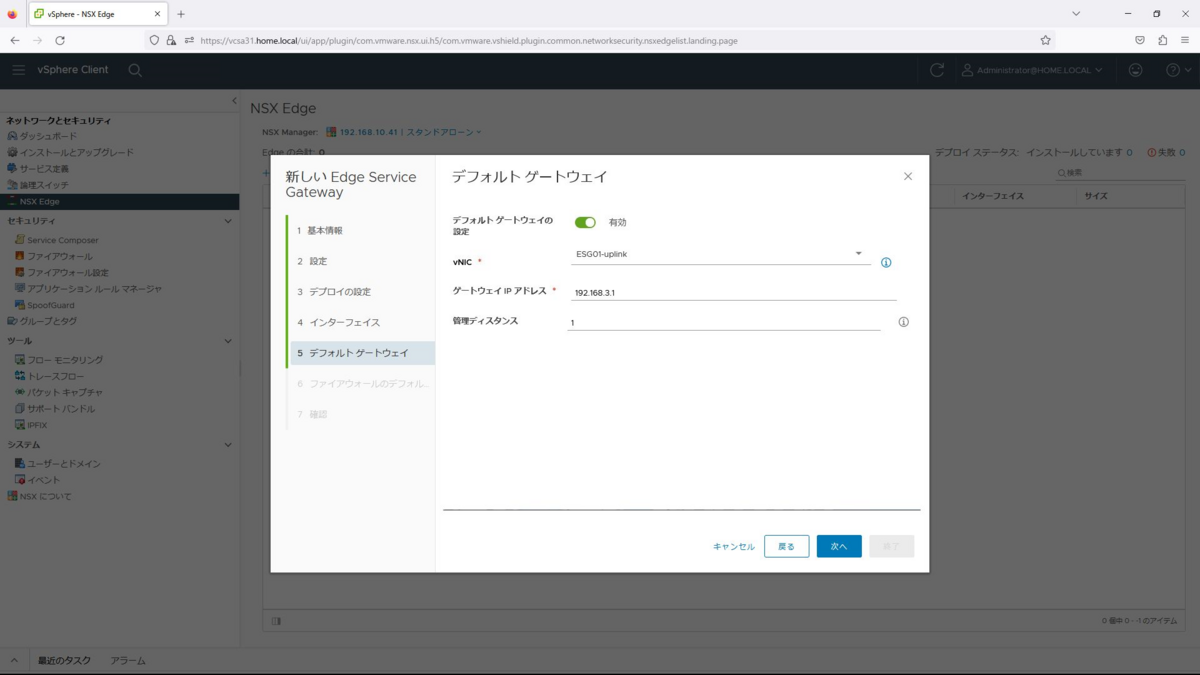

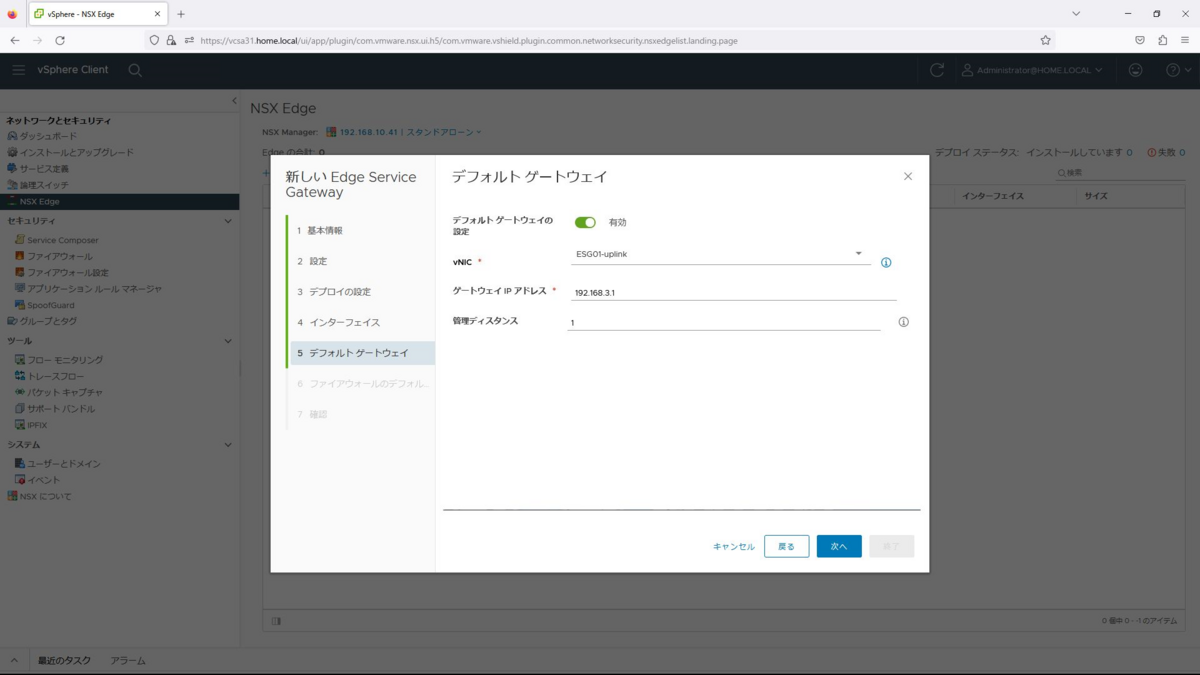

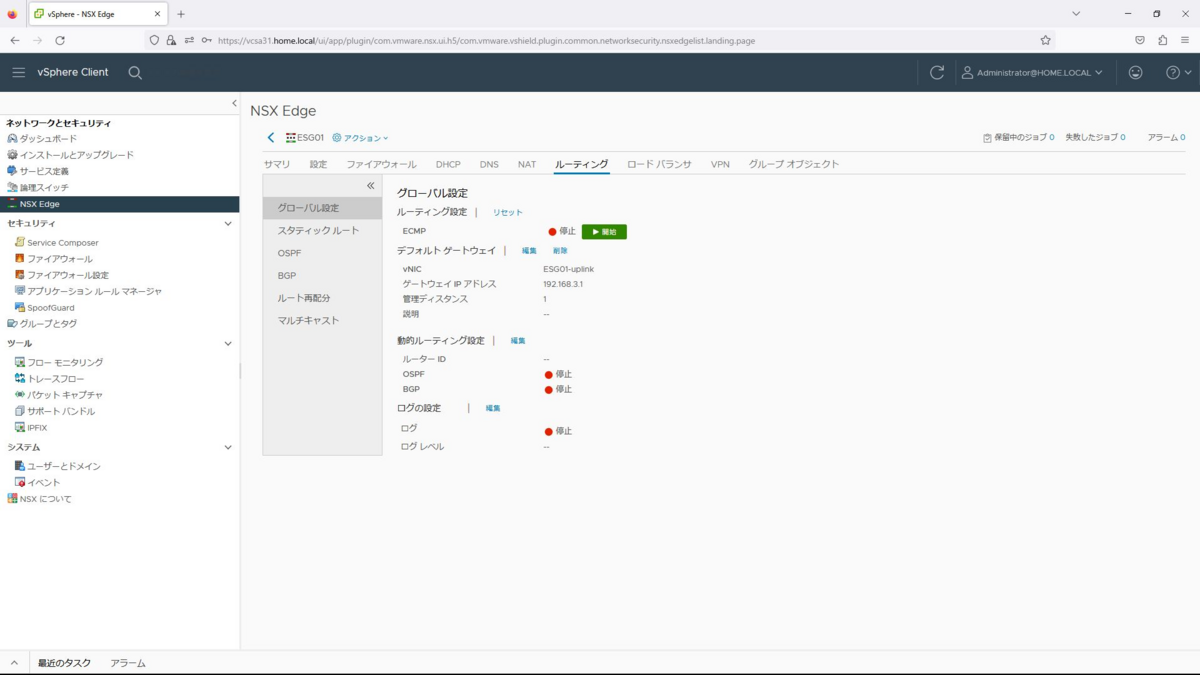

デフォルトゲートウェイを「有効」、vNICを「ESG01-uplink」、ゲートウェイIPアドレスを「192.168.3.1」を入力して次へを押下します。

なお、ゲートウェイは2960-L3となるので、事前にVLANインターフェースの設定を実施しておきます。

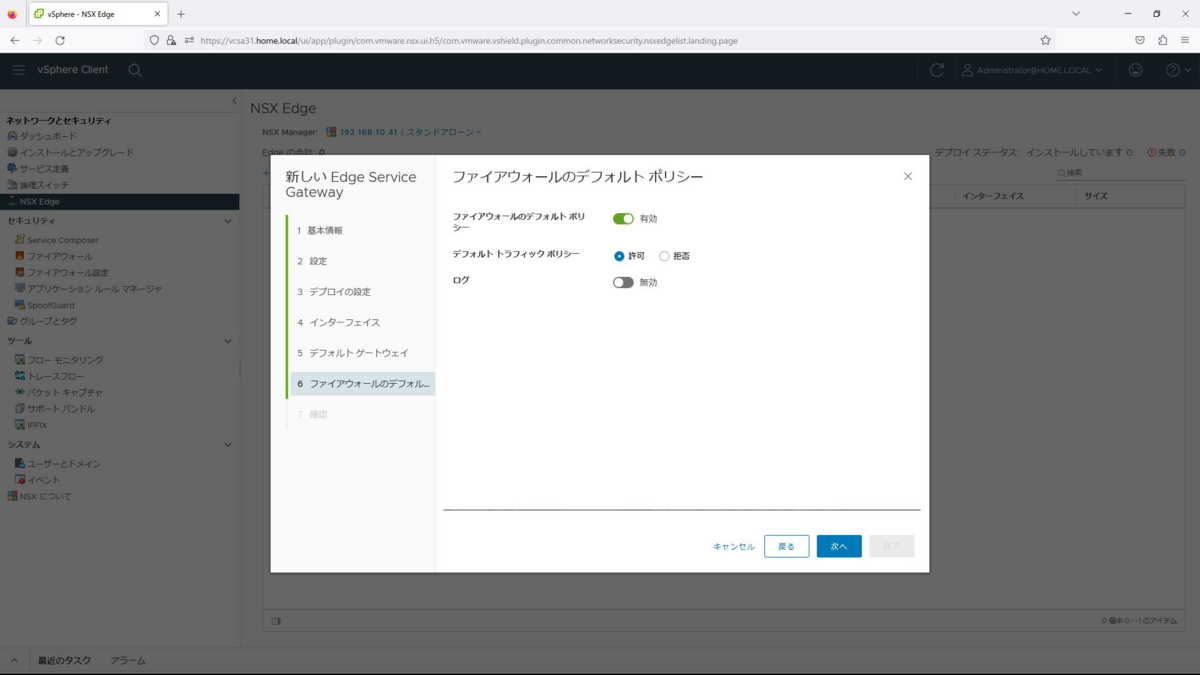

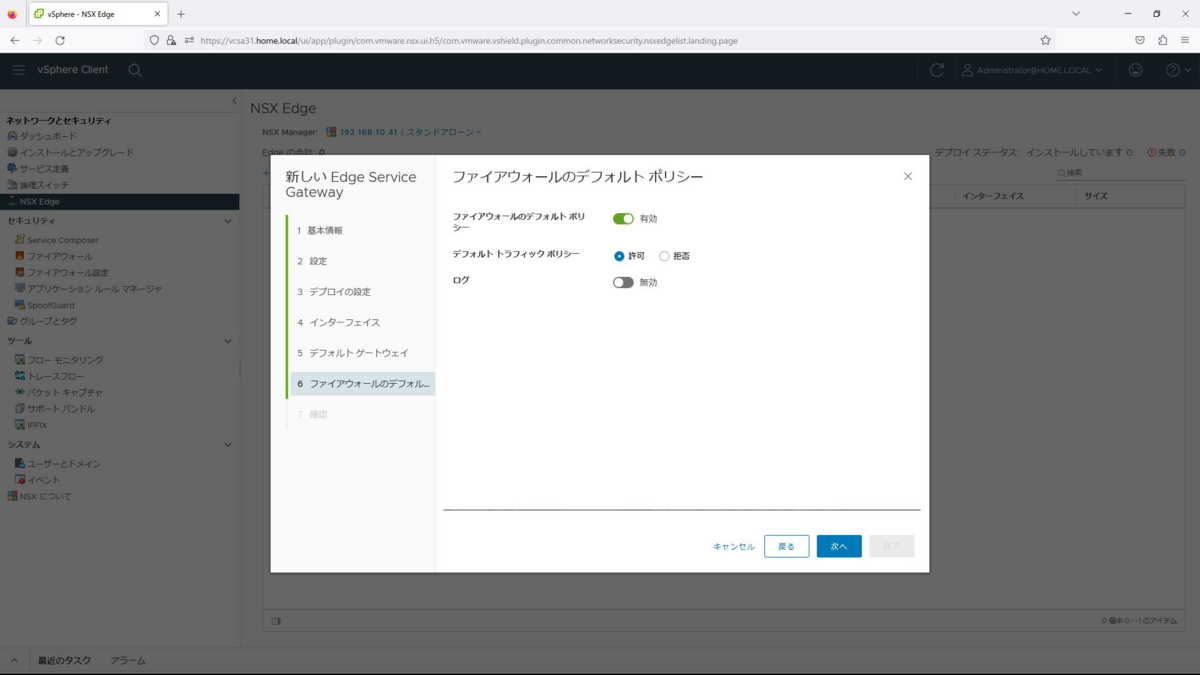

ファイアウォールのデフォルトポリシーを「有効」、デフォルトトラフィックポリシーを「許可」、ログを「無効」として次へを選択します。ここでは、いったんデフォルトポリシーを許可で作成しておきます。

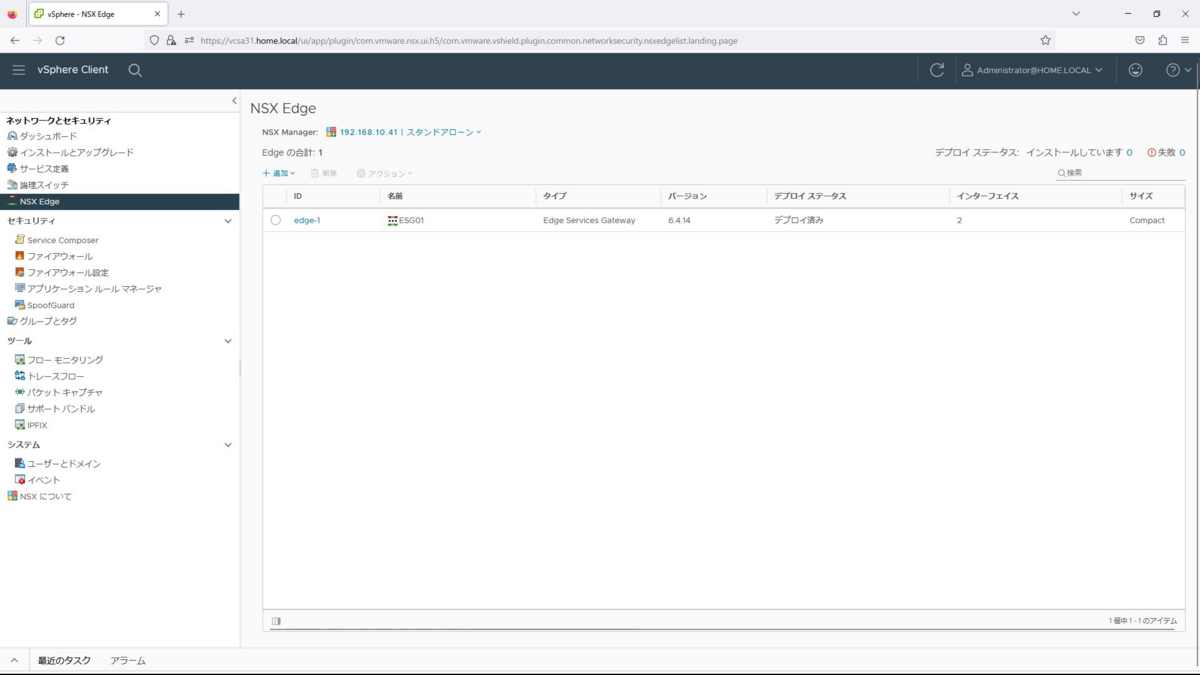

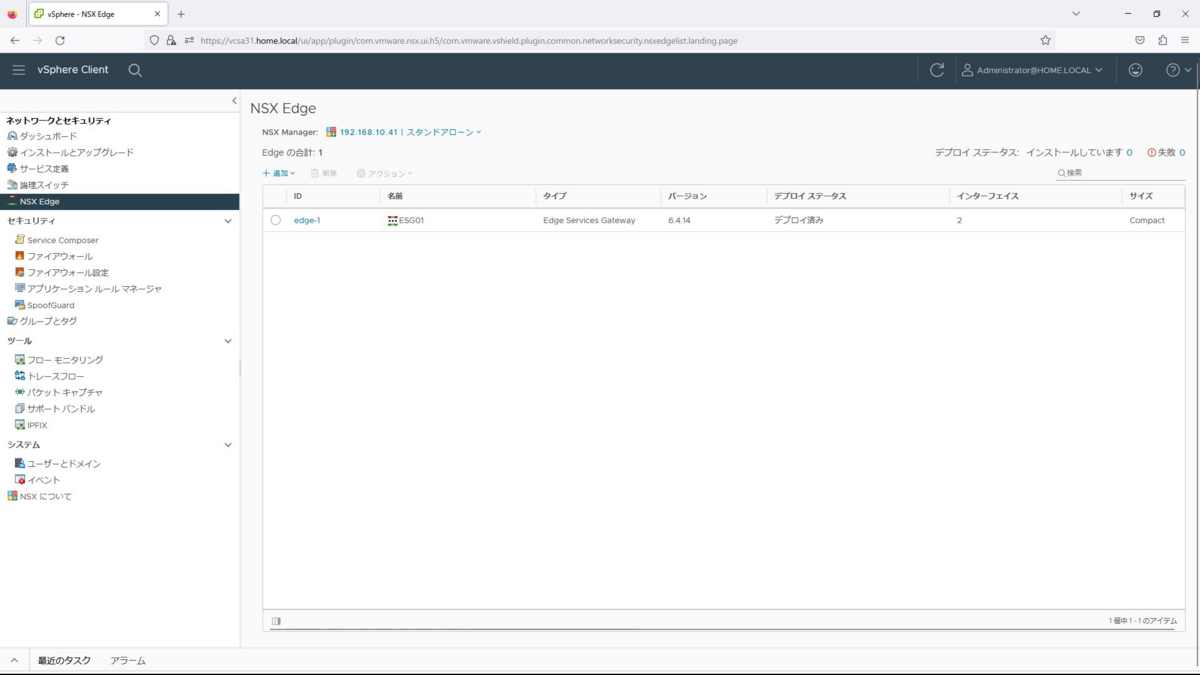

確認して終了を押下するとデプロイが始まり完了するとESGが表示されます。

分散論理ルーター(DLR)の作成

続いて分散論理ルータを作成します。

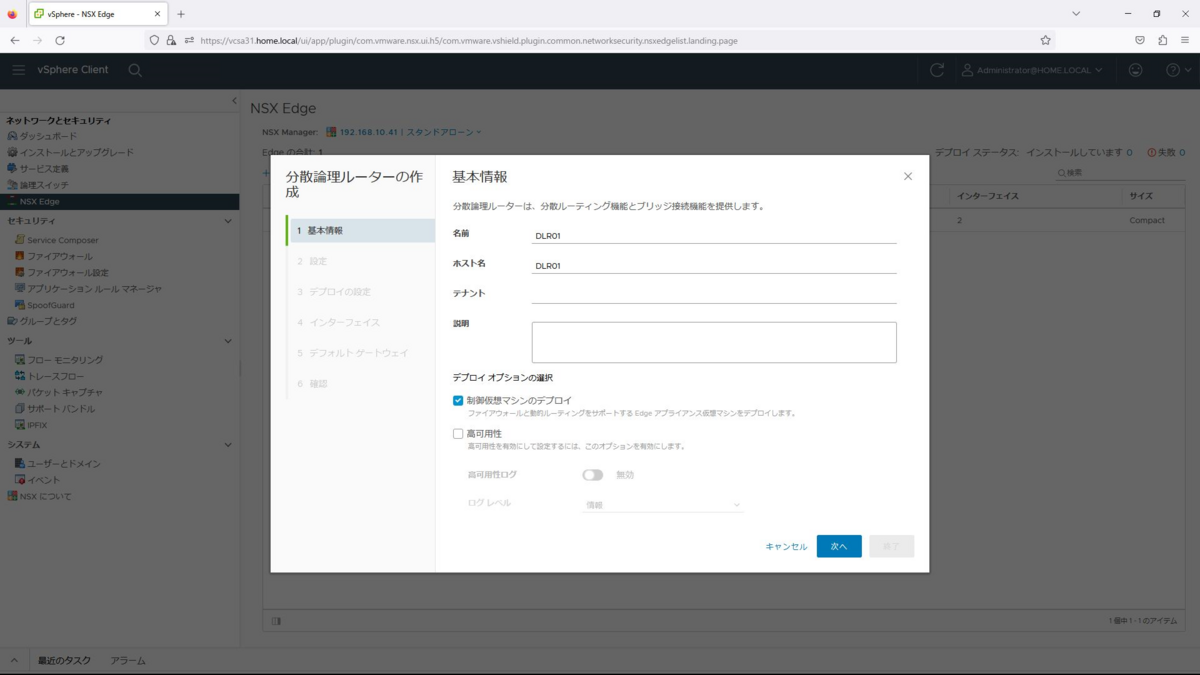

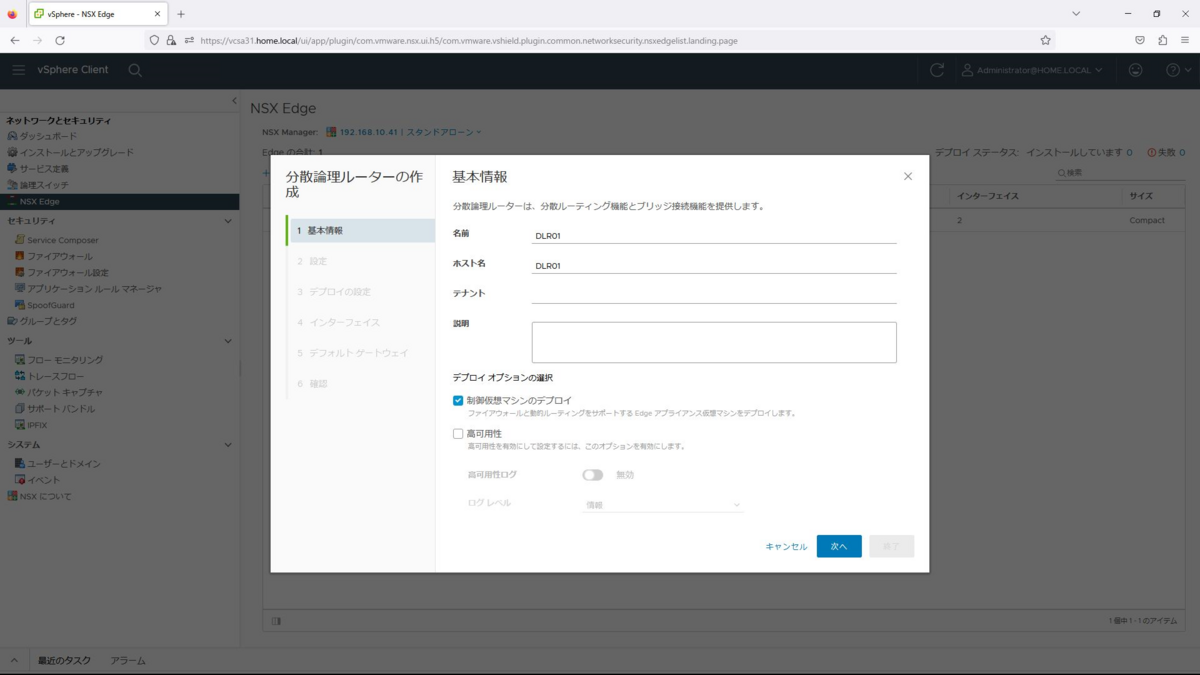

メニューの「ネットワークとセキュリティ」から「NSX Edge」を選択し、「追加」から、分散論理ルーターを選択します。

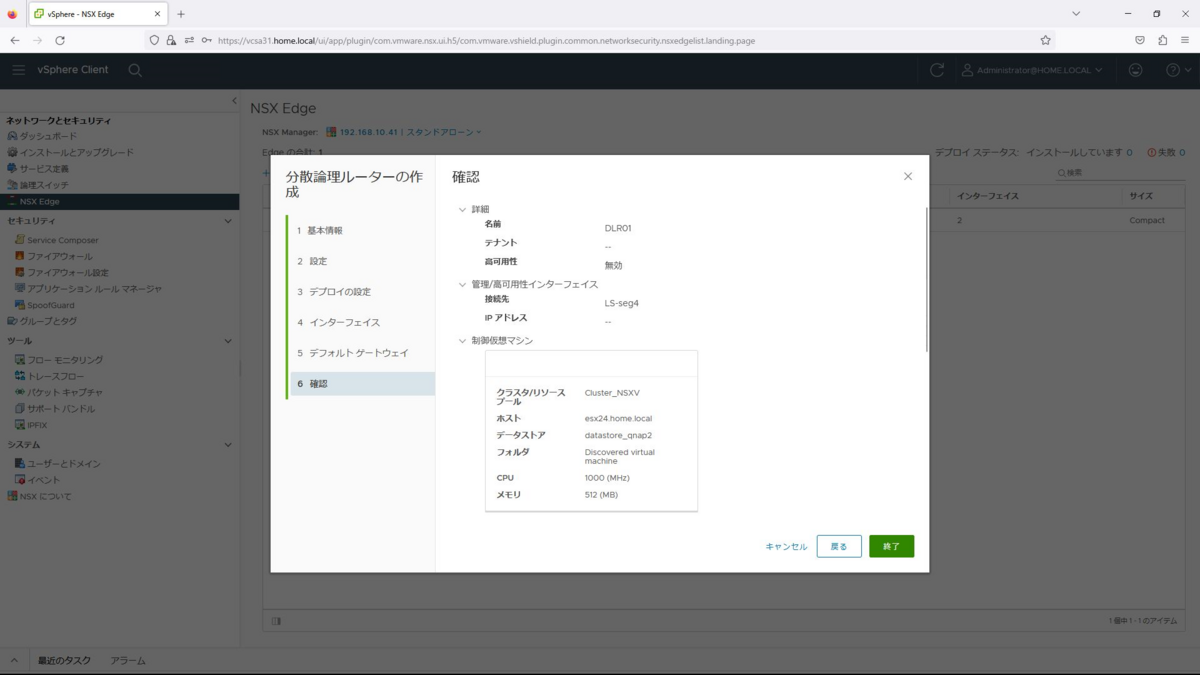

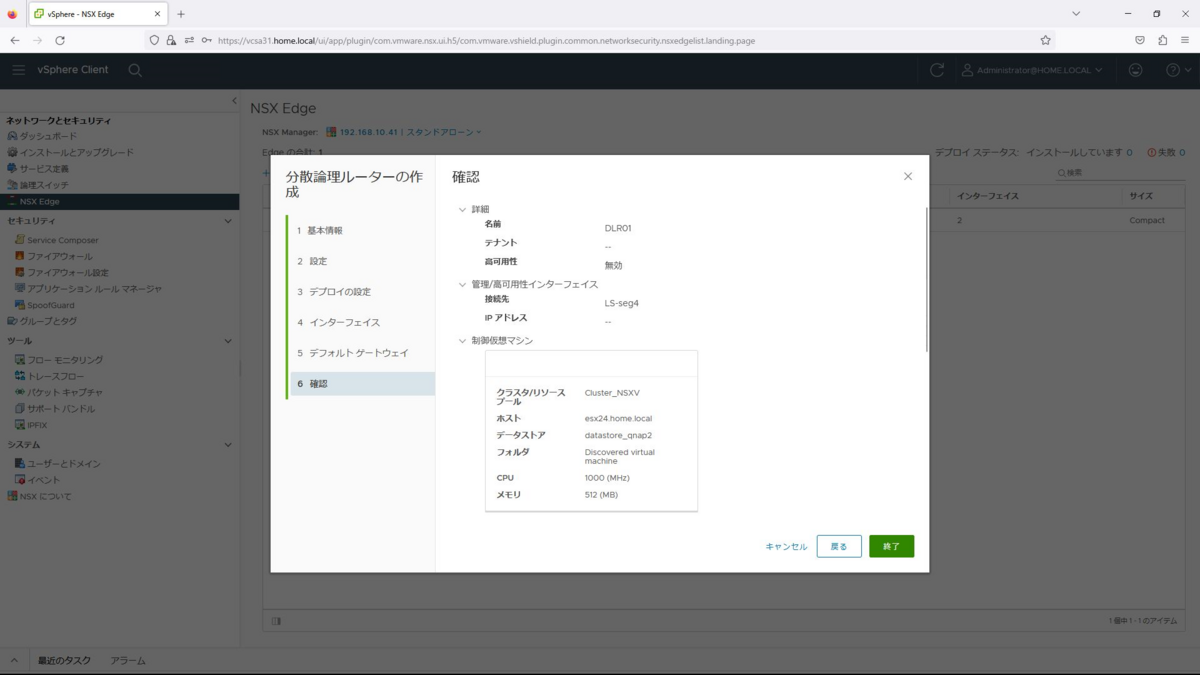

名前は「DLR01」とし、制御仮想マシンのデプロイにチェックを入れ、次へを選択します。

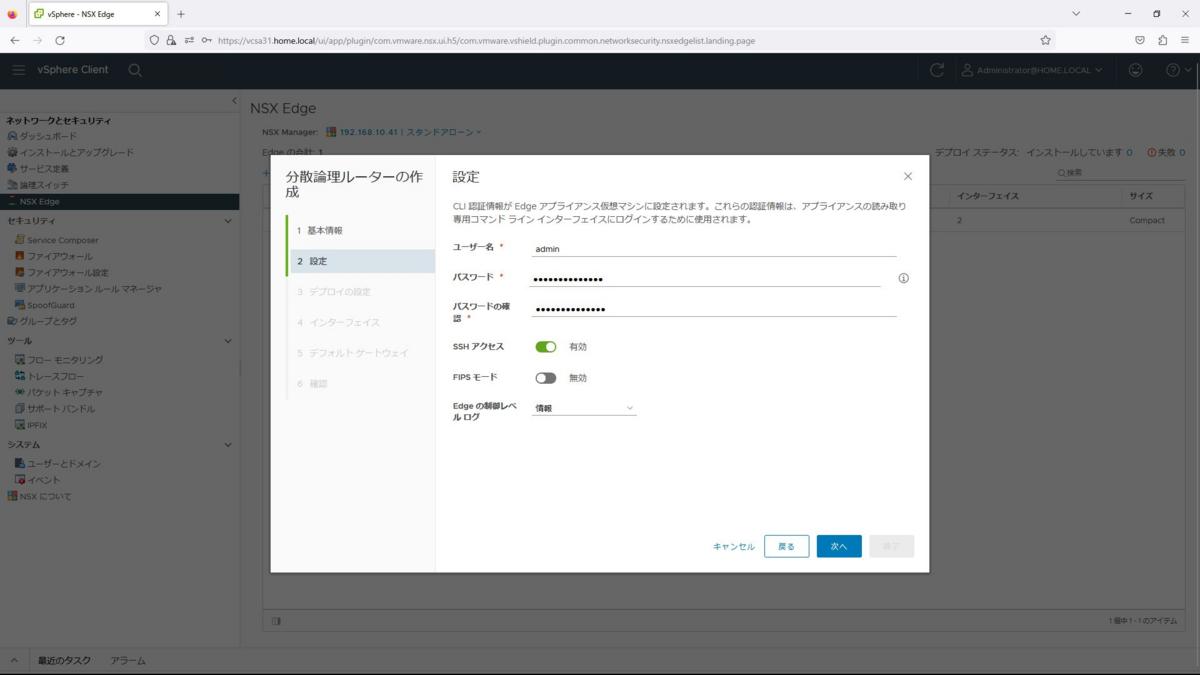

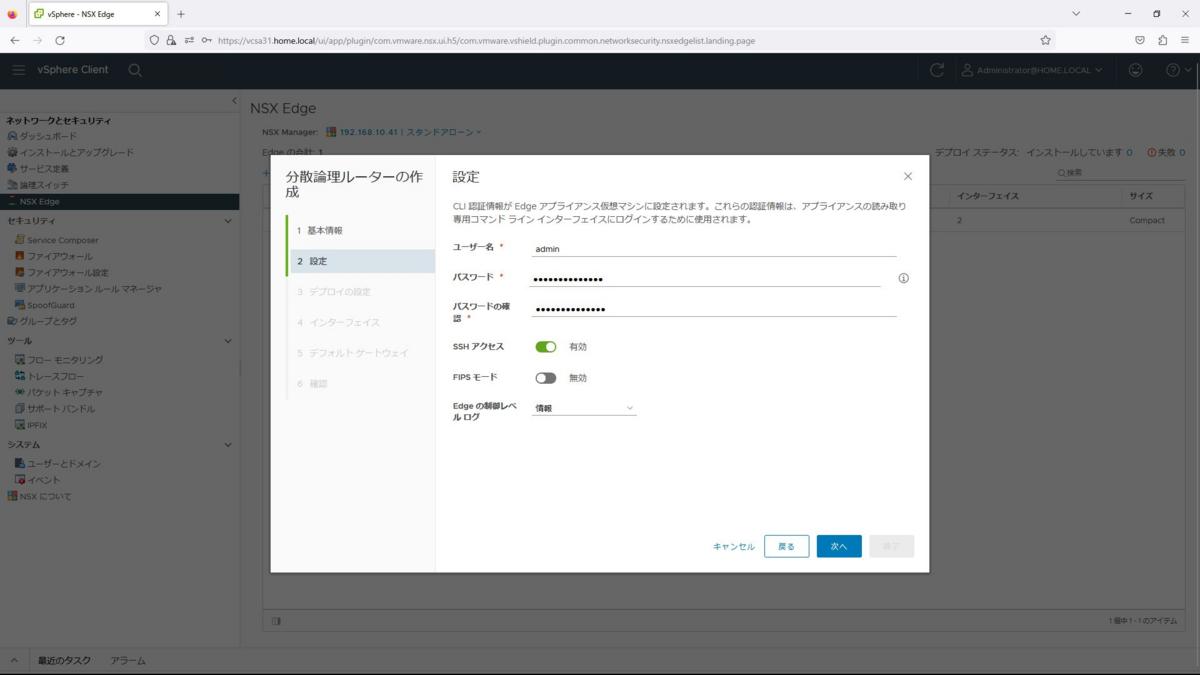

ユーザー名、パスワードは任意のものを設定します。また、SSHアクセスを有効とし、追加を選択します。

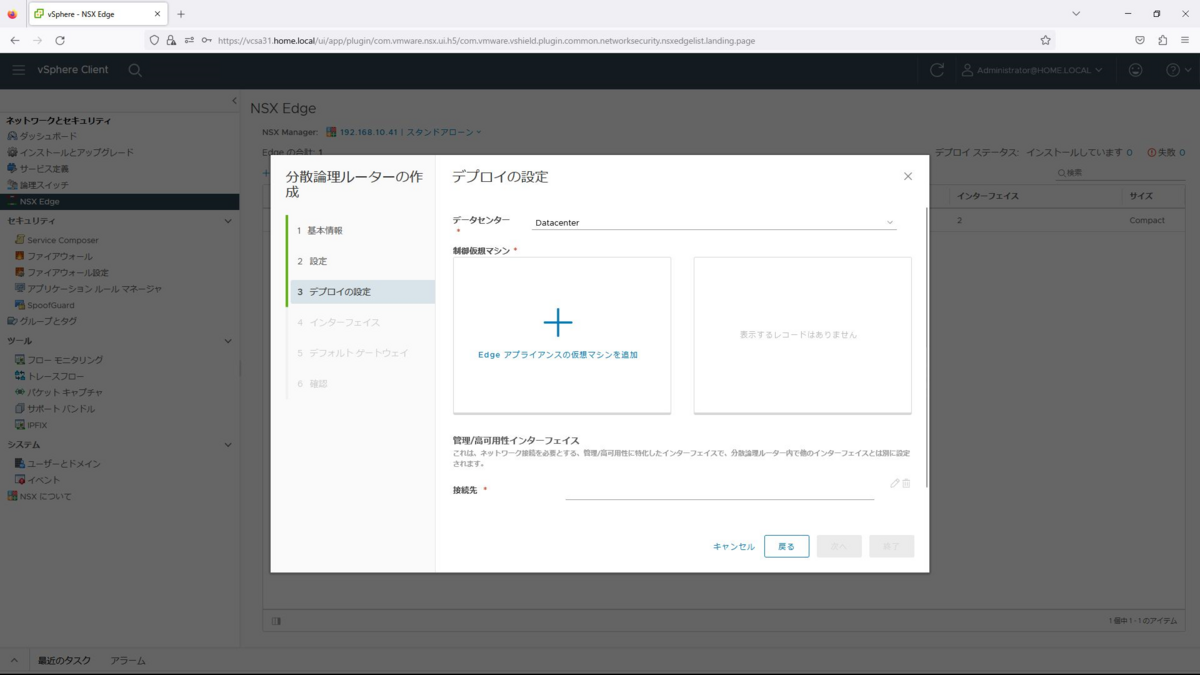

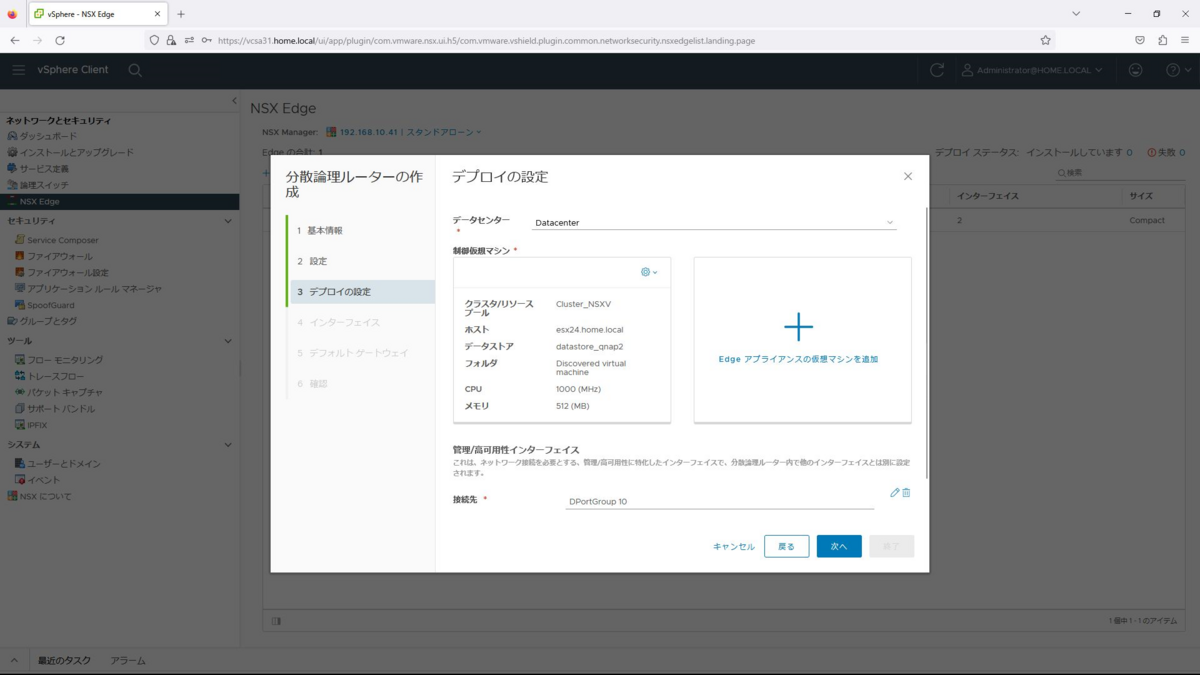

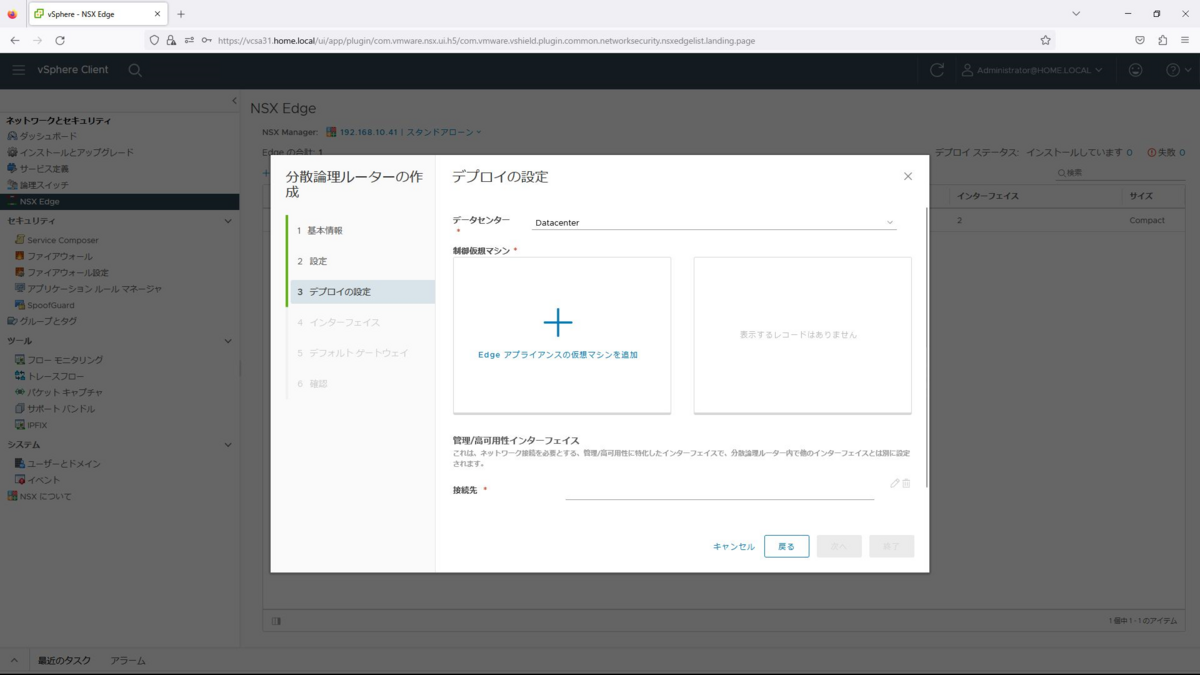

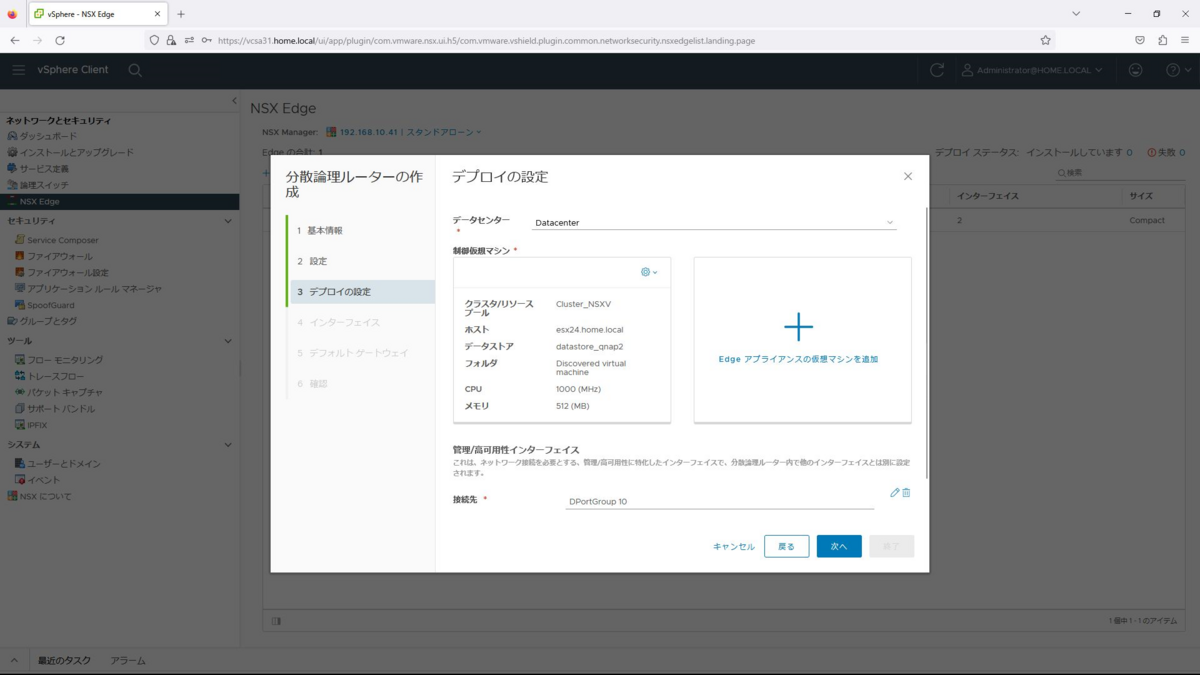

デプロイの設定で、データセンターは「Datacenter」を選択し、「Edgeアプライアンスの仮想マシンを追加」を選択します。

Edgeアプライアンスの配置パラメータで以下を入力し、追加を選択します。

クラスタ/リソース:Cluster_NSXV

データストア:datastore_qnap2

ホスト:esx24.home.local

フォルダ:Discoverd virtual machine

リソースの予約:システム管理

接続先は、「DPortGroup 10」を選択します。

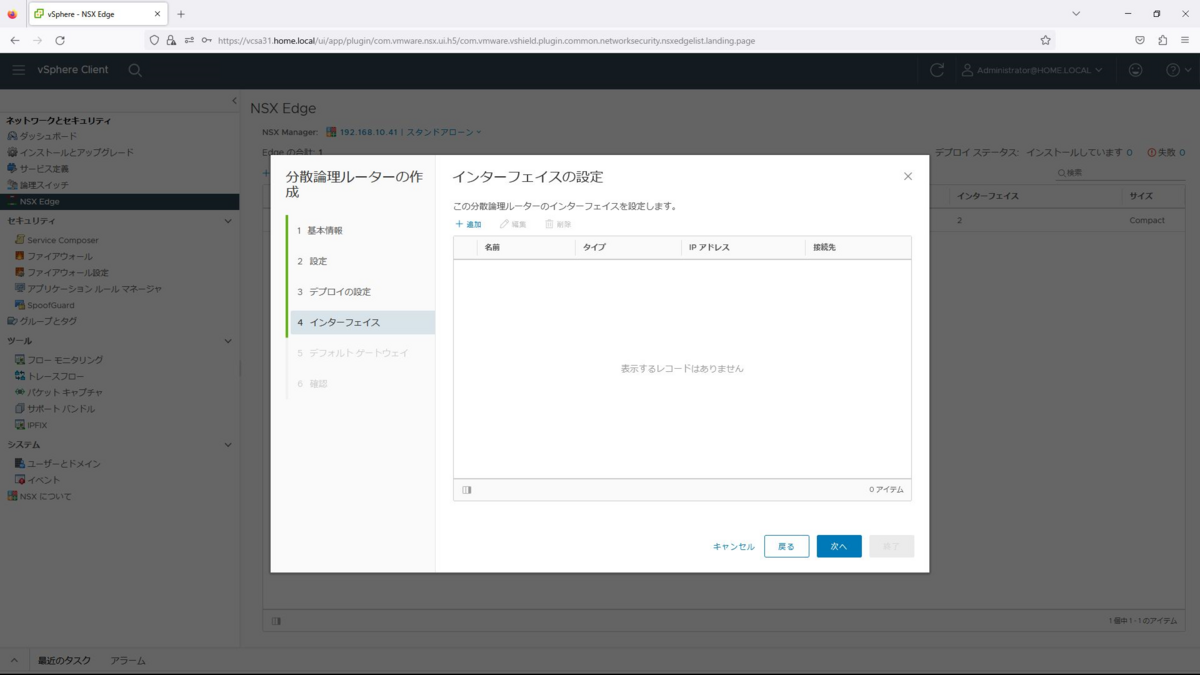

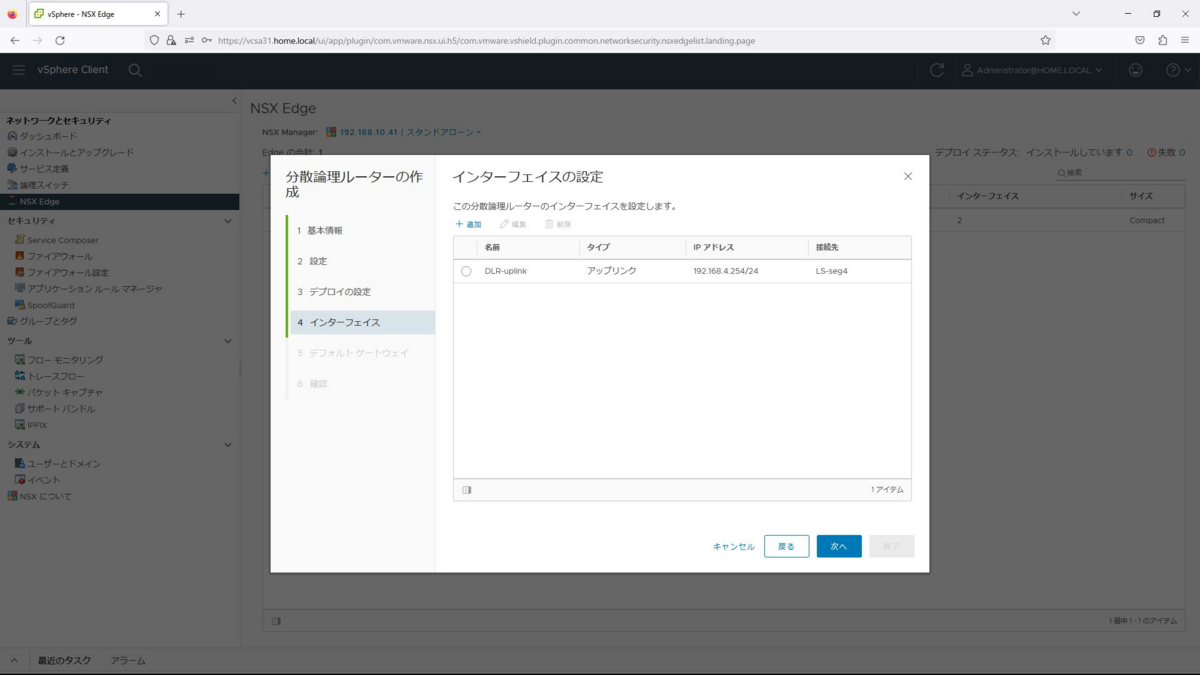

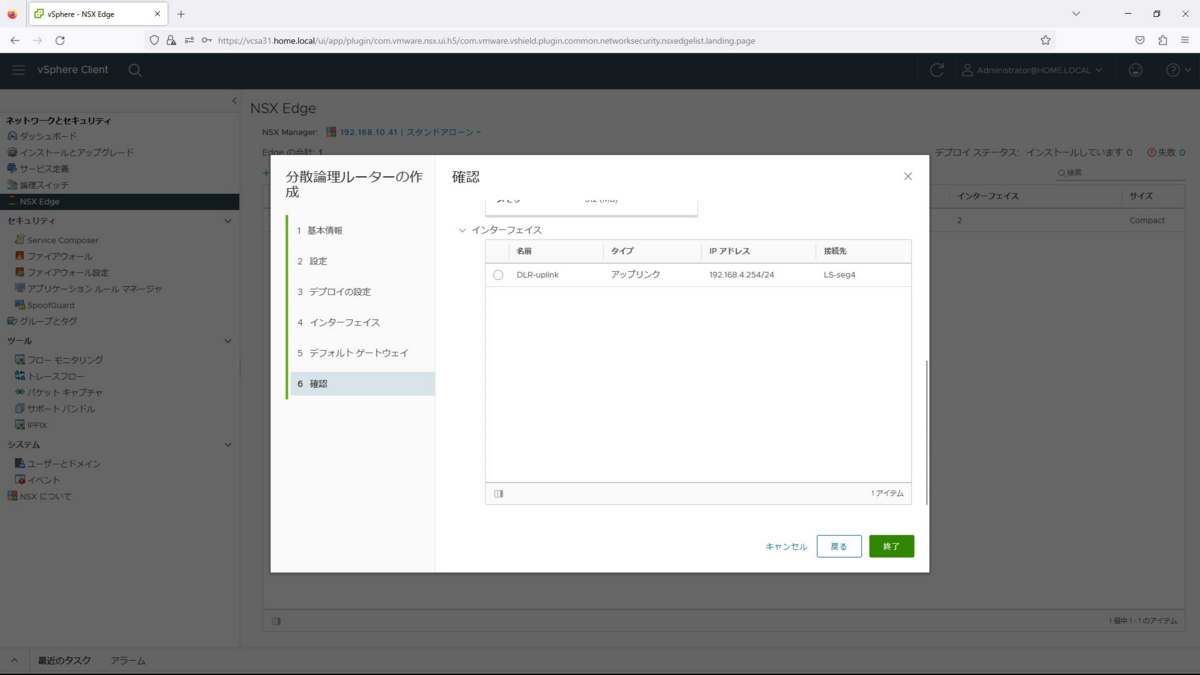

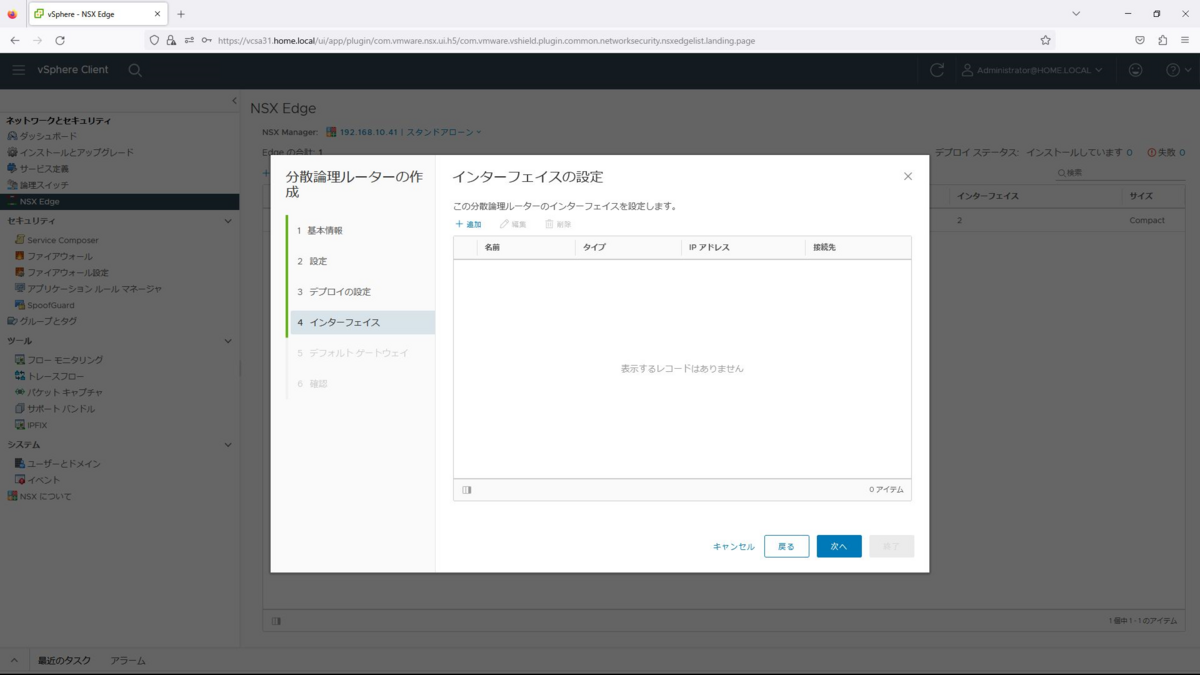

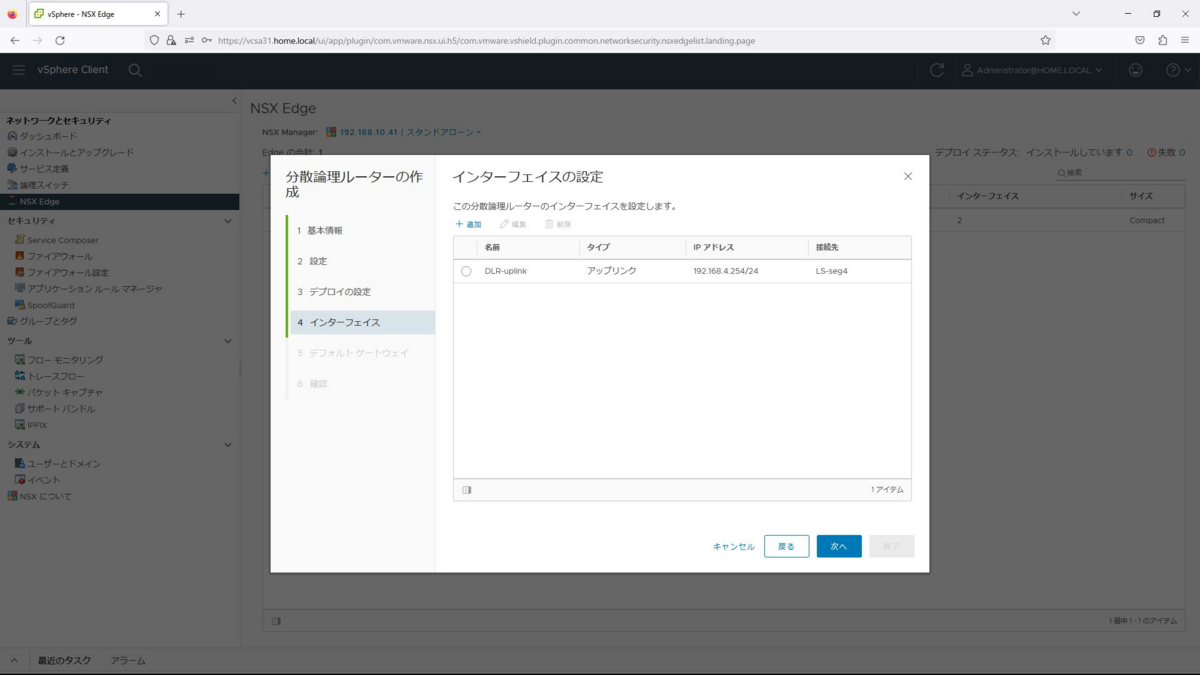

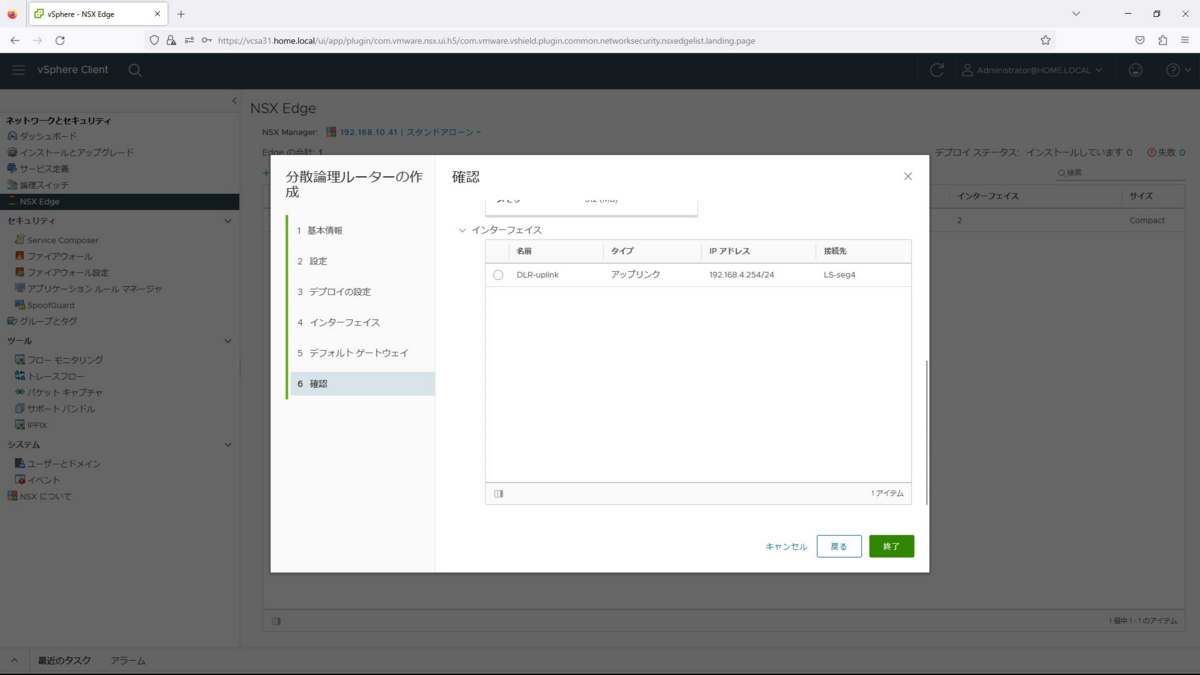

インターフェイスでは追加を選択します。

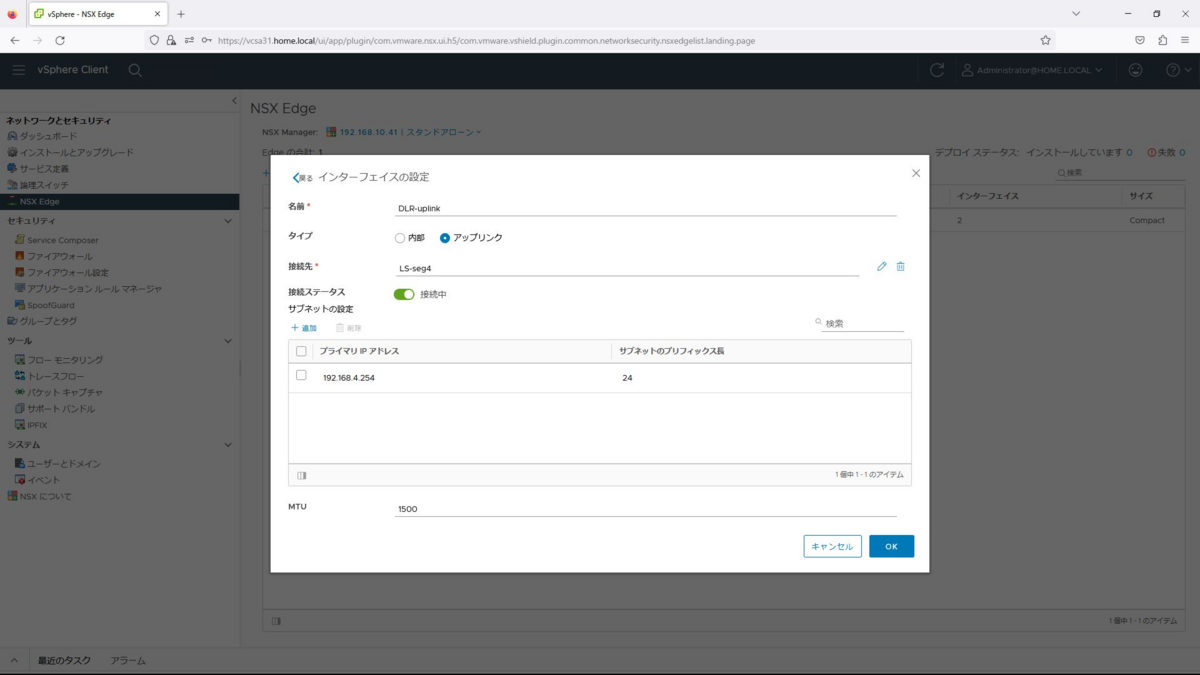

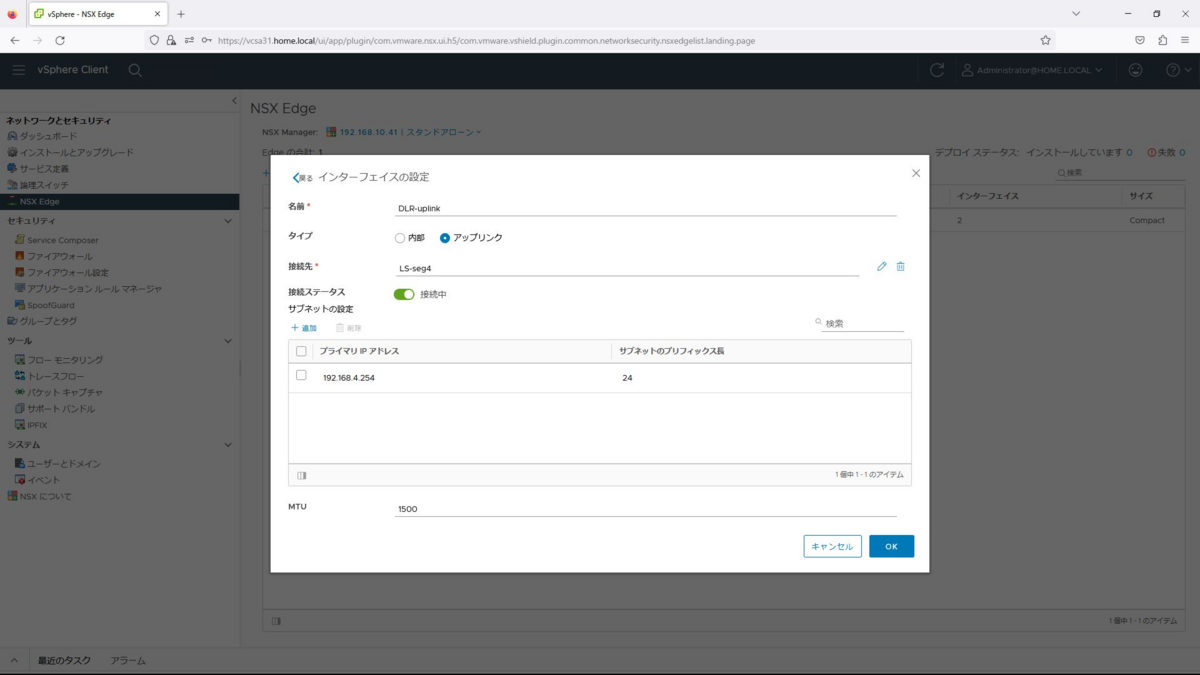

インターフェイスの設定で以下を入力し、OKを選択します。

名前:DLR-uplink

タイプ:アップリンク

接続先:LS-seg4

接続ステータス:接続中

サブネットの設定:192.168.4.254/24

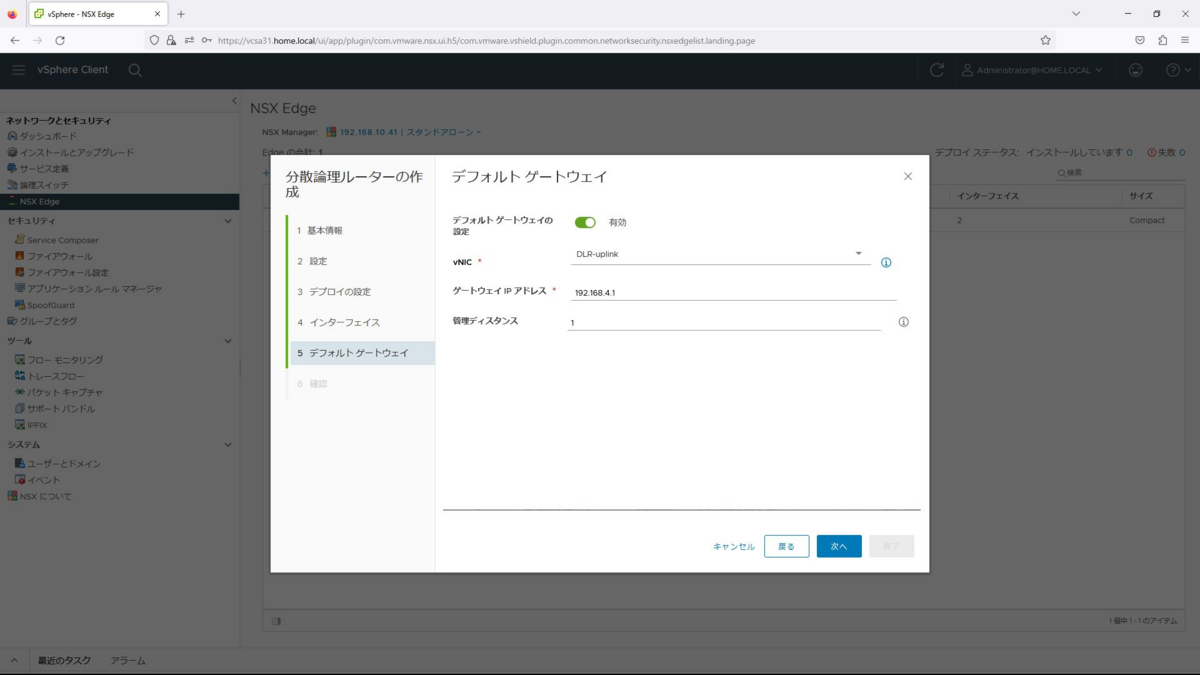

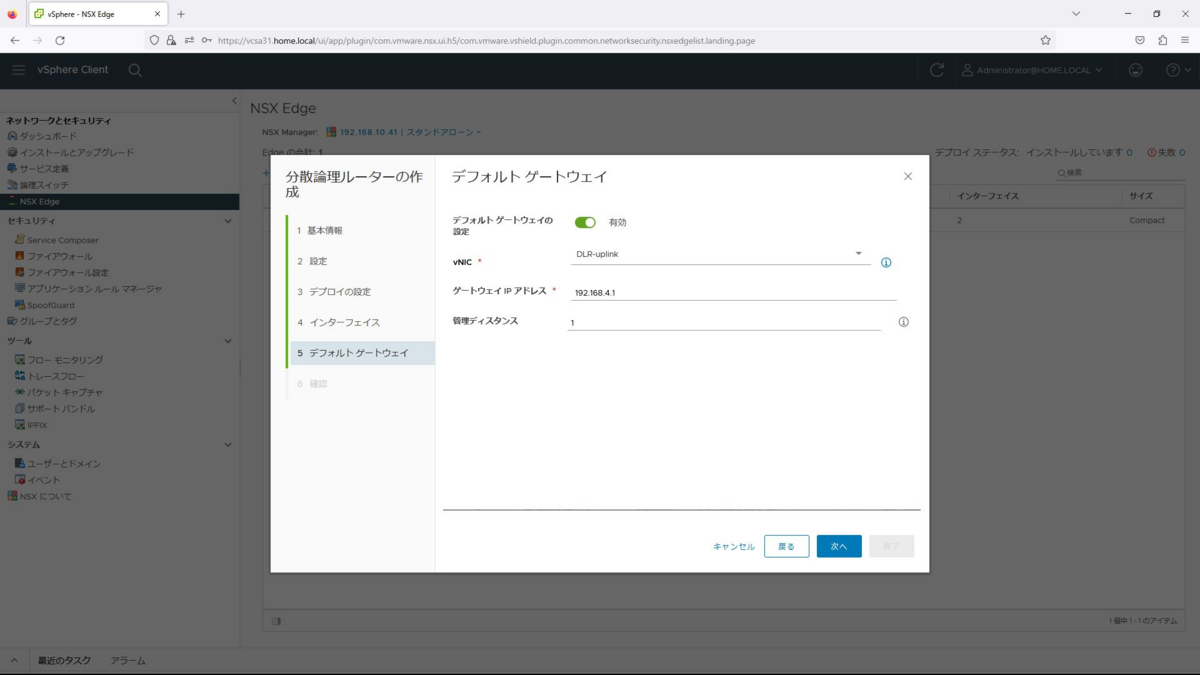

デフォルトゲートウェイを「有効」、vNICを「DLR-uplink」、ゲートウェイIPアドレスを「192.168.4.1」を入力して次へを押下します。

確認して終了を押下するとデプロイが始まり完了するとESGが表示されます。

OSPFの設定

前回構築したホームラボでは、2960-L3がスタティックルーティングのみサポートだったため、動的ルーティングプロトコルの確認ができませんでした。

そこで、今回は、Cisco891を用意して、OSPFによるルーティングを確認してみたいと思います。

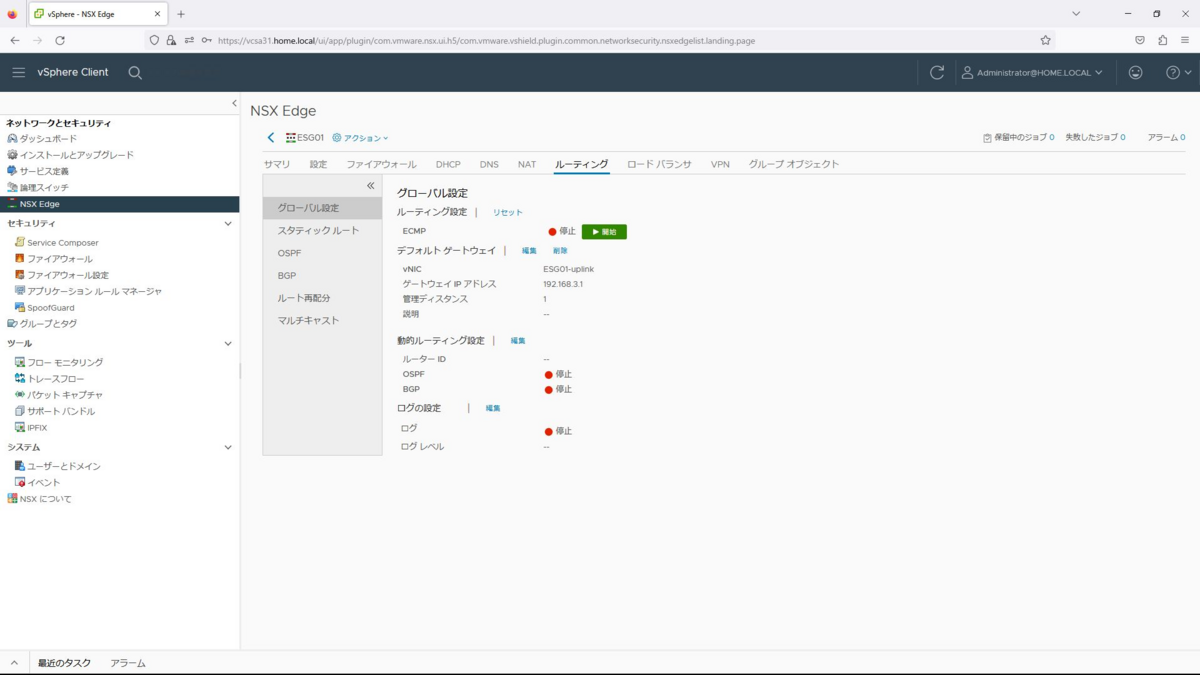

ESG01の設定

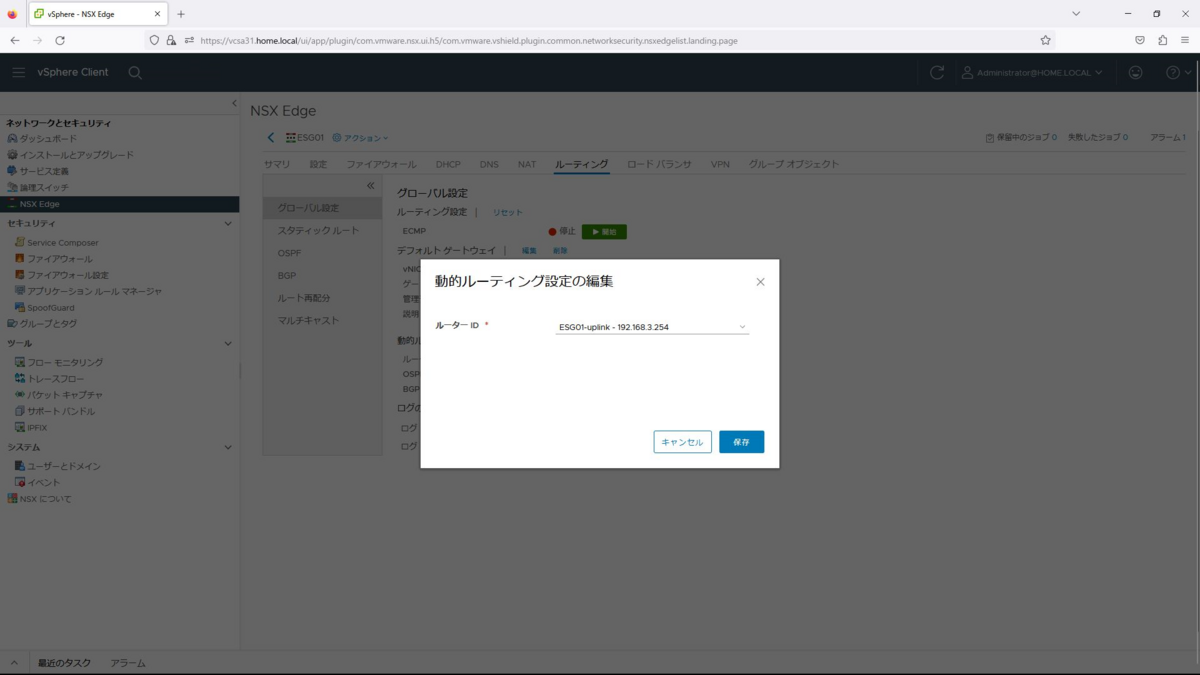

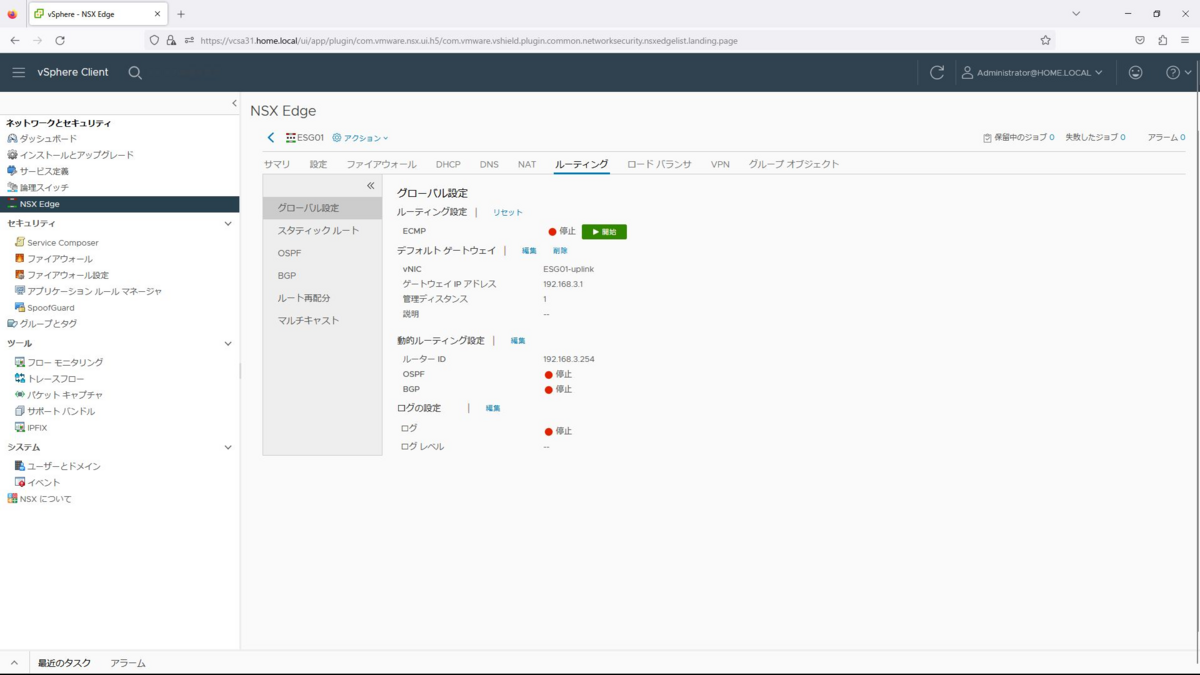

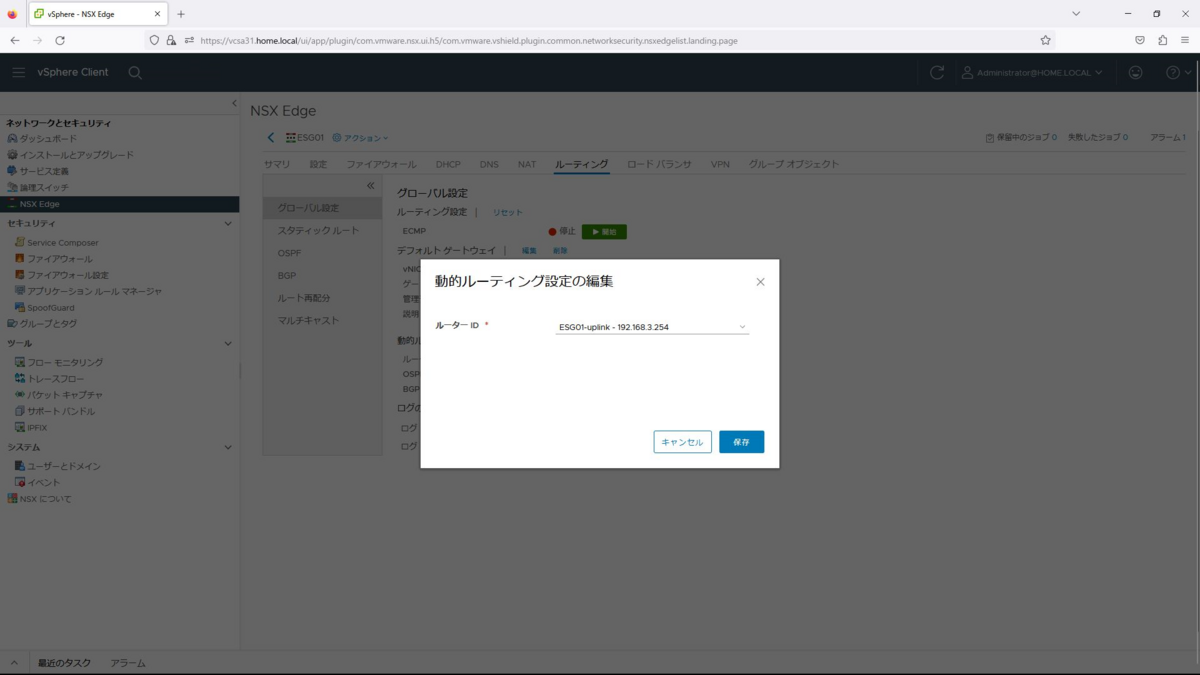

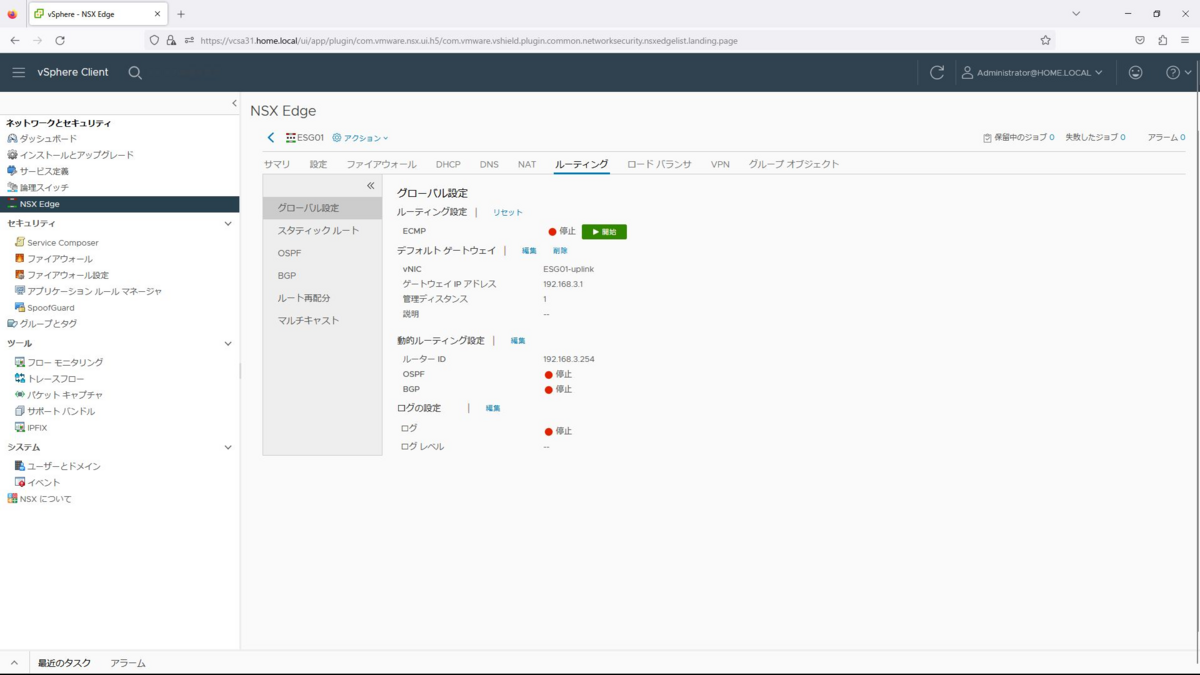

最初に、ESG01の[ルーティング]ー[グローバル設定]から「動的ルーティング設定」を選択します。

ルーターIDとして、アップリンクの192.168.3.254を選択します。

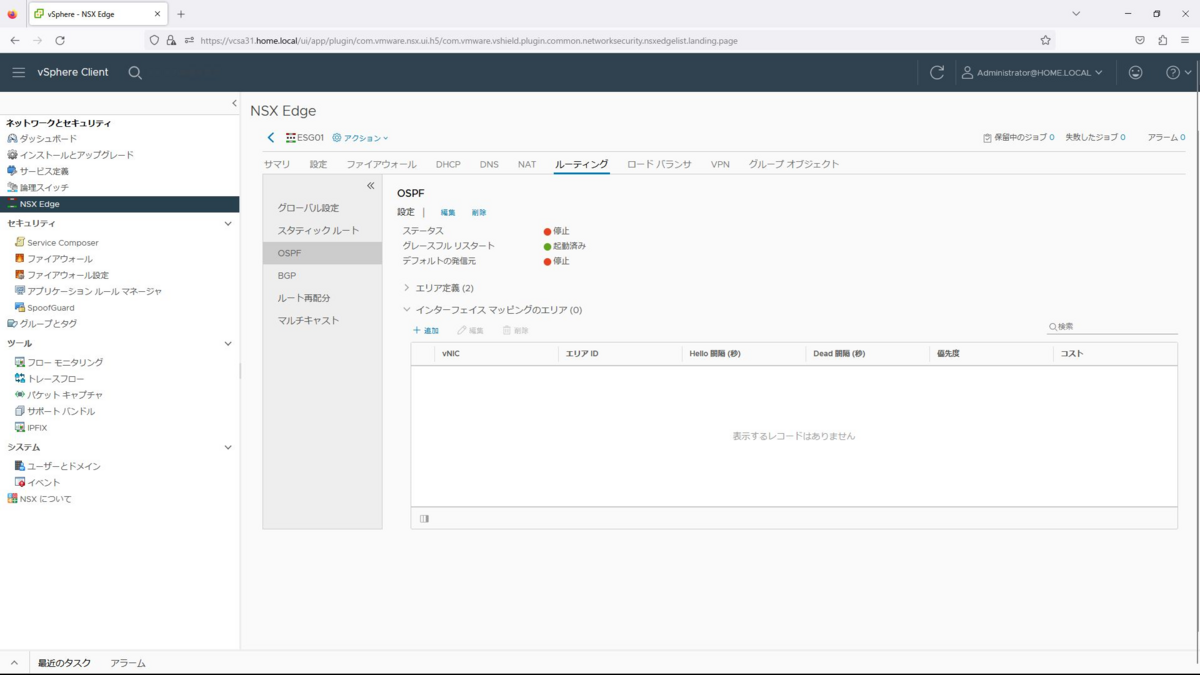

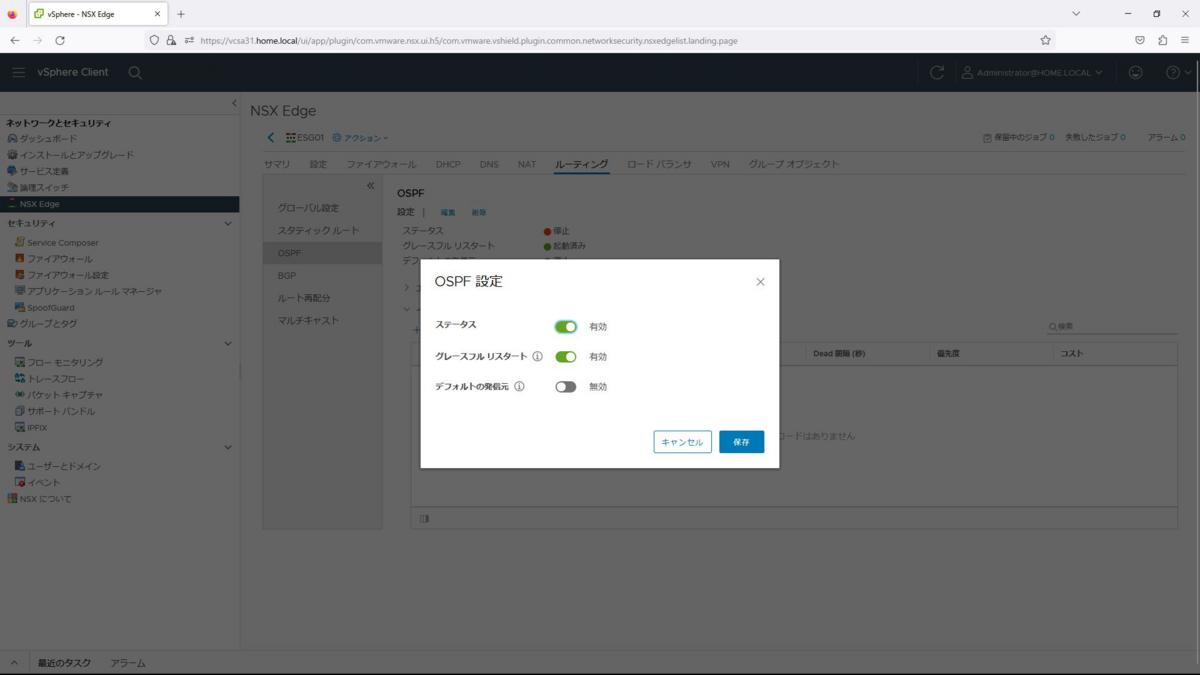

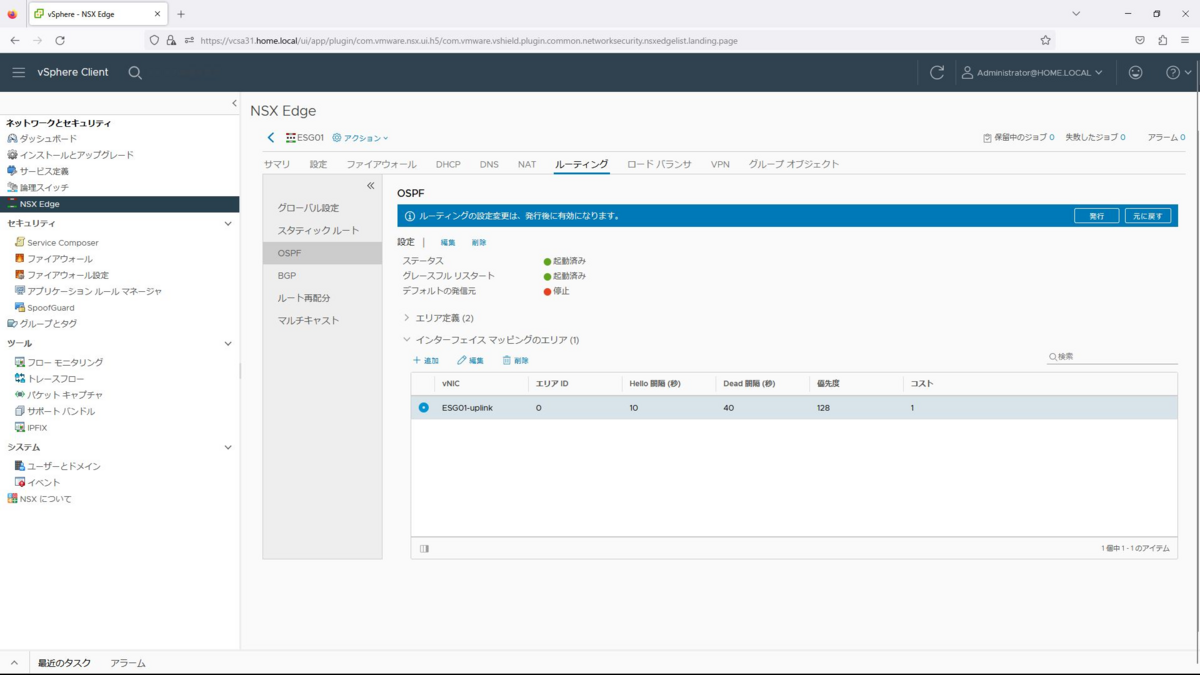

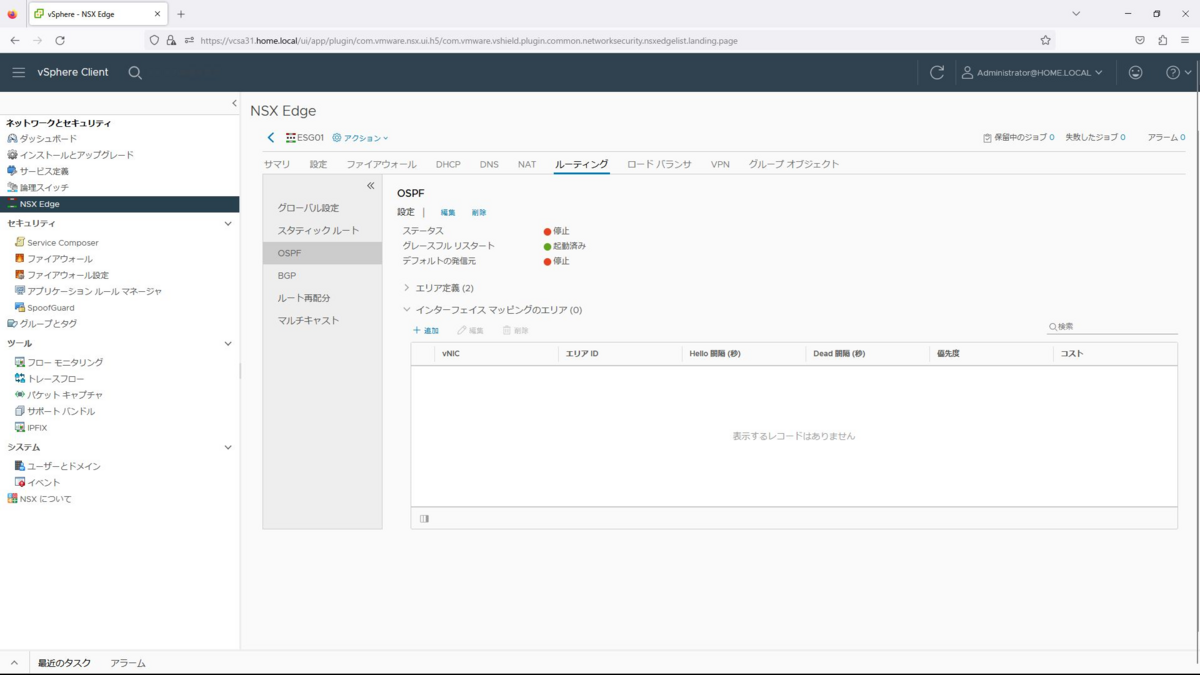

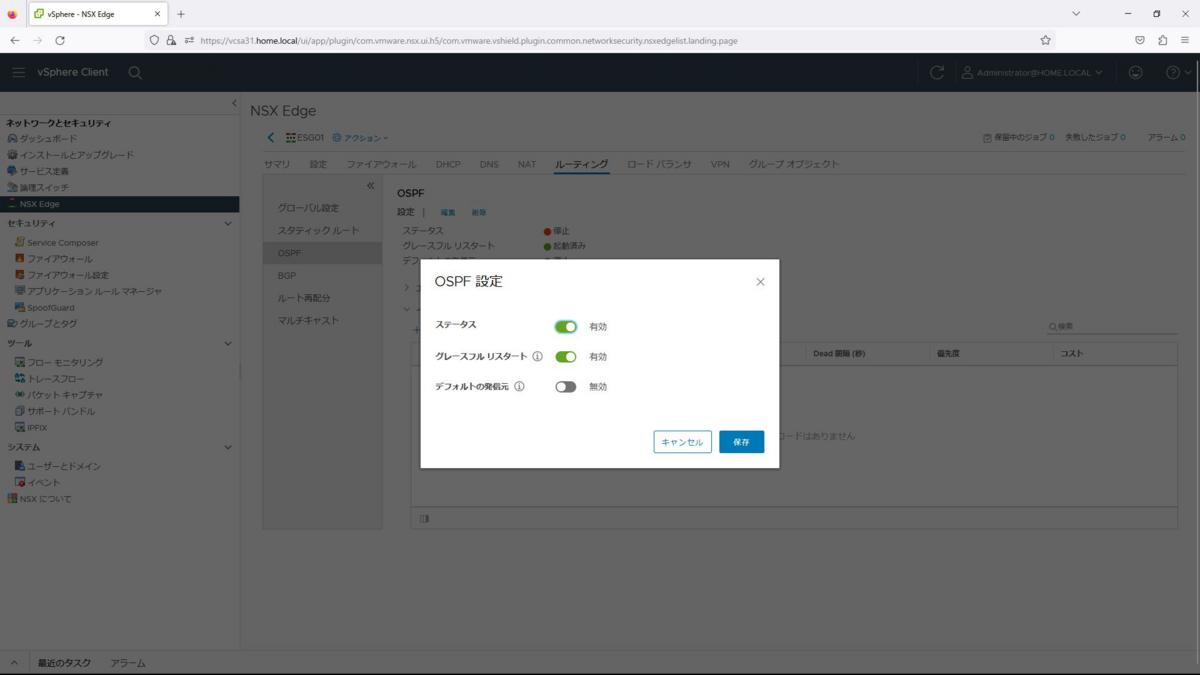

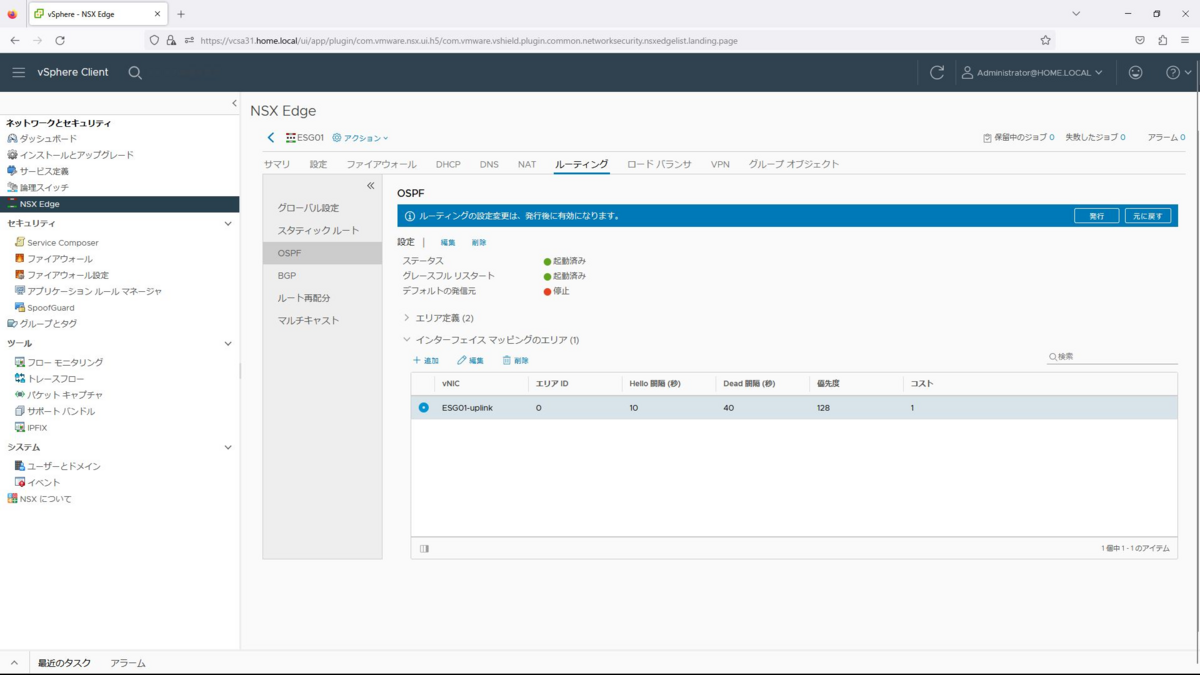

続いて、OSPFの設定から編集を選択します。

ステータスを有効にして、保存を選択します。

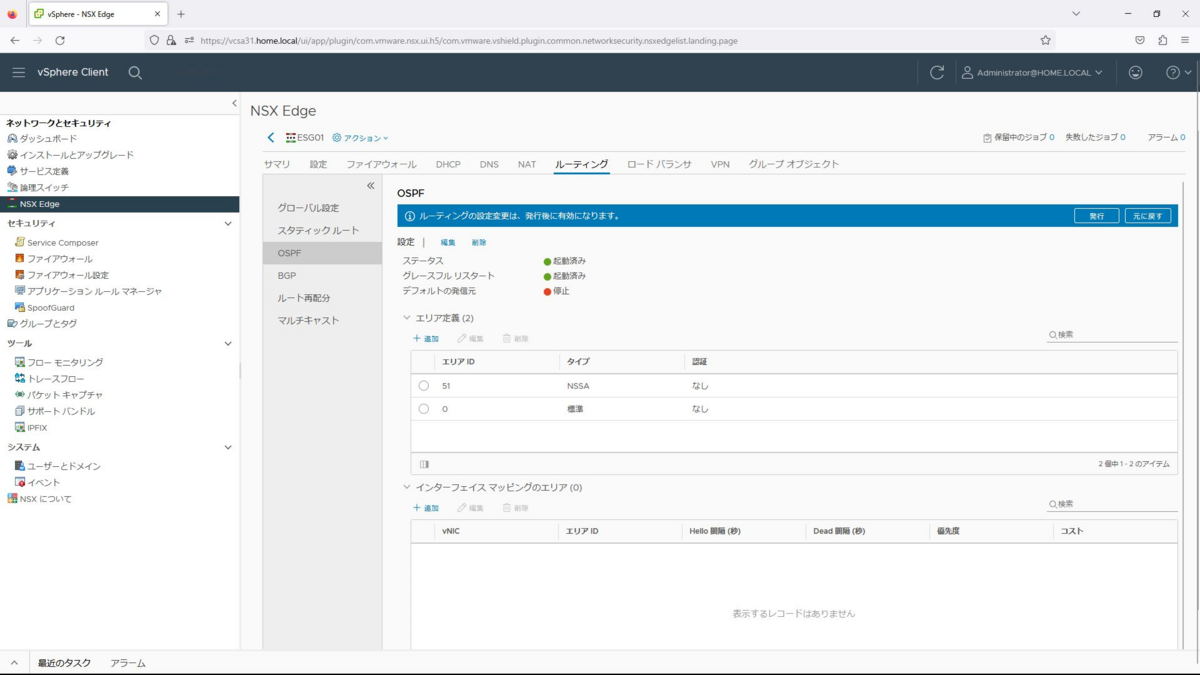

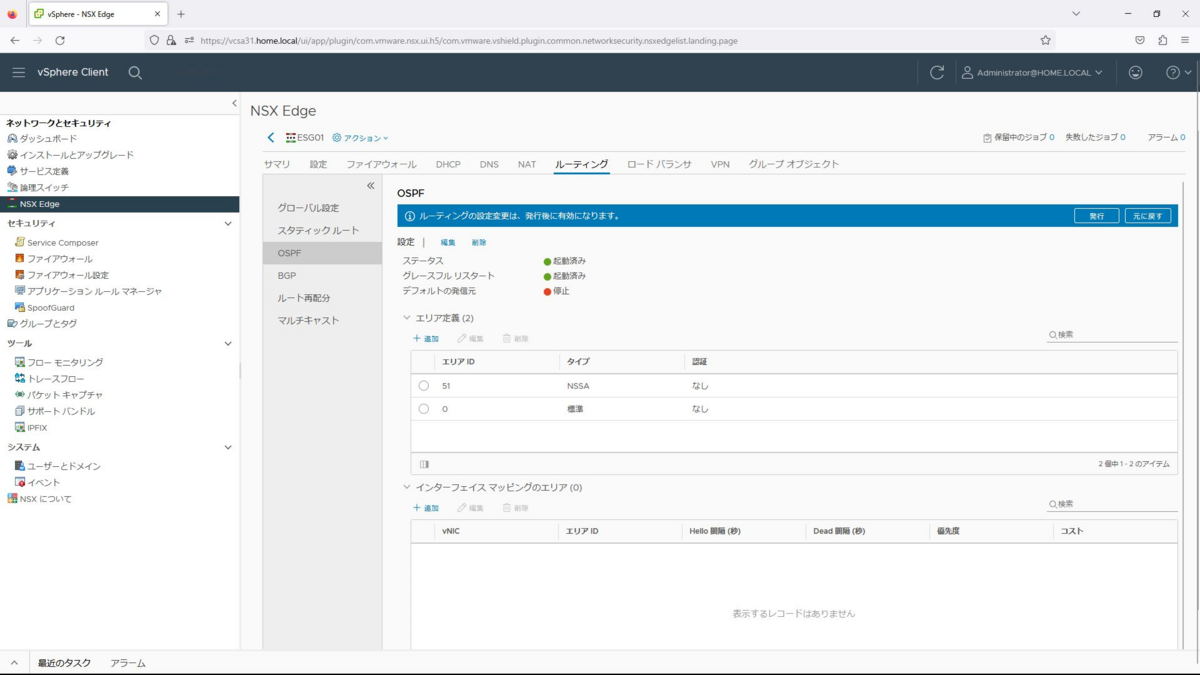

発行ボタンを選択し、有効化します。

なお、エリア定義は、デフォルトで「0」と「51」が設定されているので、「0」の設定をそのまま使用していきます。

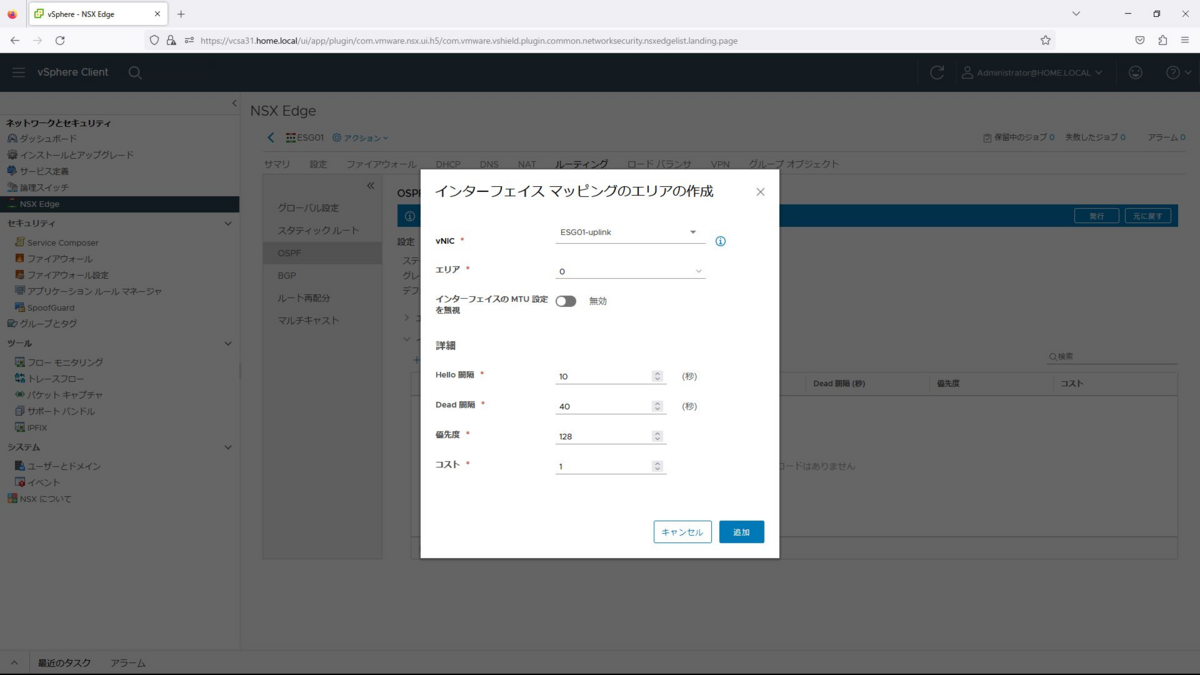

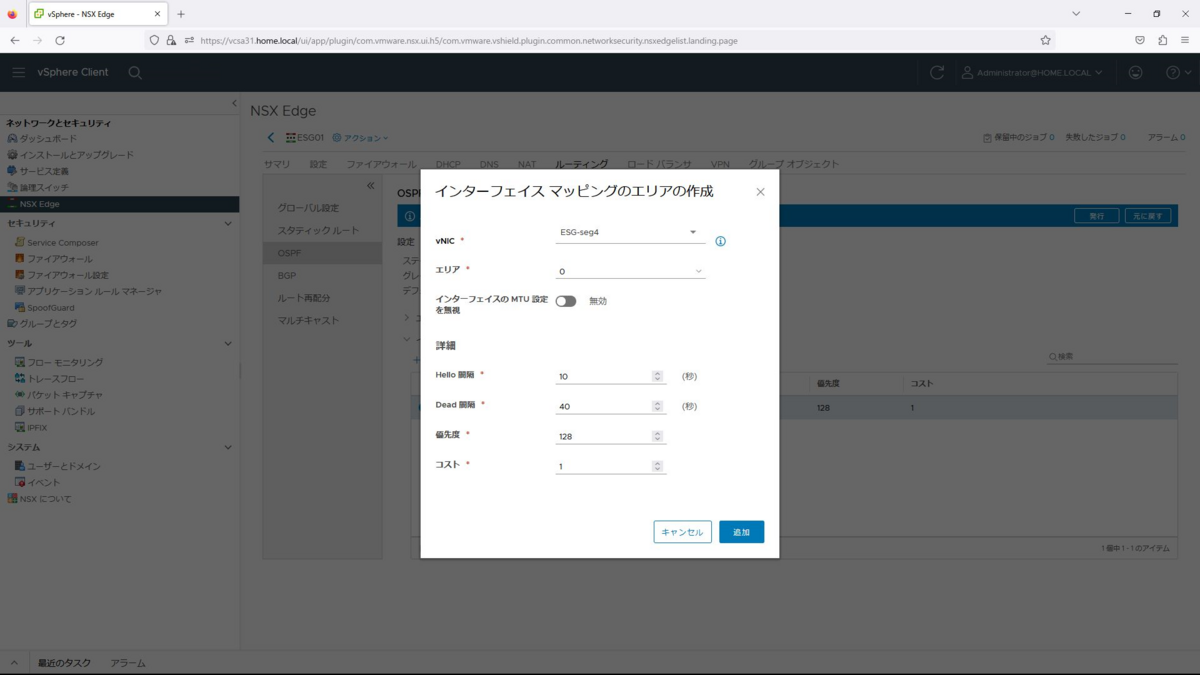

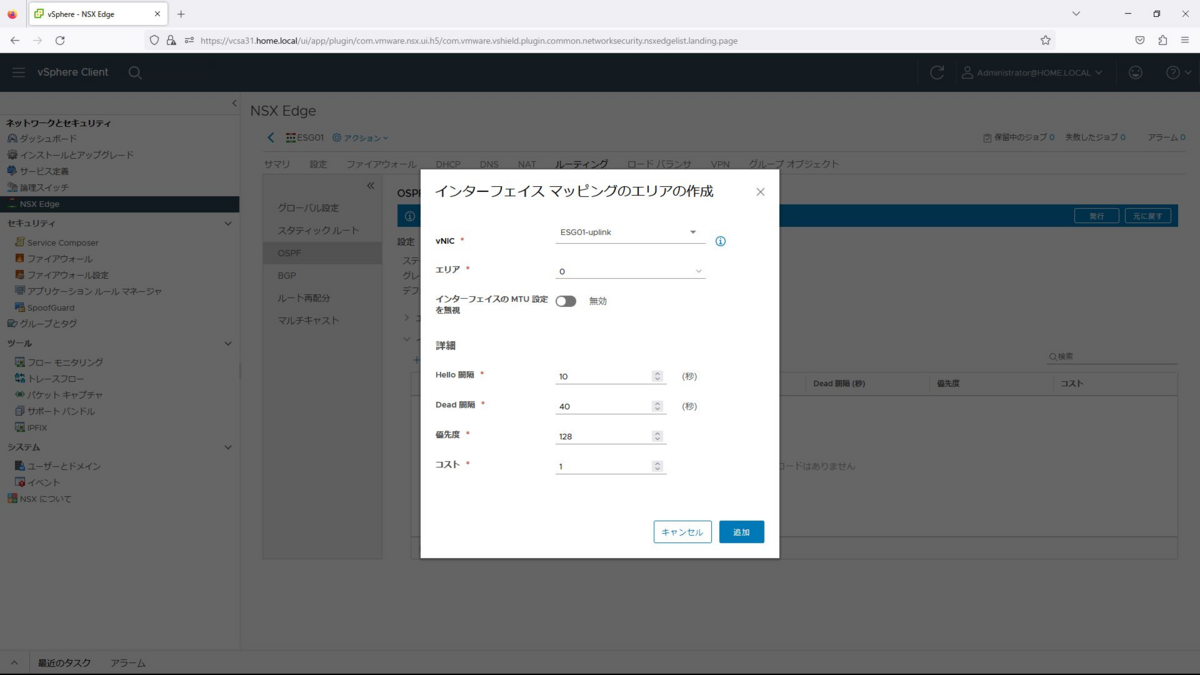

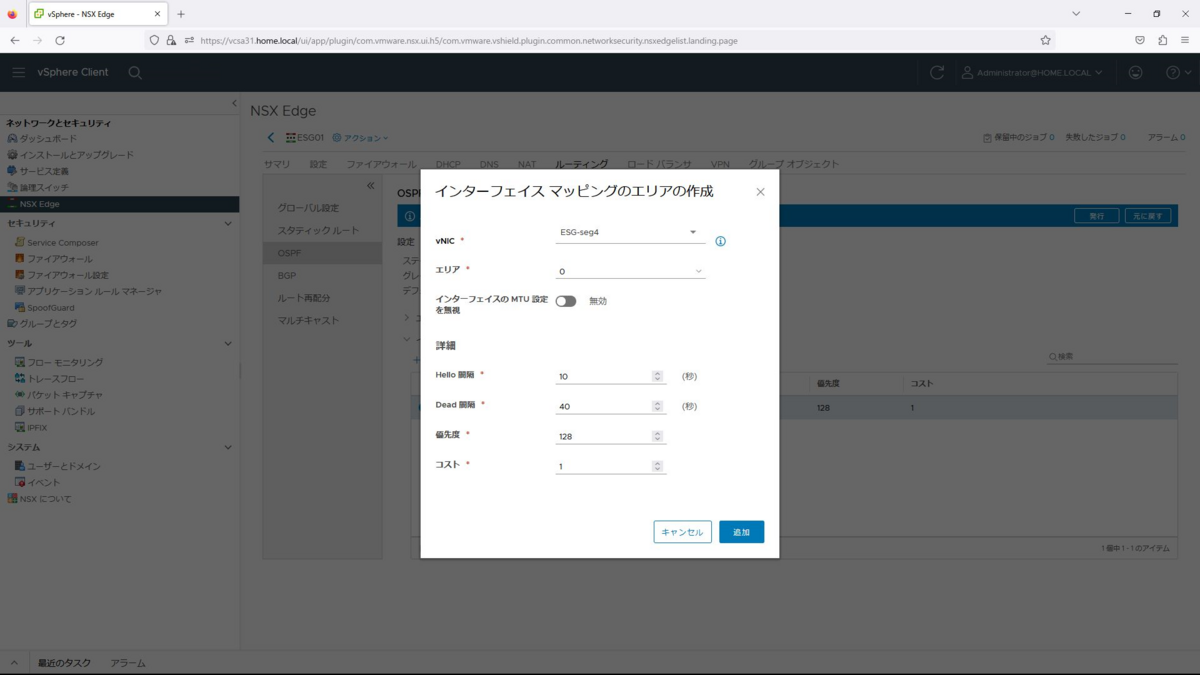

続いて、インターフェイス マッピングのエリアから追加を選択します。

作成画面では、以下を入力します。

vNIC:ESG01-uplink

エリア:0

インターフェイスのMTU設定を無視:無効

Hello間隔:10秒

Dead間隔:40秒

優先度:128

コスト:1

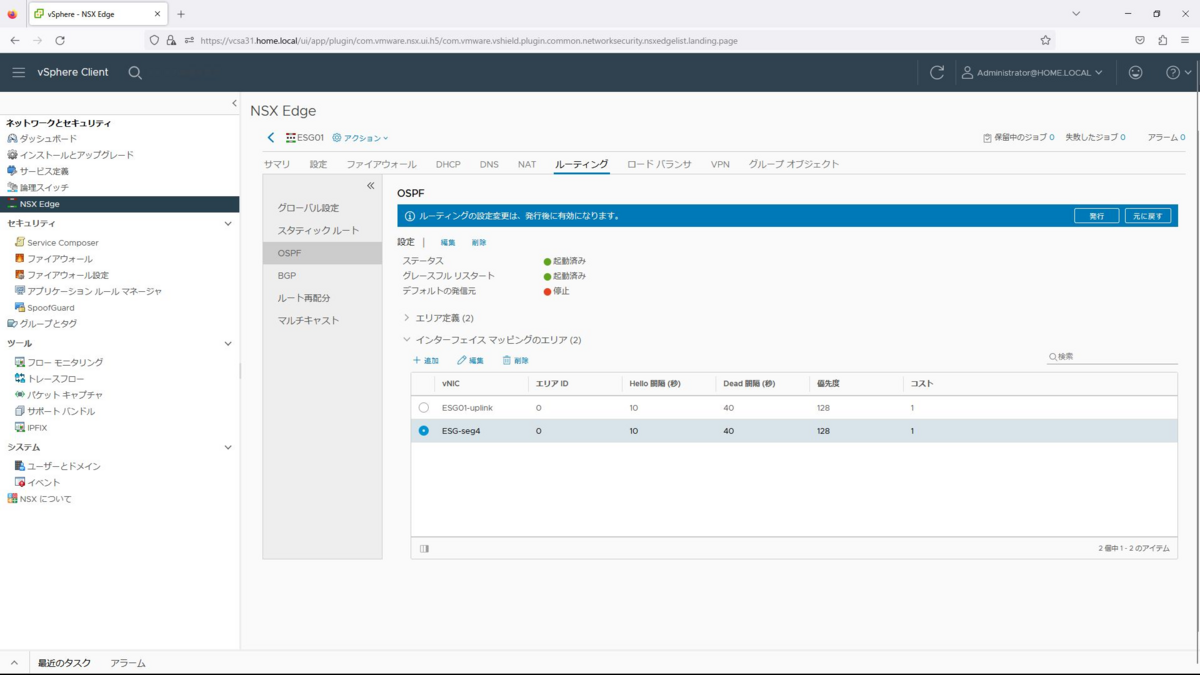

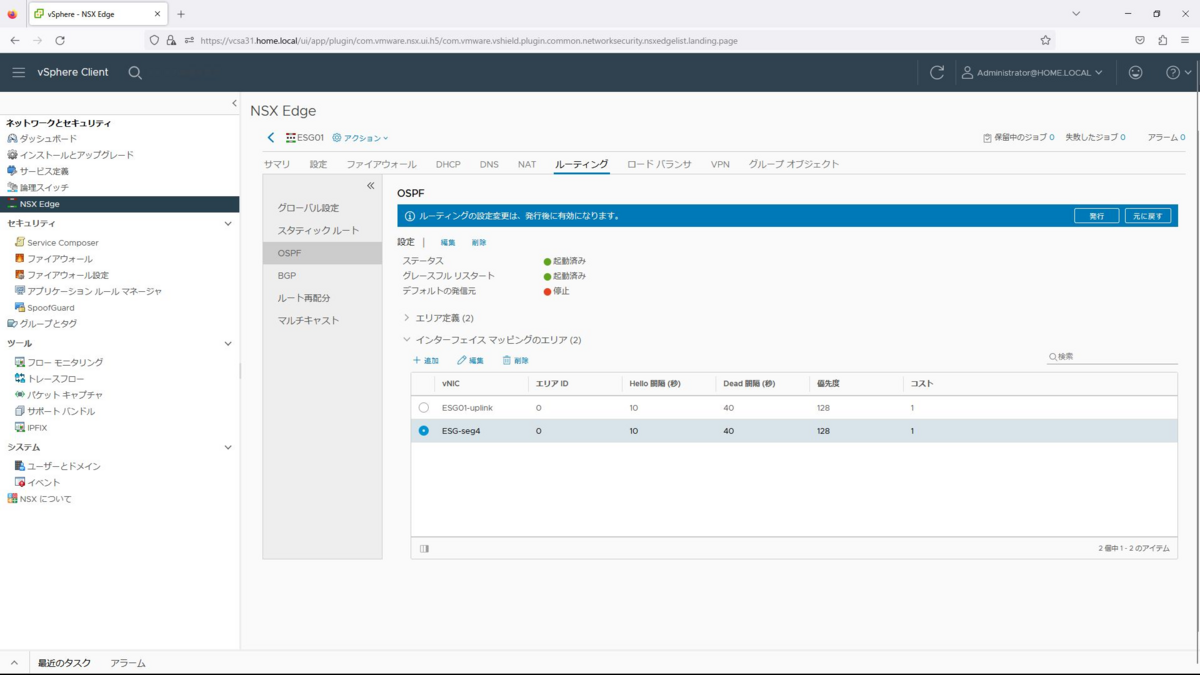

同様に内部リンクも設定します。

vNIC:ESG-seg4

エリア:0

インターフェイスのMTU設定を無視:無効

Hello間隔:10秒

Dead間隔:40秒

優先度:128

コスト:1

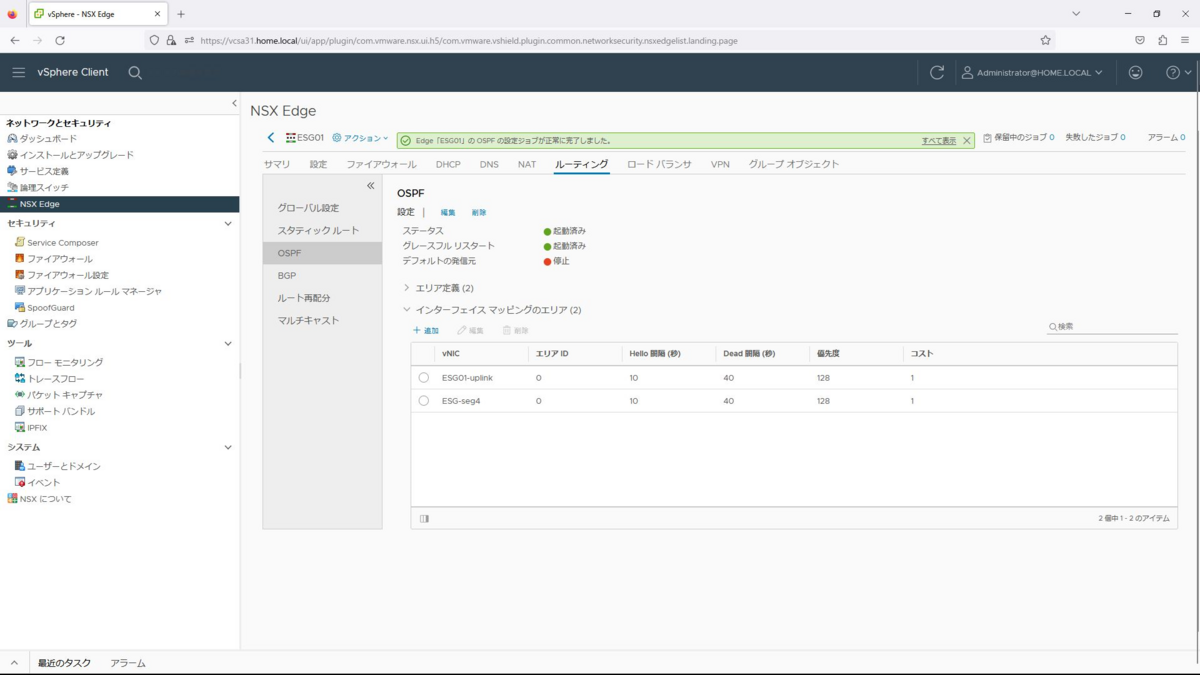

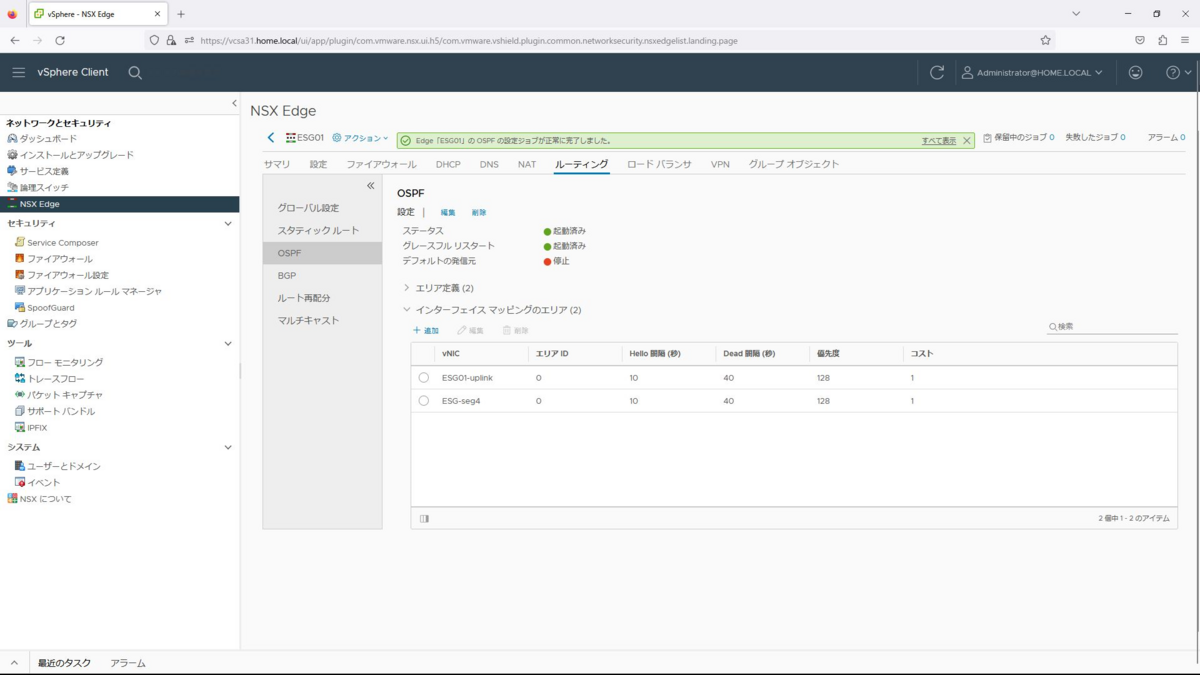

発行ボタンを押下し有効化します。

C891の設定

CiscoルータのVLAN、ルーティングの設定を参考として記載しておきます。

!

interface Vlan3

ip address 192.168.3.2 255.255.255.0

!

interface Vlan100

ip address 192.168.100.254 255.255.255.0

!

router ospf 10

passive-interface Vlan100

network 192.168.3.0 0.0.0.255 area 0

network 192.168.100.0 0.0.0.255 area 0

default-information originate

!

ip route 0.0.0.0 0.0.0.0 192.168.100.1

!

ルーティング確認

C891、ESG01でルーティングテーブルを確認し、ネットワーク情報を送受信していることを確認します。

C891のルーティングテーブル

C891#sh ip route

Codes: L - local, C - connected, S - static, R - RIP, M - mobile, B - BGP

D - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter area

N1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2

E1 - OSPF external type 1, E2 - OSPF external type 2

i - IS-IS, su - IS-IS summary, L1 - IS-IS level-1, L2 - IS-IS level-2

ia - IS-IS inter area, * - candidate default, U - per-user static route

o - ODR, P - periodic downloaded static route, H - NHRP, l - LISP

a - application route

+ - replicated route, % - next hop override, p - overrides from PfR

Gateway of last resort is 192.168.100.1 to network 0.0.0.0

S* 0.0.0.0/0 [1/0] via 192.168.100.1

192.168.3.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.3.0/24 is directly connected, Vlan3

L 192.168.3.2/32 is directly connected, Vlan3

O 192.168.4.0/24 [110/2] via 192.168.3.254, 00:33:55, Vlan3

192.168.100.0/24 is variably subnetted, 2 subnets, 2 masks

C 192.168.100.0/24 is directly connected, Vlan100

L 192.168.100.254/32 is directly connected, Vlan100

O E2 192.168.131.0/24 [110/0] via 192.168.3.254, 00:01:05, Vlan3

C891#

C891#sh ip os nei

Neighbor ID Pri State Dead Time Address Interface

192.168.3.254 128 FULL/BDR 00:00:34 192.168.3.254 Vlan3

C891#

ESG01のルーティングテーブル

ESG01-0# sh ip route

Total number of routes: 5

Codes: O - OSPF derived, i - IS-IS derived, B - BGP derived,

C - connected, S - static, L1 - IS-IS level-1, L2 - IS-IS level-2,

IA - OSPF inter area, E1 - OSPF external type 1, E2 - OSPF external type 2,

N1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2

S 0.0.0.0/0 [1/0] via 192.168.3.1

C 192.168.3.0/24 [0/0] via 192.168.3.254

C 192.168.4.0/24 [0/0] via 192.168.4.1

O 192.168.100.0/24 [110/2] via 192.168.3.2

O E2 192.168.131.0/24 [110/0] via 192.168.4.254

ESG01-0#

ESG01-0# sh ip os nei

NeighborID Pri Address DeadTime State Interface

192.168.100.254 1 192.168.3.2 39 Full/DR/35m54s vNic_0

192.168.4.254 128 192.168.4.253 32 Full/BDR/3m14s vNic_1

ESG01-0#

以上で、NSX-V環境の構築及びオーバーレイネットワークとの通信確認までが完了となります。